引言

在计算机视觉领域,视觉注意力机制一直是研究的热点。传统的视觉注意力模型通常采用自底向上的方法,但这种方法往往难以捕捉到任务相关的关键信息。近期,一种名为AbSViT(Analysis-by-Synthesis Vision Transformer)的创新模型引起了广泛关注。这个模型通过巧妙地结合分析合成(Analysis by Synthesis,AbS)方法和Vision Transformer(ViT)架构,实现了自顶向下的可控视觉注意力机制,在多个计算机视觉任务中展现出了优异的性能。

AbSViT的核心理念

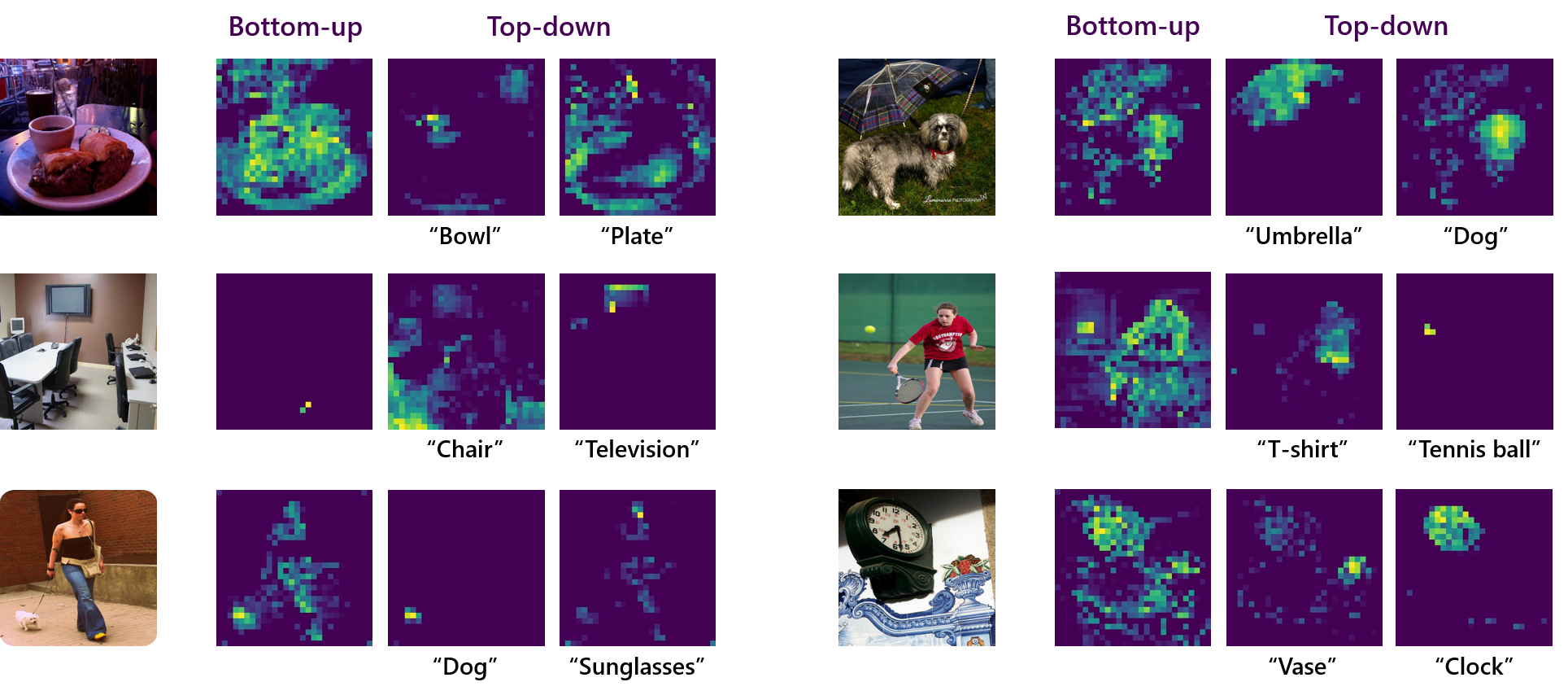

AbSViT的核心理念是将分析合成的思想引入视觉注意力机制。分析合成是一种强大的概念,它通过生成假设并与观察结果比较来理解复杂系统。在视觉任务中,AbSViT利用这一理念,通过自顶向下的方式生成注意力,使模型能够更加精准地聚焦于任务相关的图像区域。

模型架构

AbSViT的架构基于Vision Transformer,但进行了创新性的改进:

-

前馈ViT:首先,输入图像通过标准的ViT前馈网络处理。

-

注意力重加权:输出的token根据与先验token(如任务描述的语言嵌入)的相似度进行重加权。

-

反馈解码器:重加权后的token通过反馈解码器返回到中间层。

-

注意力生成:最后,模型生成自顶向下的注意力图。

这种架构设计使AbSViT能够在保持ViT强大特征提取能力的同时,实现可控的自顶向下注意力机制。

AbSViT的优势

1. 可控性与适应性

AbSViT的一大优势在于其注意力机制的可控性和适应性。通过调整先验token,模型可以根据不同的任务需求灵活地调整注意力分布。这种特性在处理复杂的视觉-语言任务时尤为有用,如视觉问答(VQA)等。

2. 鲁棒性提升

研究表明,AbSViT在面对各种图像扰动时表现出更强的鲁棒性。在ImageNet-C等鲁棒性基准测试中,AbSViT相比传统ViT模型展现出明显的优势。这种增强的鲁棒性使得AbSViT在实际应用中更加可靠。

3. 跨任务迁移能力

AbSViT的设计使其在不同视觉任务间具有出色的迁移能力。无论是图像分类、语义分割还是视觉-语言任务,AbSViT都能展现出优异的性能,这大大增加了模型的实用价值。

应用领域

图像分类

在ImageNet等标准图像分类数据集上,AbSViT展现出了卓越的性能。例如,AbSViT-B模型在ImageNet上达到了81.0%的Top-1准确率,超过了同等规模的ViT-B模型。

语义分割

AbSViT在语义分割任务中同样表现出色。在PASCAL VOC、Cityscapes和ADE20K等数据集上,AbSViT-B模型分别达到了81.3%、76.8%和47.2%的性能,均优于基线ViT模型。

视觉-语言任务

AbSViT在视觉-语言任务中的应用尤为引人注目。特别是在视觉问答(VQA)任务中,AbSViT能够根据不同的问题动态调整其注意力分布,从而更精准地捕捉相关视觉信息。

技术实现

AbSViT的实现基于PyTorch框架,研究者们提供了完整的代码库和预训练模型,方便其他研究者进行复现和进一步研究。以下是一些关键的技术细节:

-

环境配置:

- 需要安装PyTorch 1.7.0+和torchvision 0.8.1+

- 其他依赖可通过

pip install -r requirements.txt安装 - 还需要安装magickwand库:

apt-get install libmagickwand-dev

-

模型训练:

python -m torch.distributed.launch --nproc_per_node=8 --master_port 12345 main.py --model absvit_small_patch16_224 --data-path path/to/imagenet --output_dir output/here --num_workers 8 --batch-size 128 --warmup-epochs 10 -

评估:

python main.py --model absvit_small_patch16_224 --data-path path/to/imagenet --eval --resume path/to/checkpoint -

鲁棒性测试: 可以通过添加

--inc_path,--ina_path,--inr_path或--insk_path参数来测试模型在不同鲁棒性基准上的表现。

未来展望

AbSViT的出现为视觉注意力机制的研究开辟了新的方向。未来的研究可能会集中在以下几个方面:

-

模型效率优化:虽然AbSViT展现出了优异的性能,但其计算复杂度相对较高。未来的研究可能会致力于提高模型的效率,使其更适合在资源受限的环境中应用。

-

多模态融合:AbSViT在视觉-语言任务中的成功为多模态学习提供了新的思路。未来可能会看到更多将AbSViT与其他模态(如音频、文本)结合的尝试。

-

实时应用:随着硬件性能的提升,将AbSViT应用于实时视觉处理任务(如自动驾驶、机器人视觉)可能成为一个重要的研究方向。

-

可解释性研究:AbSViT的自顶向下注意力机制为模型决策提供了更好的可解释性。深入研究这一特性可能会帮助我们更好地理解深度学习模型的决策过程。

结论

AbSViT作为一种创新的视觉注意力模型,通过结合分析合成方法和Vision Transformer架构,实现了自顶向下的可控视觉注意力机制。其在图像分类、语义分割和视觉-语言任务等多个领域的优异表现,以及在鲁棒性方面的提升,展示了这种方法的巨大潜力。

随着研究的深入和技术的进步,我们有理由相信AbSViT及其衍生方法将在计算机视觉领域发挥越来越重要的作用,推动人工智能在视觉理解和处理方面取得新的突破。对于研究者和开发者来说,深入了解和探索AbSViT无疑是一个充满机遇的方向。

📚 相关资源:

🔬 未来研究方向:

- 模型压缩和加速

- 跨模态学习

- 实时视觉处理应用

- 模型可解释性

通过不断的创新和优化,AbSViT有望在计算机视觉的众多应用场景中发挥更大的作用,为智能视觉系统的发展贡献力量。研究者们期待看到更多基于AbSViT的创新应用和突破性研究成果,推动计算机视觉技术向更高水平迈进。