ActionFormer:基于Transformer的行为定位模型

ActionFormer:突破性的视频行为定位模型

随着视频内容的爆炸式增长,如何高效准确地分析和理解视频中的行为动作成为了一个重要的研究课题。近日,来自威斯康星大学麦迪逊分校的研究团队提出了一种名为ActionFormer的创新模型,在视频行为定位任务上取得了突破性进展。

模型创新点

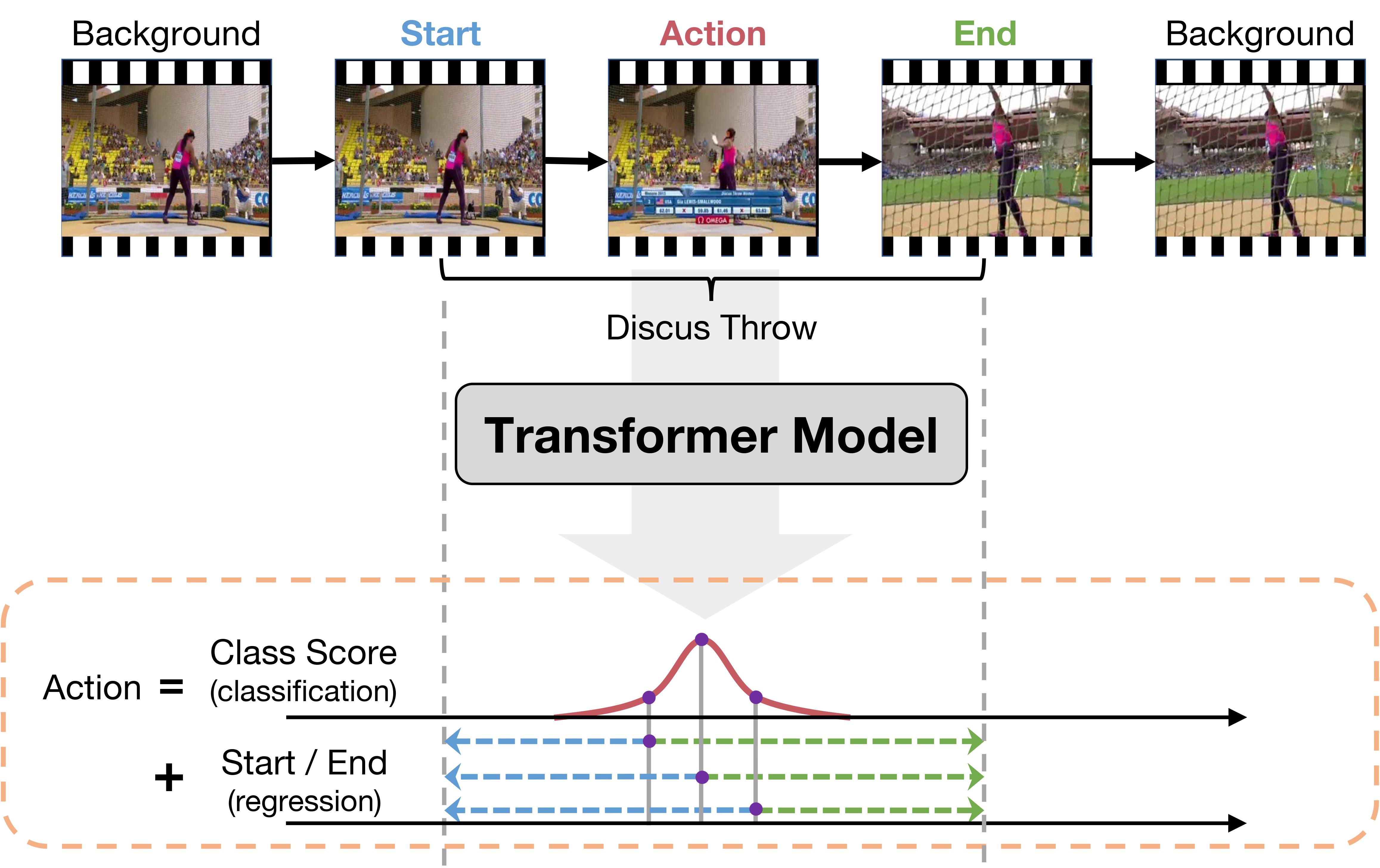

ActionFormer是首批将Transformer架构应用于视频行为定位任务的模型之一。与传统方法不同,ActionFormer采用了极简主义设计理念,巧妙地将Transformer的优势与视频分析的特点相结合:

- 使用局部自注意力机制来建模未剪辑视频中的时序上下文。

- 对输入视频的每个时刻进行分类。

- 回归预测动作的边界。

这种设计使得ActionFormer可以在单次前向传播中直接定位动作片段,无需使用动作建议或预定义的锚框窗口,大大提升了效率。

卓越的性能表现

在多个具有挑战性的视频行为定位基准数据集上,ActionFormer展现出了优异的性能:

- 在THUMOS14数据集上,在tIoU=0.5时达到71.0%的mAP,比此前最好的模型提高了14.1个百分点,首次突破60%的mAP。

- 在ActivityNet 1.3数据集上,平均mAP达到36.56%。

- 在更具挑战性的EPIC-Kitchens 100数据集上,平均mAP比先前的工作提高了13.5%。

此外,ActionFormer还成为了2022年Ego4D时刻查询挑战赛中许多获胜方案的骨干网络。研究团队的提交方案在该挑战赛中排名第二,平均mAP达到21.76%,Recall@1x在tIoU=0.5时达到42.54%,几乎是官方基线的三倍。

广泛的适用性

ActionFormer展现出了良好的通用性和适应性,可以与多种特征提取器配合使用:

- 在THUMOS14上使用I3D特征

- 在ActivityNet上使用TSP特征和I3D特征

- 在EPIC-Kitchens上使用SlowFast特征

- 在Ego4D上结合使用SlowFast、Omnivore和EgoVLP特征

这种灵活性使得ActionFormer可以适应不同的应用场景和数据特点。

开源代码促进研究

为了推动该领域的研究进展,研究团队在GitHub上开源了ActionFormer的完整代码实现。代码结构清晰,主要包括:

- ./libs/core:参数配置模块

- ./libs/datasets:数据加载和IO模块

- ./libs/modeling:主模型及其所有构建块

- ./libs/utils:训练、推理和后处理的实用函数

研究团队还提供了详细的使用说明,包括如何在各个数据集上重现论文中的结果,以及如何使用预训练模型进行评估。这为其他研究者复现结果和进一步改进模型提供了极大便利。

未来展望

ActionFormer的成功标志着视频理解领域的一个重要里程碑。未来,研究团队计划进一步优化模型,探索在更多视频分析任务中的应用。随着深度学习和计算机视觉技术的不断进步,我们有理由相信,更加智能和高效的视频分析系统将会不断涌现,为人类理解和利用海量视频信息带来革命性变革。

总的来说,ActionFormer凭借其创新的设计和卓越的性能,为视频行为定位任务开辟了新的研究方向。它不仅推动了学术界的技术进步,也为视频监控、人机交互等实际应用带来了新的可能。我们期待看到更多基于ActionFormer的创新应用在未来涌现。

编辑推荐精选

讯飞智文

一键生成PPT和Word,让学习生活更轻松

讯飞智文是一个利用 AI 技术的项目,能够帮助用户生成 PPT 以及各类文档。无论是商业领域的市场分析报告、年度目标制定,还是学生群体的职业生涯规划、实习避坑指南,亦或是活动策划、旅游攻略等内容,它都能提供支持,帮助用户精准表达,轻松呈现各种信息。

讯飞星火

深度推理能力全新升级,全面对标OpenAI o1

科大讯飞的星火大模型,支持语言理解、知识问答和文本创作等多功能,适用于多种文件和业务场景,提升办公和日常生活的效率。讯飞星火是一个提供丰富智能服务的平台,涵盖科技资讯、图像创作、写作辅助、编程解答、科研文献解读等功能,能为不同需求的用户提供便捷高效的帮助,助力用户轻松获取信息、解决问题,满足多样化使用场景。

Spark-TTS

一种基于大语言模型的高效单流解耦语音令牌文本到语音合成模型

Spark-TTS 是一个基于 PyTorch 的开�源文本到语音合成项目,由多个知名机构联合参与。该项目提供了高效的 LLM(大语言模型)驱动的语音合成方案,支持语音克隆和语音创建功能,可通过命令行界面(CLI)和 Web UI 两种方式使用。用户可以根据需求调整语音的性别、音高、速度等参数,生成高质量的语音。该项目适用于多种场景,如有声读物制作、智能语音助手开发等。

Trae

字节跳动发布的AI编程神器IDE

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

咔片PPT

AI助力,做PPT更简单!

咔片是一款轻量化在线演示设计工具,借助 AI 技术,实现从内容生成到智能设计的一站式 PPT 制作服务。支持多��种文档格式导入生成 PPT,提供海量模板、智能美化、素材替换等功能,适用于销售、教师、学生等各类人群,能高效制作出高品质 PPT,满足不同场景演示需求。

讯飞绘文

选题、配图、成文,一站式创作,让内容运营更高效

讯飞绘文,一个AI集成平台,支持写作、选题、配图、排版和发布。高效生成适用于各类媒体的定制内容,加速品牌传播,提升内容营销效果。

材料星

专业的AI公文写作平台,公文写作神器

AI 材料星,专业的 AI 公文写作辅助平台,为体制内工作人员提供高效的公文写作解决方案。拥有海量公文文库、9 大核心 AI 功能,支持 30 + 文稿类型生成,助力快速完成领导讲话、工作总结、述职报告等材料,提升办公效率,是体制打工人的得力写作神器。

openai-agents-python

OpenAI Agents SDK,助力开发者便捷使用 OpenAI 相关功能。

openai-agents-python 是 OpenAI 推出的一款强大 Python SDK,它为开发者提供了与 OpenAI 模型交互的高效工具,支持工具调用、结果处理、追踪等功能,涵盖多种应用场景,如研究助手、财务研究等,能显著提升开发效率,让开发者更轻松地利用 OpenAI 的技术优势。

Hunyuan3D-2

高分辨率纹理 3D 资产生成

Hunyuan3D-2 是腾讯开发的用于 3D 资产生成的强大工具,支持从文本描述、单张图片或多视角图片生成 3D 模型,具备快速形状生成能力,可生成带纹理的高质量 3D 模型,适用于多个领域,为 3D 创作提供了高效解决方案。

3FS

一个具备存储、管理和客户端操作等多种功能的分布式文件系统相关项目��。

3FS 是一个功能强大的分布式文件系统项目,涵盖了存储引擎、元数据管理、客户端工具等多个模块。它支持多种文件操作,如创建文件和目录、设置布局等,同时具备高效的事件循环、节点选择和协程池管理等特性。适用于需要大规模数据存储和管理的场景,能够提高系统的性能和可靠性,是分布式存储领域的优质解决方案。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号