AdalFlow: 革新LLM应用开发的利器

在人工智能和自然语言处理领域,大型语言模型(LLM)的应用日益广泛。然而,如何高效地构建和优化LLM任务一直是开发者面临的挑战。AdalFlow应运而生,它是一个强大的开源库,旨在简化LLM应用的开发过程,并提供自动优化功能。本文将深入探讨AdalFlow的特性、优势以及它如何改变LLM应用的开发方式。

AdalFlow的核心优势

AdalFlow的设计理念源自PyTorch,这使得它具有轻量级、模块化和强大的特点。以下是AdalFlow的主要优势:

-

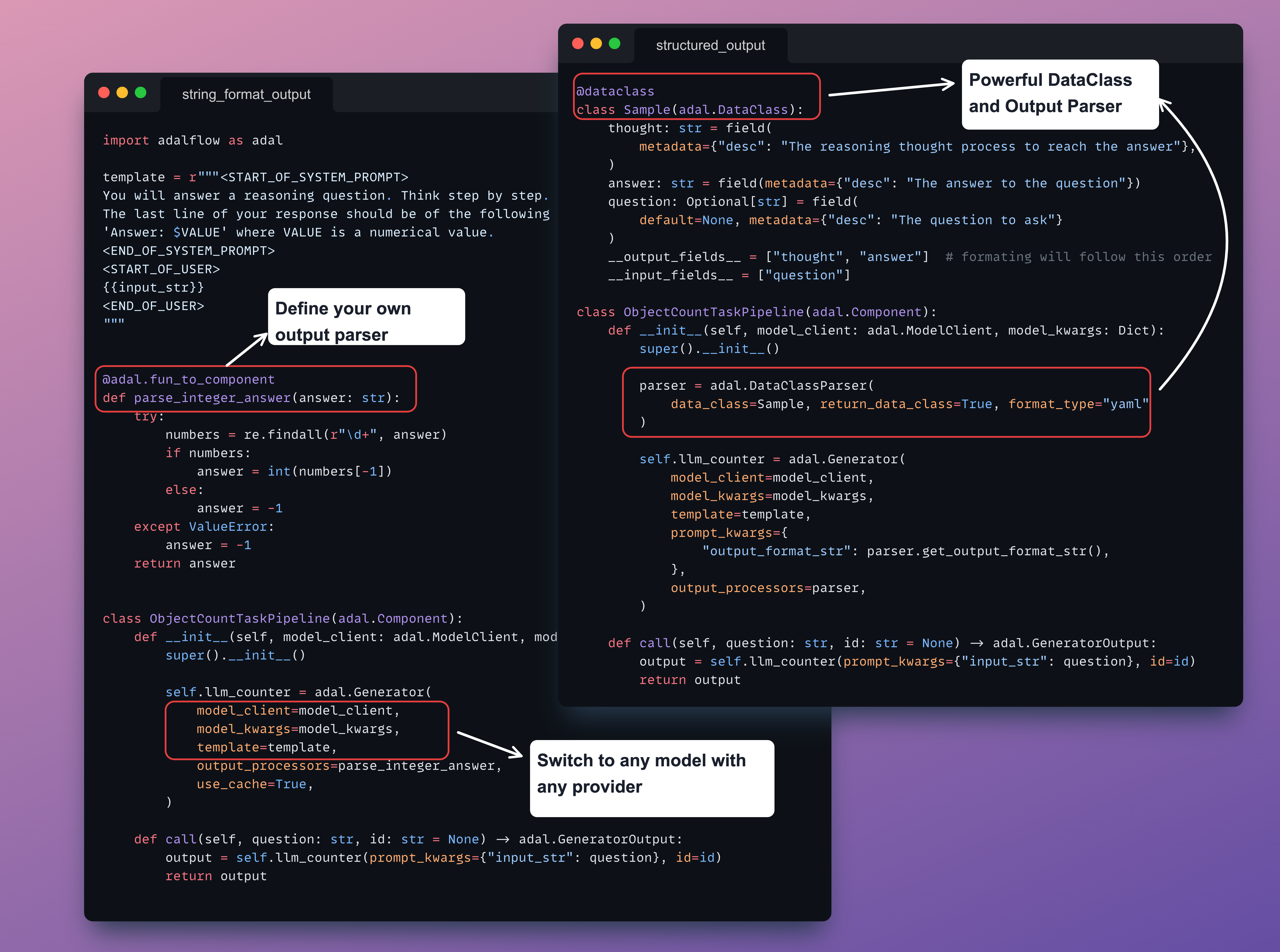

模型无关的构建模块: AdalFlow提供了一系列模型无关的构建模块,可用于构建各种LLM任务管道,包括检索增强生成(RAG)、智能代理,以及传统的自然语言处理任务如文本分类和命名实体识别。即使只使用基本的手动提示,也能轻松获得高性能。

-

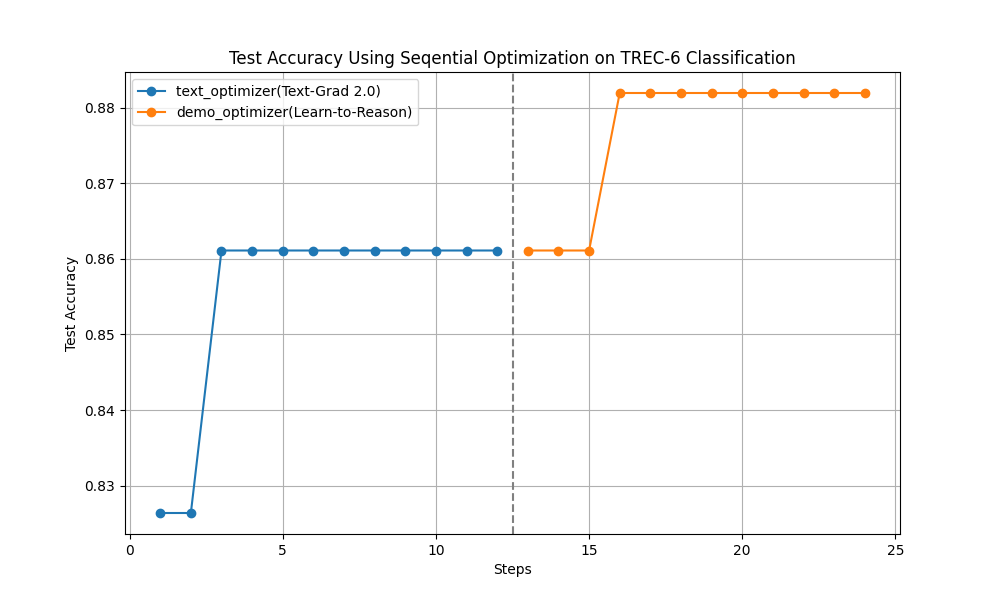

统一的自动优化框架: AdalFlow提供了一个统一的自动微分框架,可用于零样本提示优化和少样本优化。通过研究成果"Text-Grad 2.0"和"Learn-to-Reason Few-shot In Context Learning",AdalFlow的

Trainer在保持最高准确率的同时,还能实现最高的令牌效率。 -

灵活性和可定制性: 开发者可以完全控制提示模板、使用的模型以及任务管道的输出解析。这种灵活性使得AdalFlow能够适应各种复杂的LLM应用场景。

AdalFlow的核心组件

AdalFlow的架构基于两个基本但功能强大的基类:

- Component: 用于构建任务管道的组件。

- DataClass: 用于与LLM进行数据交互。

这种设计实现了最小化的抽象,为开发者提供了最大的定制能力。

统一的自动优化框架

AdalFlow的一大亮点是其统一的自动优化框架。开发者只需定义一个Parameter并将其传递给Generator,就可以轻松实现任务指令或少样本示例的优化。这个统一框架提供了诊断、可视化、调试和训练管道的简便方法。

from adalflow import Parameter, Generator

param = Parameter(name='task_instruction', value='Translate the following text')

generator = Generator(parameters=[param])

optimized_output = generator.optimize()

实际应用案例

以文本分类任务为例,AdalFlow展示了其强大的优化能力:

在所有库中,AdalFlow通过手动提示实现了最高的起始准确率(82%),并在优化后达到了最高的准确率。

社区和贡献

AdalFlow是一个开源项目,欢迎社区贡献。开发者可以通过以下方式参与:

- GitHub讨论: 分享想法、提问和协作项目。

- Discord社区: 实时与其他成员交流,获取支持。

安装和使用

AdalFlow的安装非常简单:

pip install adalflow

对于需要使用openai和faiss-cpu的用户,可以使用以下命令:

pip install adalflow[openai, faiss-cpu]

结语

AdalFlow代表了LLM应用开发的新范式。通过提供强大的构建模块和自动优化功能,它大大简化了开发过程,同时提高了性能。无论是构建聊天机器人、翻译系统、代码生成器,还是复杂的RAG系统,AdalFlow都能为开发者提供所需的工具和灵活性。

随着AI技术的不断发展,像AdalFlow这样的工具将在推动LLM应用创新方面发挥越来越重要的作用。我们期待看到更多开发者利用AdalFlow创造出令人惊叹的AI应用,推动自然语言处理技术的进步。

🔗 相关链接:

通过使用AdalFlow,开发者可以更专注于创新和应用场景,而不是陷入繁琐的底层优化中。让我们一起探索AdalFlow带来的无限可能,共同推动AI技术的发展!