Adversarial Robustness Toolbox简介

Adversarial Robustness Toolbox (ART)是一个专门用于机器学习安全的开源Python库。它由IBM开发并于2020年7月捐赠给Linux Foundation AI & Data基金会。ART的主要目标是为开发人员和研究人员提供工具,以评估、防御和验证机器学习模型和应用程序面对各种对抗性威胁的鲁棒性。

ART支持所有主流的机器学习框架,包括TensorFlow、Keras、PyTorch、MXNet、scikit-learn等。它可以处理各种数据类型,如图像、表格、音频和视频等。同时,ART还支持多种机器学习任务,如分类、目标检测、语音识别、生成等。

ART的主要功能

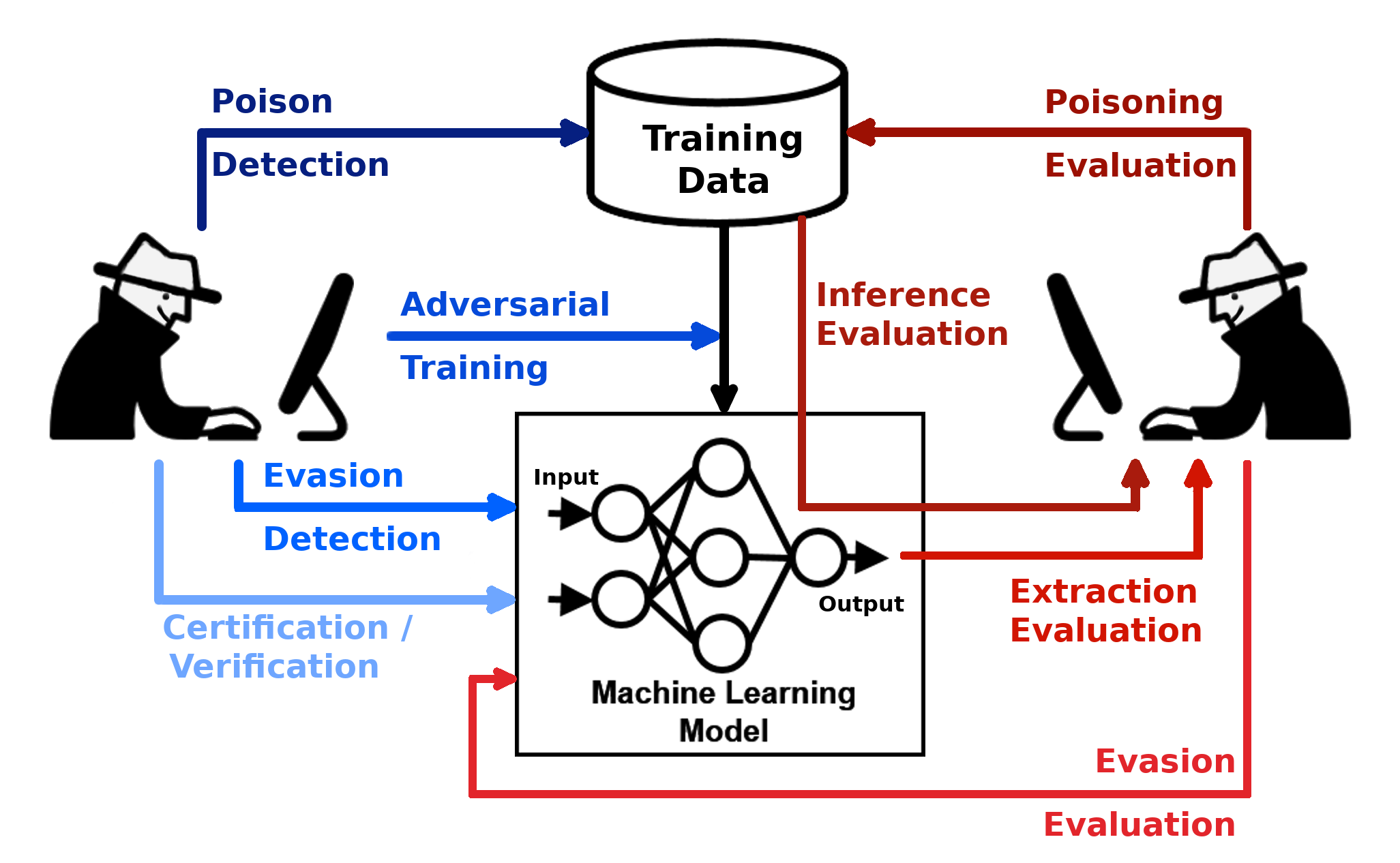

ART主要关注四类对抗性威胁:

-

逃避攻击(Evasion): 通过修改输入数据来使模型产生错误分类。

-

中毒攻击(Poisoning): 通过污染训练数据来影响模型的行为。

-

模型提取(Extraction): 试图复制或窃取目标模型。

-

推理攻击(Inference): 试图重建模型的训练数据。

为了应对这些威胁,ART提供了丰富的攻击和防御模块:

- 39个攻击模块

- 29个防御模块

- 多种鲁棒性评估指标

- 支持多种机器学习估计器

ART的工作原理

ART采用"红队-蓝队"的工作方式:

- 红队: 使用ART的攻击模块来测试模型的弱点

- 蓝队: 使用ART的防御模块来增强模型的鲁棒性

这种方法可以帮助开发人员全面评估和提高机器学习系统的安全性。

ART的使用场景

ART可以应用于多种场景:

-

评估模型的鲁棒性: 使用各种攻击方法来测试模型的抗干扰能力。

-

增强模型安全性: 应用防御技术如对抗训练、输入净化等来提高模型的鲁棒性。

-

检测对抗样本: 使用ART的检测器来识别可能的对抗性输入。

-

研究新的攻防方法: ART为研究人员提供了一个实验平台,可以方便地实现和测试新的攻击或防御算法。

-

安全审计: 对已部署的机器学习系统进行全面的安全评估。

使用ART的步骤

- 安装ART:

pip install adversarial-robustness-toolbox

- 导入所需模块:

from art.attacks.evasion import FastGradientMethod

from art.estimators.classification import KerasClassifier

- 加载模型并包装:

classifier = KerasClassifier(model=model, clip_values=(0, 1))

- 创建攻击实例:

attack = FastGradientMethod(estimator=classifier, eps=0.2)

- 生成对抗样本:

x_adv = attack.generate(x_test)

- 评估:

predictions = classifier.predict(x_adv)

ART的优势

-

全面性: 覆盖了机器学习安全的多个方面。

-

易用性: 提供了统一的API,易于集成到现有项目中。

-

可扩展性: 支持自定义攻击和防御方法。

-

跨框架: 支持多种主流机器学习框架。

-

活跃的社区: 持续更新和改进。

结语

随着机器学习在各行各业的广泛应用,其安全性问题也日益突出。Adversarial Robustness Toolbox为开发人员和研究人员提供了一个强大的工具,帮助他们构建更安全、更可靠的机器学习系统。无论是进行安全研究、模型评估还是系统加固,ART都是一个值得尝试的优秀工具。