AirLLM: 让普通GPU也能运行70B大型语言模型

在人工智能和自然语言处理领域,大型语言模型(LLM)的规模和性能不断突破,但随之而来的是对硬件资源的巨大需求。许多先进的LLM模型需要昂贵的高端GPU才能运行,这限制了它们的广泛应用。然而,一个名为AirLLM的创新项目正在改变这一现状,它让普通的消费级GPU也能运行70B参数级别的大型语言模型。

AirLLM的核心优势

AirLLM是一个开源项目,旨在优化大型语言模型的推理内存使用。它的主要优势包括:

-

在单个4GB GPU上运行70B参数模型:AirLLM能够在仅有4GB显存的GPU上运行70B参数的大型语言模型,这是一个令人印象深刻的技术突破。

-

无需模型压缩:AirLLM不需要使用量化、蒸馏或剪枝等可能降低模型性能的压缩技术。

-

支持多种主流模型:除了支持Llama系列模型外,AirLLM还支持ChatGLM、QWen、Baichuan、Mistral、InternLM等多种流行的开源大型语言模型。

-

易于使用:AirLLM提供了简单的Python API,使用者只需几行代码就能开始使用大型语言模型。

-

开源免费:作为一个开源项目,AirLLM允许社区贡献和改进,推动技术的快速发展。

AirLLM的工作原理

AirLLM采用了几种创新的技术来实现其惊人的性能:

-

分层推理:AirLLM将模型分解为多个层,并逐层进行推理。每一层完成计算后,其内存就会被释放,只保留输出结果。这种方法大大减少了同时需要的GPU内存。

-

Flash Attention:使用优化的注意力机制算法,提高了内存访问效率和计算速度。

-

层分片:将模型文件按层划分,简化了加载过程并减少内存占用。

-

元设备特性:利用HuggingFace Accelerate的meta device功能,在不实际读取数据的情况下加载模型,实现零内存使用。

-

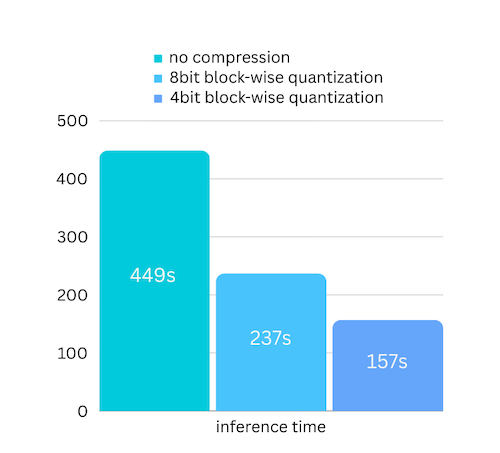

可选的量化:虽然不强制使用,但AirLLM也提供了4位或8位块级量化选项,可进一步提升推理速度。

使用AirLLM

使用AirLLM非常简单,只需几个步骤:

- 安装AirLLM:

pip install airllm

- 初始化模型并进行推理:

from airllm import AutoModel

MAX_LENGTH = 128

model = AutoModel.from_pretrained("garage-bAInd/Platypus2-70B-instruct")

input_text = ['What is the capital of United States?']

input_tokens = model.tokenizer(input_text,

return_tensors="pt",

return_attention_mask=False,

truncation=True,

max_length=MAX_LENGTH,

padding=False)

generation_output = model.generate(

input_tokens['input_ids'].cuda(),

max_new_tokens=20,

use_cache=True,

return_dict_in_generate=True)

output = model.tokenizer.decode(generation_output.sequences[0])

print(output)

AirLLM的性能提升

AirLLM不仅让大型模型能在普通GPU上运行,还提供了显著的性能提升。通过使用模型压缩技术,AirLLM可以将推理速度提高多达3倍,同时几乎不影响模型的准确性。

支持多种模型和平台

AirLLM不仅支持Llama系列模型,还支持多种流行的开源大型语言模型,如ChatGLM、QWen、Baichuan、Mistral和InternLM等。此外,AirLLM还支持在MacOS上运行,使得更多用户能够在个人电脑上体验大型语言模型的强大功能。

AirLLM的未来发展

作为一个活跃的开源项目,AirLLM正在不断发展和改进。最新的更新包括支持CPU推理、支持非分片模型,以及对Llama3.1 405B模型的支持。这些进展表明,AirLLM正在朝着更广泛的应用场景和更强大的功能迈进。

结论

AirLLM为大型语言模型的普及应用铺平了道路。通过创新的内存优化技术,它使得在普通硬件上运行先进的AI模型成为可能。这不仅降低了使用大型语言模型的门槛,也为AI技术的民主化做出了重要贡献。随着AirLLM的不断发展和完善,我们可以期待看到更多令人兴奋的应用场景和突破性的研究成果。

对于研究人员、开发者和AI爱好者来说,AirLLM无疑是一个值得关注和尝试的项目。它不仅提供了使用先进AI模型的机会,也为探索大型语言模型的潜力开辟了新的可能性。随着技术的不断进步,我们可以期待AirLLM在未来带来更多惊喜,推动AI技术向更广阔的领域发展。