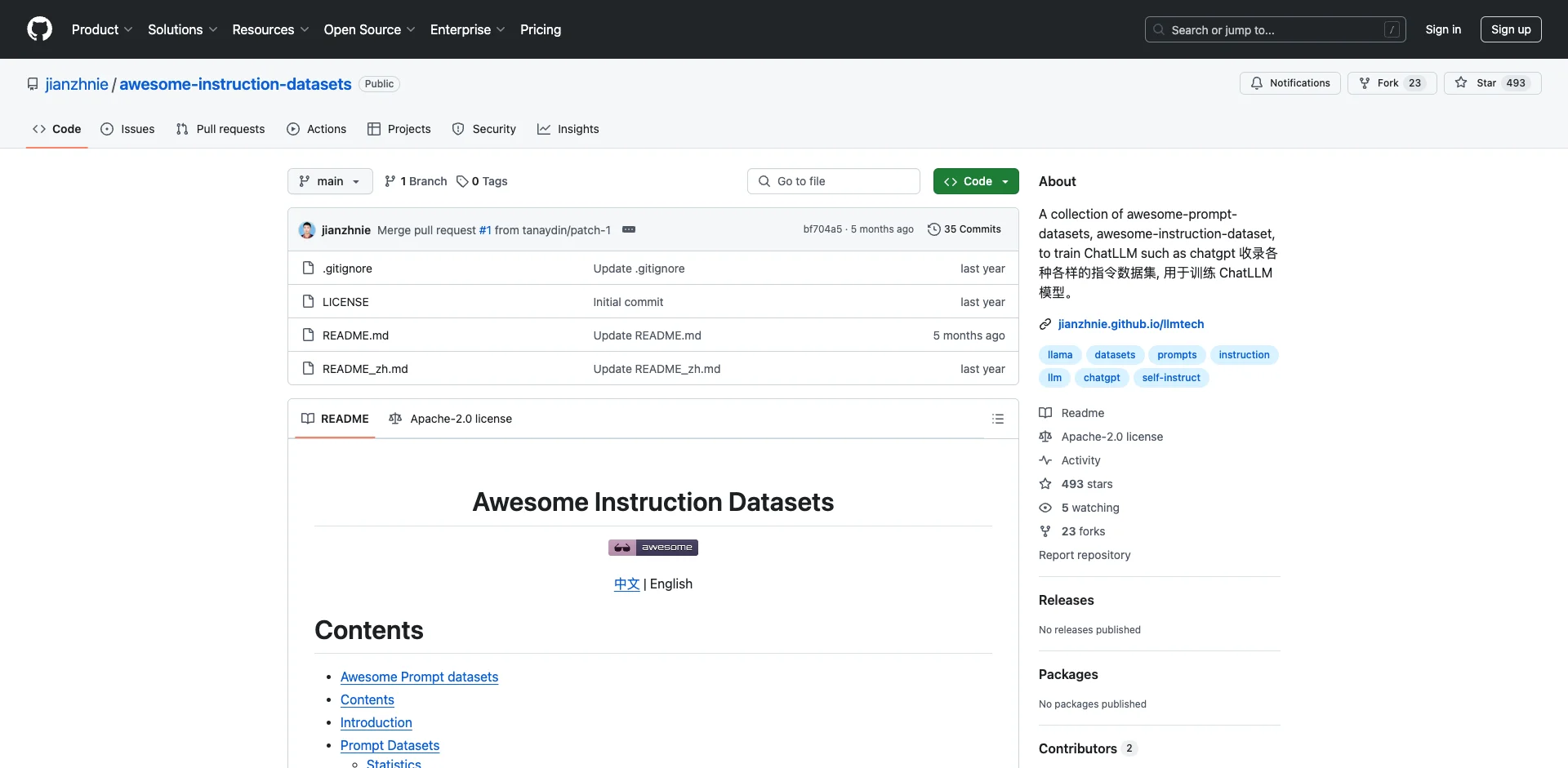

awesome-instruction-datasets:训练ChatGPT等大模型的指令数据集

awesome-instruction-datasets是一个收集用于训练像ChatGPT、LLaMA、Alpaca等指令跟随型大语言模型的高质量开源指令数据集的项目。本文将对该项目进行全面介绍,并整理相关学习资源,为研究人员和开发者提供参考。

项目简介

该项目旨在提供一个全面的指令调优数据集列表,这些数据集被用于各种大型语言模型的指令跟随训练。项目收集了多个来源的数据集,包括人工标注和自动生成的数据,涵盖了多语言、多任务场景。

主要内容

-

指令数据集列表

- 包含数据集名称、来源、数量、语言、生成方式等信息

- 覆盖英文、中文、多语言等不同语种

- 涉及通用指令、对话、代码生成等多种任务

-

RLHF(基于人类反馈的强化学习)数据集

- 用于训练奖励模型,使模型输出更符合人类偏好

-

开源聊天语言模型列表

- 整理了基于这些数据集训练的开源模型

重要数据集

- Stanford Alpaca: 斯坦福发布的52K指令数据集,用于训练7B Alpaca模型

- BELLE: 链家AI Lab发布的150万中文指令数据集

- GPT4All: 80万多语言指令数据集

- Anthropic's HH-RLHF: 22K英文人类偏好比较数据集

如何使用

研究人员和开发者可以:

- 直接使用项目中列出的数据集来训练或微调大语言模型

- 参考数据集的构建方法来生成自己的指令数据

- 使用RLHF数据集来训练奖励模型,进一步提升模型表现

相关资源

对于想要深入研究指令调优和大语言模型的人来说,awesome-instruction-datasets项目提供了宝贵的数据资源和参考。随着项目的不断更新,相信会有更多高质量的指令数据集被收录,为推动大语言模型的发展做出贡献。