awesome-huge-models:大规模AI模型资源导航 🚀

awesome-huge-models是一个汇集了大规模AI模型相关资源的开源项目。本文将对该项目进行详细介绍,为读者提供一份全面的学习指南。

项目简介

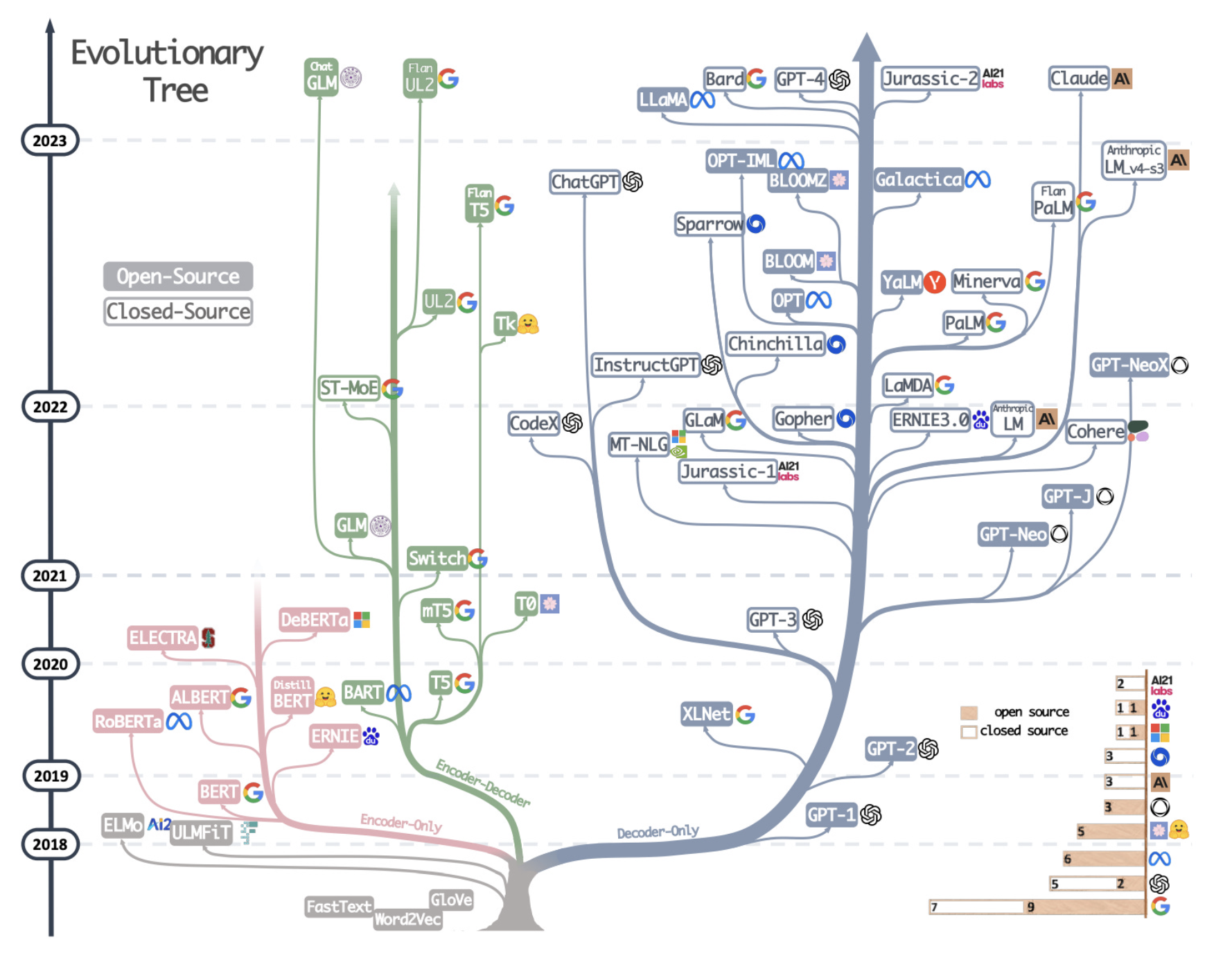

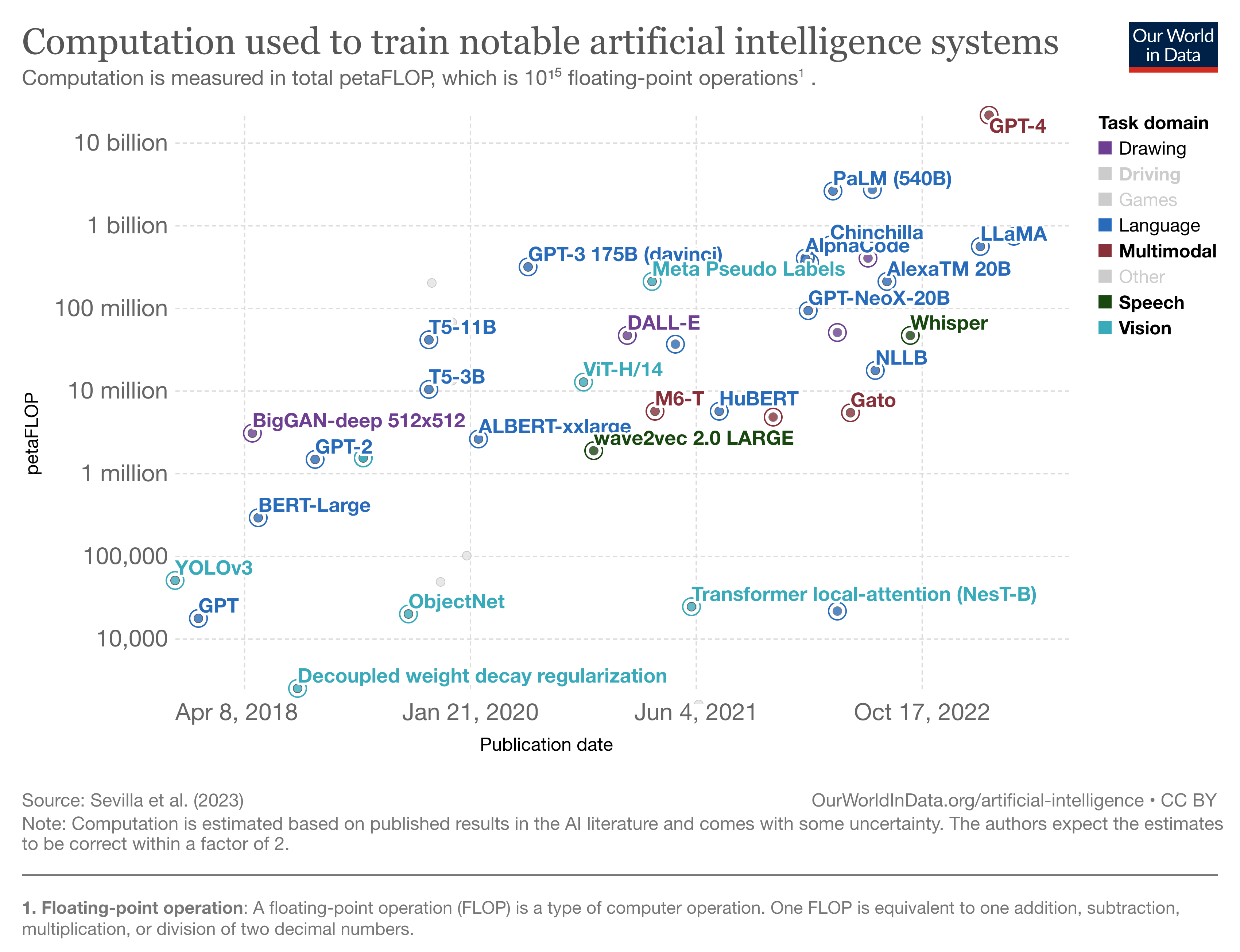

awesome-huge-models旨在收集与大规模AI模型相关的各种资源,包括模型列表、开源框架、数据集等。随着GPT-4等大模型的兴起,该项目为研究人员和开发者提供了宝贵的参考。

模型列表

项目中包含了众多大规模语言模型的详细信息,例如:

- GPT系列: GPT-3(1750亿参数)、GPT-4等

- PaLM: Google的5500亿参数模型

- LaMDA: Google的对话模型

- BLOOM: 1760亿参数的开源多语言模型

- LLaMA: Meta的开源模型系列

每个模型都有详细的参数规模、训练数据、架构等信息。

开源框架

为了训练和部署这些大规模模型,项目还收录了多个分布式训练框架:

- Megatron-LM: NVIDIA开发的模型并行框架

- DeepSpeed: 微软的分布式训练优化库

- Fairscale: Facebook的大规模训练工具包

数据集与基准

项目还包含了用于预训练的大规模数据集信息,以及评估模型性能的基准测试。

学习资源

除了技术细节,项目还收集了大量学习资源:

总结

awesome-huge-models为我们提供了一个全面了解大规模AI模型的窗口。无论是研究还是应用,这里都能找到有价值的信息。随着AI技术的快速发展,该项目也在不断更新,建议读者保持关注。

欢迎访问项目GitHub页面获取更多详细信息。让我们一起探索AI大模型的无限可能吧! 🌟