Awesome-LLM-Eval:大型语言模型评测的全面指南

在人工智能快速发展的今天,大型语言模型(LLM)已成为研究和应用的热点。然而,如何有效评估这些模型的性能和能力,仍是一个具有挑战性的问题。Awesome-LLM-Eval项目应运而生,它是一个精心策划的资源列表,汇集了LLM评测相关的工具、数据集、基准、演示和排行榜等,旨在为研究人员和开发者提供全面的评测参考,探索生成式AI的技术边界。

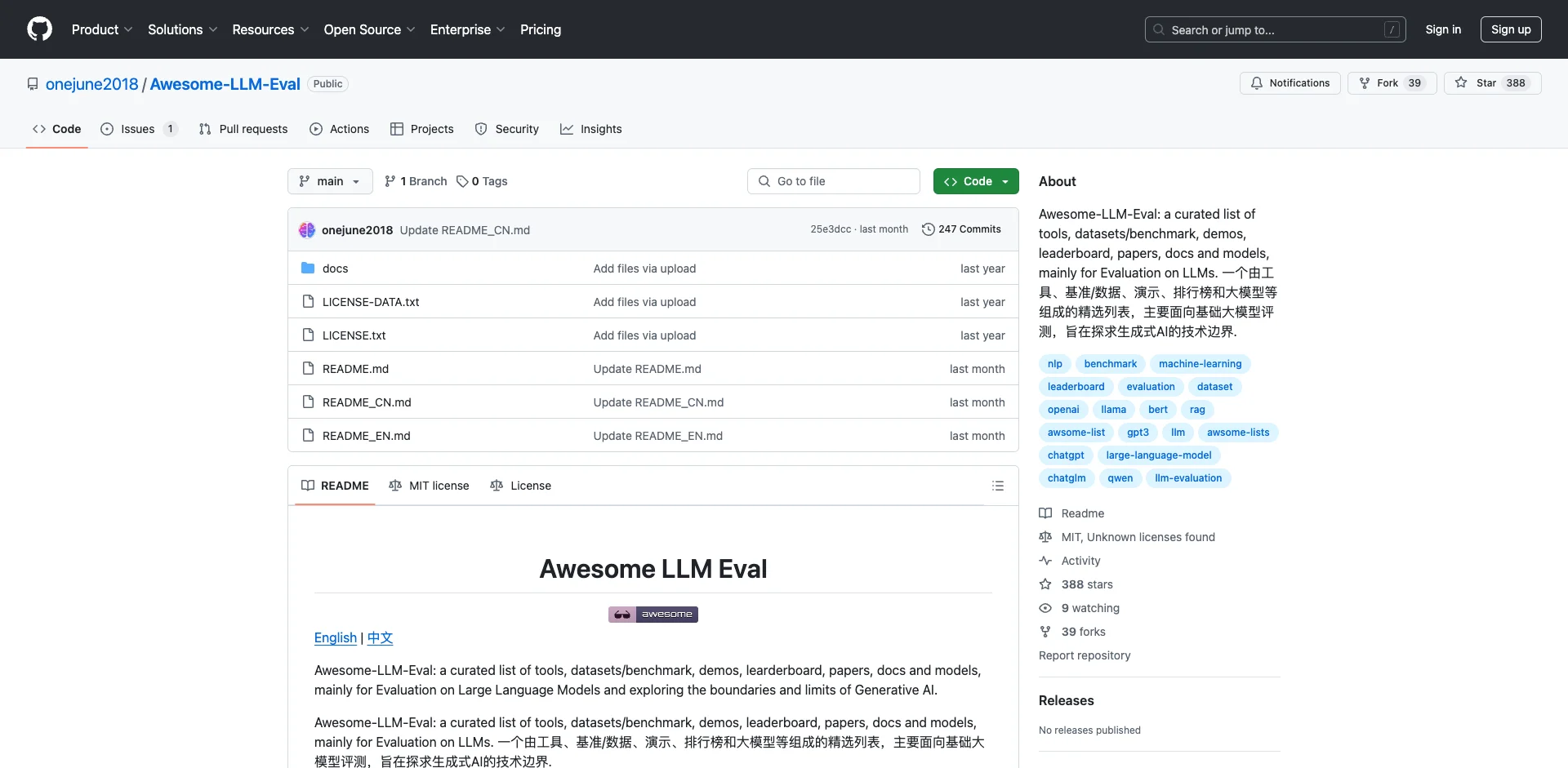

项目概述

Awesome-LLM-Eval项目由GitHub用户onejune2018创建和维护,是一个开源的资源汇总平台。该项目的主要目标是:

- 收集和整理LLM评测相关的各类资源

- 为研究人员提供全面的评测工具和基准参考

- 促进LLM评测领域的交流与合作

- 推动生成式AI技术的发展与应用

项目内容涵盖了LLM评测的多个方面,包括评测工具、数据集和基准、演示系统、排行榜、相关论文等。通过这些资源,研究人员可以全面了解LLM评测的最新进展,选择合适的工具和方法来评估自己的模型。

评测工具

Awesome-LLM-Eval项目收集了多种LLM评测工具,这些工具各有特色,适用于不同的评测场景。以下是一些代表性的工具:

-

prometheus-eval: 这是一个强大的评估专用语言模型,能够模仿人类和GPT-4的判断。它支持直接评估和成对排序两种格式,并可根据用户定义的标准进行评估。

-

athina-evals: 这是一个开源库,提供即插即用的预设评估和可扩展的框架。它帮助工程师通过评估驱动的开发来系统性地提高LLM的可靠性和性能。

-

LightEval: 由Hugging Face开发的轻量级框架,专门用于LLM评估。它支持多种任务和模型的评估,可在CPU或GPU上运行,并支持分布式评估。

-

Arthur Bench: 这是一个开源的评估工具,专门设计用来比较和分析LLM的性能。它支持多种评估任务,包括问答、摘要、翻译和代码生成等。

-

OpenCompass: 由上海人工智能实验室开发的一站式LLM评测平台。它提供全面的能力维度评估,支持多种模型,并具有分布式高效评测的特点。

这些工具为研究人员提供了多样化的选择,可以根据具体需求选择合适的工具进行评测。

数据集和基准

Awesome-LLM-Eval项目还收集了大量用于LLM评测的数据集和基准。这些资源涵盖了多个领域和任务类型,包括:

-

通用评测: 如MMLU-Pro,这是MMLU数据集的改进版本,提供更高质量和更具挑战性的多选题。

-

垂直领域评测: 针对特定领域的评测数据集,如金融、法律等专业领域。

-

RAG检索增强生成评估: 用于评估模型在检索增强生成任务中的表现。

-

Agent能力评估: 评估LLM作为智能代理的能力。

-

代码能力评估: 专门用于评估LLM在代码生成和理解方面的能力。

-

多模态/跨模态评估: 评估LLM在处理多种模态数据时的表现。

-

长上下文评估: 测试LLM处理长文本输入的能力。

这些数据集和基准为研究人员提供了全面评估LLM各方面能力的工具,有助于深入了解模型的优势和局限性。

演示系统和排行榜

Awesome-LLM-Eval项目还收集了一些LLM评测相关的演示系统和排行榜。这些资源可以帮助研究人员直观地了解不同模型的表现,并进行比较。

-

LeaderboardFinder: 由Hugging Face开发的工具,帮助用户找到适合特定场景的LLM排行榜。

-

LLM Comparator: 由Google开发的可视化分析工具,用于比较和评估LLM。它提供了一种可扩展的自动化方面对比评估方法。

这些演示系统和排行榜不仅展示了不同模型的性能,还提供了详细的评测结果和分析,有助于研究人员更好地理解模型的优缺点。

最新进展

Awesome-LLM-Eval项目持续关注LLM评测领域的最新进展,并定期更新资源列表。一些最新的进展包括:

- 推理速度评测: 新增了专门评估LLM推理速度的工具和基准。

- 代码能力评测: 增加了针对LLM代码生成和理解能力的评测资源。

- RAG评测: 新增了评估检索增强生成能力的工具和数据集。

- Agent能力评测: 添加了评估LLM作为智能代理能力的基准。

这些最新进展反映了LLM评测领域的快速发展,为研究人员提供了更全面、更深入的评测方法。

项目意义

Awesome-LLM-Eval项目的重要性体现在以下几个方面:

- 资源整合: 项目汇集了大量LLM评测相关的资源,为研究人员提供了一站式的参考平台。

- 促进标准化: 通过收集和推广各种评测工具和基准,项目有助于推动LLM评测的标准化。

- 推动技术进步: 全面的评测有助于发现LLM的优势和不足,从而推动技术的不断改进。

- 促进交流合作: 项目为研究人员提供了一个交流平台,促进了评测方法和结果的分享。

- 指导应用开发: 评测结果可以为LLM的实际应用提供指导,帮助开发者选择合适的模型和优化策略。

未来展望

随着LLM技术的不断发展,评测方法也需要持续更新和完善。Awesome-LLM-Eval项目未来可能会在以下方面继续发展:

- 更加细粒度的评测: 开发针对LLM特定能力的精细化评测方法。

- 多模态评测: 加强对多模态LLM的评测资源收集。

- 实时性能评测: 开发评估LLM在实时应用场景下性能的工具。

- 伦理和安全评测: 增加对LLM伦理性和安全性的评测资源。

- 社区参与: 鼓励更多研究者和开发者参与到资源的收集和更新中来。

结语

Awesome-LLM-Eval项目为LLM评测领域提供了一个全面而宝贵的资源库。它不仅汇集了各种评测工具、数据集和基准,还持续跟踪领域的最新进展。对于研究人员和开发者而言,这个项目是了解LLM评测现状、选择合适评测方法的重要参考。随着项目的不断更新和完善,它将继续为推动LLM技术的发展做出重要贡献。

通过Awesome-LLM-Eval项目,我们可以更好地理解和评估LLM的能力,为未来更强大、更可靠的AI系统的开发铺平道路。无论是研究人员、开发者还是对LLM感兴趣的普通读者,都可以从这个项目中获得有价值的信息和洞见。让我们共同关注这个项目的发展,为人工智能的进步贡献力量。