BlindChat:隐私保护与易用性的完美结合

在人工智能快速发展的今天,对话AI系统如ChatGPT已经成为提升生产力的重要工具。然而,随之而来的隐私安全问题也引发了广泛关注。如何在享受AI带来便利的同时,又能确保用户数据的安全?BlindChat项目为我们提供了一个创新的解决方案。

BlindChat的诞生背景

传统的对话AI系统通常采用云端部署模式,用户的输入需要发送到远程服务器进行处理。这种模式存在以下潜在风险:

- 用户无法确切知道自己的数据被如何使用和共享。

- AI提供商可能会利用用户数据来微调模型,从而导致隐私泄露。

- 敏感信息可能被意外地泄露给其他用户。

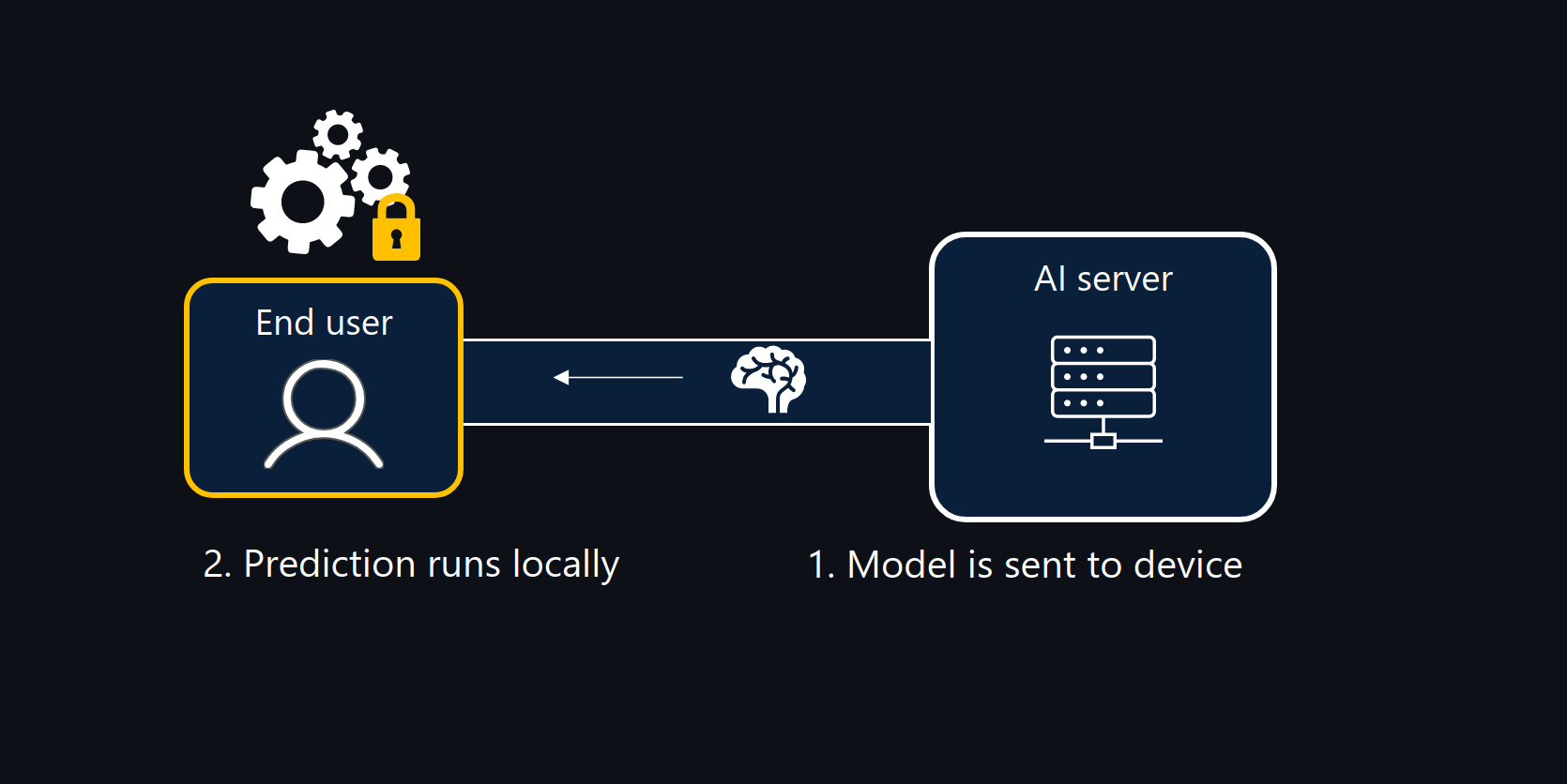

为了解决这些问题,一些组织选择本地部署AI模型。但这种方案往往需要较高的技术门槛和部署成本,不适合普通用户。

BlindChat项目正是为了弥补易用性和隐私保护之间的鸿沟而诞生的。它的目标是打造一个开源的、以隐私为中心设计的对话AI系统,为用户提供既安全又便捷的AI助手体验。

BlindChat的核心特性

BlindChat基于Hugging Face的Chat-UI项目进行了改造,其核心特性包括:

-

全浏览器端运行: BlindChat将所有逻辑都迁移到了客户端浏览器中运行,无需后端服务器支持。这意味着用户的数据不会离开自己的设备。

-

本地模型推理: 利用transformers.js库,BlindChat能够在浏览器中直接运行AI模型。目前支持LaMini-Flan-T5-783M模型,未来还将支持更多选择。

-

本地存储对话: 所有对话记录都存储在浏览器缓存中,而非远程服务器,进一步保护了用户隐私。

-

无遥测数据收集: BlindChat不会收集任何用户数据来改进模型,确保用户对话的完全私密性。

-

开源透明: 作为一个开源项目,BlindChat的代码完全公开,用户可以自行审查和验证其隐私保护机制。

BlindChat的使用体验

尽管BlindChat将所有计算都转移到了客户端,但它仍然努力为用户提供流畅的体验:

-

流式输出: BlindChat实现了本地的token流式输出,模拟了传统对话AI的平滑响应效果。

-

无需安装: 用户只需打开浏览器就能使用BlindChat,无需下载安装任何额外软件。

-

首次加载优化: 虽然首次使用时需要下载模型,但后续使用将变得更加迅速。

-

多设备支持: 只要有浏览器,用户就能在不同设备上使用BlindChat。

需要注意的是,由于模型在本地运行,BlindChat对用户的网络带宽和设备性能有一定要求。但这种权衡换来的是更高的隐私保护级别。

BlindChat的未来发展

BlindChat团队对这个项目的未来充满期待,他们计划:

- 引入更多高质量模型,如phi-1.5等。

- 实现基于浏览器的RAG(检索增强生成)功能。

- 开发远程飞地推理技术,支持更大规模模型的私密服务。

- 持续优化用户体验和性能。

结语

在AI技术日新月异的今天,BlindChat为我们展示了一种平衡隐私保护和易用性的新思路。它不仅为个人用户提供了安全可靠的AI助手选择,也为企业和组织在处理敏感信息时使用AI提供了可能性。

随着项目的不断发展和完善,我们有理由相信,BlindChat将在推动AI技术向更加开放、透明和尊重隐私的方向发展中发挥重要作用。无论你是普通用户、开发者还是对AI隐私问题感兴趣的研究者,都值得关注这个充满潜力的开源项目。

如果你对BlindChat感兴趣,可以访问其GitHub仓库了解更多信息,或者直接在在线演示中体验这款创新的隐私保护AI助手。让我们一起期待BlindChat为AI行业带来的变革,共同推动人工智能向着更加安全、可信的方向发展。