C-Eval: 一个全面的中文基础模型评估套件

C-Eval:为中文大模型而生的综合评估基准

在人工智能快速发展的今天,大型语言模型(Large Language Models, LLMs)的能力不断突破,让人惊叹。然而,如何全面、客观地评估这些模型在中文领域的表现,一直是一个具有挑战性的问题。为此,来自香港科技大学等机构的研究团队开发了C-Eval - 一个专门针对中文基础模型的多层次、多学科评估套件。

C-Eval的特点与优势

C-Eval的设计初衷是为中文大模型提供一个全面的"体检"。它具有以下几个显著特点:

-

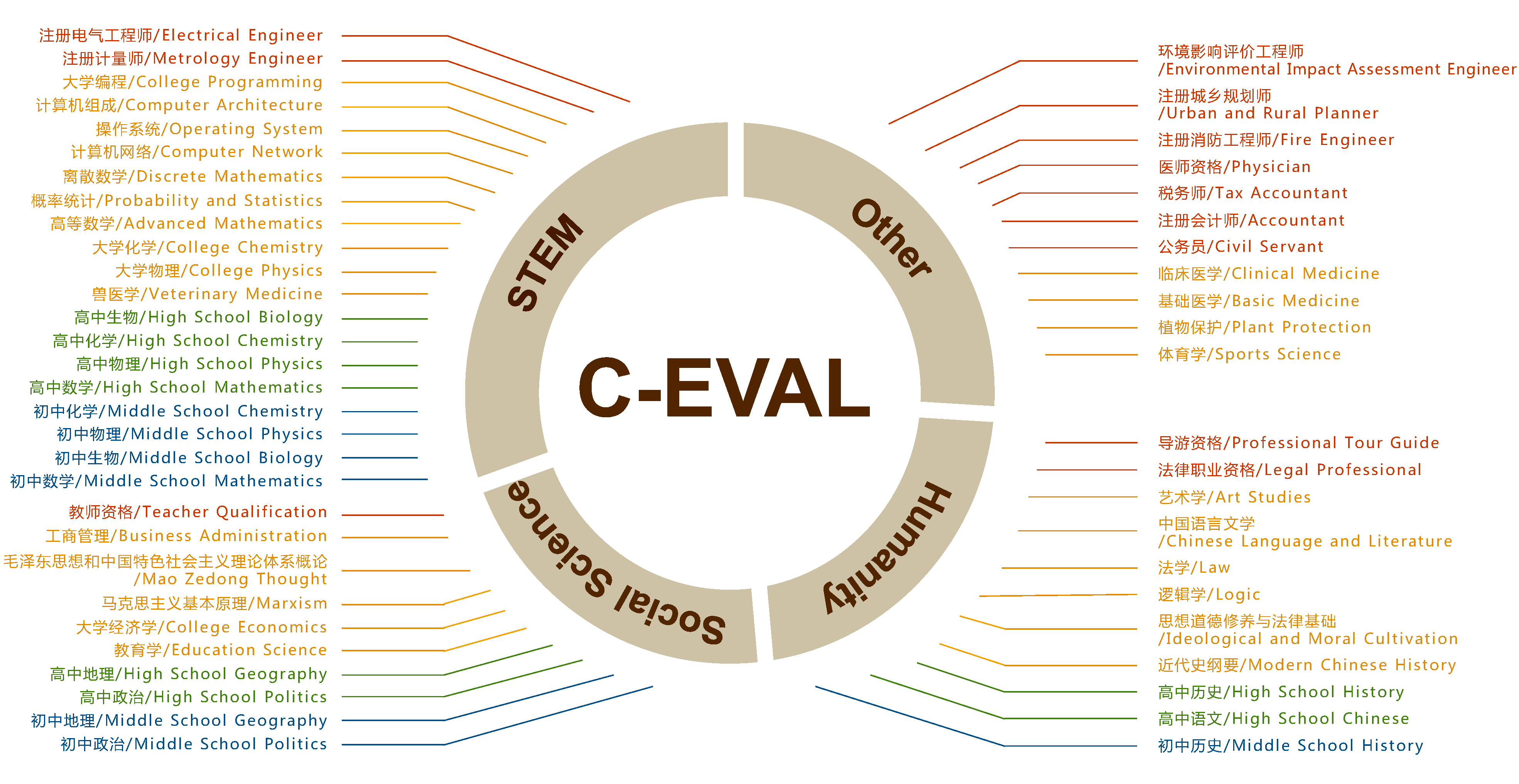

广泛的学科覆盖:C-Eval包含了52个不同学科的题目,涵盖了STEM(科学、技术、工程、数学)、社会科学、人文学科等多个领域。这种广泛的覆盖确保了评估的全面性。

-

多层次的难度设置:评估套件中的题目被分为四个难度等级,从初级到高级不等。这种分层设计可以更细致地反映出模型在不同复杂度任务上的表现差异。

-

大规模的题库:C-Eval总共包含13,948个多选题。如此大规模的题库不仅提高了评估的可靠性,也为研究人员提供了丰富的分析素材。

-

标准化的评估流程:C-Eval提供了详细的评估指南和工具,包括零样本(zero-shot)和少样本(few-shot)评估方法,使得不同模型之间的性能比较更加公平和标准化。

C-Eval的构建过程

C-Eval的构建过程充分体现了研究团队的严谨态度和专业素养。他们采用了以下步骤来确保评估套件的质量:

-

题目收集与筛选:研究团队从各种公开可用的中文考试资源中收集了大量题目,包括高考、研究生入学考试等。

-

专家审核:所有收集到的题目都经过了相关领域专家的仔细审核,以确保题目的准确性和适当性。

-

难度分级:基于题目的复杂程度和所需知识深度,研究团队将题目分为四个难度等级。

-

多轮测试与优化:在正式发布之前,C-Eval经过了多轮测试和优化,以确保其评估结果的可靠性和稳定性。

C-Eval的应用价值

C-Eval的推出为中文大模型的评估和改进提供了重要工具:

-

全面评估模型能力:通过C-Eval,研究人员可以全面了解模型在不同学科和难度级别上的表现,从而更准确地评估模型的整体能力。

-

发现模型优势与不足:C-Eval的细分类别可以帮助开发者识别模型在特定领域或任务类型上的优势和劣势,为进一步优化提供方向。

-

促进模型间的公平比较:标准化的评估流程使得不同研究团队开发的模型可以在同一平台上进行公平比较。

-

推动中文NLP研究发展:作为一个开放的评估基准,C-Eval为整个中文自然语言处理(NLP)社区提供了一个共同的研究平台,有助于推动相关技术的进步。

如何使用C-Eval

对于想要使用C-Eval评估自己模型的研究者和开发者,C-Eval提供了详细的使用指南:

-

数据获取:C-Eval的数据集可以通过Hugging Face平台直接下载和使用。

-

评估方法:C-Eval支持零样本和少样本(通常是5-shot)两种评估模式。研究团队提供了标准的提示模板,以确保评估的一致性。

-

结果提交:评估完成后,用户需要将结果整理成指定的JSON格式,并通过C-Eval官方网站提交,以获取最终的测试集准确率。

-

使用评估框架:C-Eval已被集成到lm-evaluation-harness框架中,用户可以通过简单的命令行操作完成评估过程。

C-Eval的初步评估结果

C-Eval的研究团队对多个知名的大语言模型进行了初步评估,结果显示:

- 在零样本设置下,GPT-4的平均准确率达到66.4%,大幅领先于其他模型。

- ChatGPT和Claude-v1.3的表现相当,平均准确率在50%左右。

- 中文特化模型如GLM-130B和ChatGLM-6B在某些领域表现不俗,但整体上仍有提升空间。

这些结果不仅反映了当前大语言模型在中文领域的能力水平,也为未来的研究和改进指明了方向。

未来展望

C-Eval的发布无疑是中文NLP领域的一个重要里程碑。随着更多研究团队和企业采用C-Eval作为评估标准,我们有理由期待:

- 中文大模型的性能将得到更快提升。

- 更多针对特定领域或任务的专业模型会涌现。

- 评估方法学本身也将不断完善和发展。

C-Eval不仅是一个评估工具,更是推动中文人工智能发展的重要催化剂。它的出现,标志着中文NLP研究进入了一个更加规范化、标准化的新阶段。

对于有志于推动中文AI发展的研究者、开发者和企业来说,深入了解和使用C-Eval无疑是一个明智之选。让我们共同期待C-Eval在未来带来的更多惊喜和突破。

编辑推��荐精选

讯飞智文

一键生成PPT和Word,让学习生活更轻松

讯飞智文是一个利用 AI 技术的项目,能够帮助用户生成 PPT 以及各类文档。无论是商业领域的市场分析报告、年度目标制定,还是学生群体的职业生涯规划、实习避坑指南,亦或是活动策划、旅游攻略等内容,它都能提供支持,帮助用户精准表达,轻松呈现各种信息。

讯飞星火

深度推理能力全新升级,全面对标OpenAI o1

科大讯飞的星火大模型,支持语言理解、知识问答和文本创作等多功能,适用于多种文件和业务场景,提升办公和日常生活的效率。讯飞星火是一个提供丰富智能服务的平台,涵盖科技资讯、图像创作、写作辅助、编程解答、科��研文献解读等功能,能为不同需求的用户提供便捷高效的帮助,助力用户轻松获取信息、解决问题,满足多样化使用场景。

Spark-TTS

一种基于大语言模型的高效单流解耦语音令牌文本到语音合成模型

Spark-TTS 是一个基于 PyTorch 的开源文本到语音合成项目,由多个知名机构联合参与。该项目提供了高效的 LLM(大语言模型)驱动的语音合成方案,支持语音克隆和语音创建功能,可通过命令行界面(CLI)和 Web UI 两种方式使用。用户可以根据需求调整语音的性别、音高、速度等参数,生成高质量的语音。该项目适用于多种场景,如有声读物制作、智能语音助手开发等。

Trae

字节跳动发布的AI编程神器IDE

Trae是一种自适应的集成开发环境(IDE�),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

咔片PPT

AI助力,做PPT更�简单!

咔片是一款轻量化在线演示设计工具,借助 AI 技术,实现从内容生成到智能设计的一站式 PPT 制作服务。支持多种文档格式导入生成 PPT,提供海量模板、智能美化、素材替换等功能,适用于销售、教师、学生等各类人群,能高效制作出高品质 PPT,满足不同场景演示需求。

讯飞绘文

选题、配图、成文,一站式创作,让内容运营更高效

讯飞绘文,一个AI集成平台,支持写作、选题、配图、排版和发布。高效生成适用于各类媒体的定制内容,加速品牌传播,提升内容营销效果。

材料星

专业的AI公文写作平台,公文写作神器

AI 材料星,专业的 AI 公文写作辅助平台,为体制内工作人员提供高效的公文写作解决方案。拥有海量公文文库、9 大核心 AI 功能,支持 30 + 文稿类型生成,助力快速完成领导讲话、工作总结、述职报告等材料,提升办公效率,是体制打工人的得力写作神器。

openai-agents-python

OpenAI Agents SDK,助力开发者便捷使用 OpenAI 相关功能。

openai-agents-python 是 OpenAI 推出的一款强大 Python SDK,它为开发者提供了与 OpenAI 模型交互的高效工具,支持工具调用、结果处理、追踪等功能,涵盖多种应用场景,如研究助手、财务研究等,能显著提升开发效率,让开发者更轻松地利用 OpenAI 的技术优势。

Hunyuan3D-2

高分辨率纹理 3D 资产生成

Hunyuan3D-2 是腾讯开发的用于 3D 资产生成的强大工具,支持从文本描述、单张图片或多视角图片生成 3D 模型,具备快速形状生成能力,可生成带纹理的高质量 3D 模型,适用于多个领域,为 3D 创作提供了高效解决方案。

3FS

一个具备存储、管理和客户端操作等多种功能的分布式文件系统相关项目。

3FS 是一个功能强大的分布式文件系统项目,涵盖了存储引擎、元数据管理、客户端工具等多个模块。它支持多种文件操作,如创建文件和目录、设置布局等,同时具备高效的事件循环、节点选择和协程池管理等特性。适用于需要大规模数据存储和管理的场景,能够提高系统的性能和可靠性,是分布式存储领域的优质解决方案。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号