Candle: 用 Rust 打造的高性能机器学习框架

Candle 是一个由 Hugging Face 开发的开源机器学习框架,旨在为 Rust 开发者提供一个高性能、易用的深度学习工具。作为一个轻量级框架,Candle 专注于提供核心功能,同时保持极高的性能和灵活性。

主要特性

Candle 的设计理念围绕着以下几个核心特性:

-

简洁的语法: Candle 的 API 设计类似于 PyTorch,使得熟悉 PyTorch 的开发者可以快速上手。

-

多后端支持:

- 针对 x86 架构优化的 CPU 后端,可选 MKL 支持

- 针对 Mac 优化的 Accelerate 后端

- 支持 CUDA 的 GPU 后端,可通过 NCCL 实现多 GPU 分布式计算

- WebAssembly (WASM) 支持,让模型可以直接在浏览器中运行

-

丰富的预训练模型: Candle 支持多种流行的深度学习模型,包括:

- 大型语言模型:LLaMA、Falcon、Phi、Gemma 等

- 计算机视觉模型:YOLO、SegFormer、DINOv2 等

- 音频模型:Whisper、EnCodec 等

- 多模态模型:Stable Diffusion、BLIP 等

-

量化支持: 支持与 llama.cpp 相同的量化技术,可大幅降低模型内存占用

-

文件格式支持: 可加载 safetensors、npz、ggml 或 PyTorch 格式的模型文件

-

无服务器部署: 支持轻量级、快速的 CPU 部署

应用案例

Candle 已经在多个在线 Demo 中得到应用,展示了其在实际场景中的能力:

-

语音识别: 使用 Whisper 模型实现多语言语音转文本。

-

文本生成: 基于 LLaMA2、T5、Phi 等模型的文本生成应用。

-

图像处理:

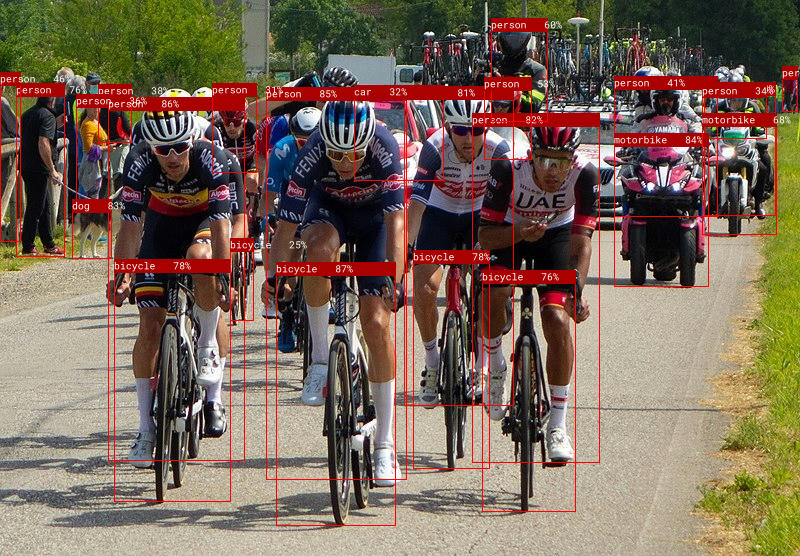

- 使用 YOLO 进行物体检测和姿态估计

- 基于 Stable Diffusion 的文本到图像生成

- 使用 Segment Anything Model (SAM) 进行图像分割

-

图像理解: 使用 BLIP 模型进行图像描述生成

这些 demo 展示了 Candle 在处理各种 AI 任务时的灵活性和高效性。值得注意的是,这些应用都可以直接在浏览器中运行,充分利用了 Candle 的 WASM 支持特性。

技术细节

Candle 的架构设计非常模块化,主要包含以下几个核心组件:

- candle-core: 定义了核心操作、设备抽象和

Tensor结构体 - candle-nn: 提供构建神经网络模型所需的工具

- candle-kernels: 包含 CUDA 自定义内核

- candle-datasets: 实现数据集和数据加载器

- candle-transformers: 提供 Transformer 相关的实用工具

- candle-flash-attn: 实现 Flash Attention v2 层

这种模块化设计使得 Candle 可以灵活地适应不同的应用场景,开发者可以根据需求选择性地使用相关组件。

与其他框架的比较

Candle 在 Rust 机器学习生态中占有独特地位。相比于其他框架,Candle 的优势主要体现在:

-

易用性: 相比 dfdx 等在类型系统上做了很多工作的框架,Candle 的 API 设计更接近 PyTorch,学习曲线更平缓。

-

性能: 与 tch-rs 等绑定型框架相比,Candle 作为原生 Rust 实现,在某些场景下可能会有更好的性能表现。

-

部署便利性: Candle 的轻量级设计使得它特别适合无服务器部署和边缘计算场景。

-

WASM 支持: 这一特性让 Candle 在浏览器端 AI 应用开发中具有独特优势。

使用指南

使用 Candle 非常直观,以下是一个简单的矩阵乘法示例:

use candle_core::{Device, Tensor};

fn main() -> Result<(), Box<dyn std::error::Error>> {

let device = Device::Cpu;

let a = Tensor::randn(0f32, 1., (2, 3), &device)?;

let b = Tensor::randn(0f32, 1., (3, 4), &device)?;

let c = a.matmul(&b)?;

println!("{c}");

Ok(())

}

如果要使用 GPU 加速,只需将设备更改为 CUDA:

let device = Device::new_cuda(0)?;

Candle 还提供了一系列更复杂的例子,涵盖了从简单的神经网络到复杂的预训练模型的各种应用场景。这些例子不仅是学习资源,也是快速开始实际项目的良好起点。

社区与生态

Candle 拥有一个活跃的开发者社区,GitHub 仓库已获得超过 15k 的 star。社区贡献了许多有价值的扩展和工具,例如:

candle-lora: 提供高效的 LoRA 实现optimisers: 实现了多种优化器算法candle-vllm: 高效的本地 LLM 推理和服务平台candle-ext: 提供一些 PyTorch 中有但 Candle 中尚未实现的函数

这些社区贡献大大扩展了 Candle 的能力,使其更适合各种实际应用场景。

未来展望

作为一个年轻但发展迅速的项目,Candle 正在不断完善和扩展其功能。未来可能的发展方向包括:

- 支持更多的预训练模型和任务类型

- 进一步优化性能,特别是在分布式计算方面

- 增强与其他 Rust 生态系统工具的集成

- 改进文档和教程,降低新用户的入门门槛

总的来说,Candle 为 Rust 开发者提供了一个强大而灵活的机器学习工具,它的轻量级设计和高性能特性使其特别适合于需要快速部署的生产环境。随着 AI 技术的不断发展和 Rust 语言在系统编程领域的日益普及,Candle 有望在未来的 AI 应用开发中发挥更大的作用。

无论你是经验丰富的机器学习工程师,还是刚开始探索 AI 领域的 Rust 开发者,Candle 都为你提供了一个值得尝试的工具。它简洁的 API、出色的性能和广泛的模型支持,使其成为构建下一代 AI 应用的理想选择。随着更多开发者加入 Candle 社区,我们有理由相信,这个框架将继续成长,并在 Rust 的 AI 生态系统中占据重要地位。

在探索 Candle 的过程中,不要忘记查看官方文档和示例代码。这些资源不仅能帮助你快速上手,还能深入了解框架的各种高级特性。同时,积极参与社区讨论也是加深理解和贡献项目的好方法。无论你是想构建一个简单的机器学习模型,还是部署复杂的 AI 系统,Candle 都能为你的项目提供坚实的基础。让我们一起,用 Rust 和 Candle 的力量,点亮 AI 的未来!🕯️💻🚀