CLIP图像搜索工具:浏览器中的AI图片排序与检索

在当今数字时代,图像数据呈爆炸式增长。无论是个人还是企业,都面临着如何高效管理和检索海量图片的挑战。传统的基于文件名或目录结构的图片管理方式已经难以应对。那么,有没有一种更智能、更便捷的图片管理方式呢?今天要介绍的clip-image-sorter工具,为我们提供了一种全新的AI辅助图片管理方案。

什么是clip-image-sorter?

clip-image-sorter是一款基于OpenAI CLIP模型的在线图像搜索工具。它可以让用户在浏览器中,根据文本描述对本地图片文件夹进行智能排序和检索,无需将图片上传到服务器。

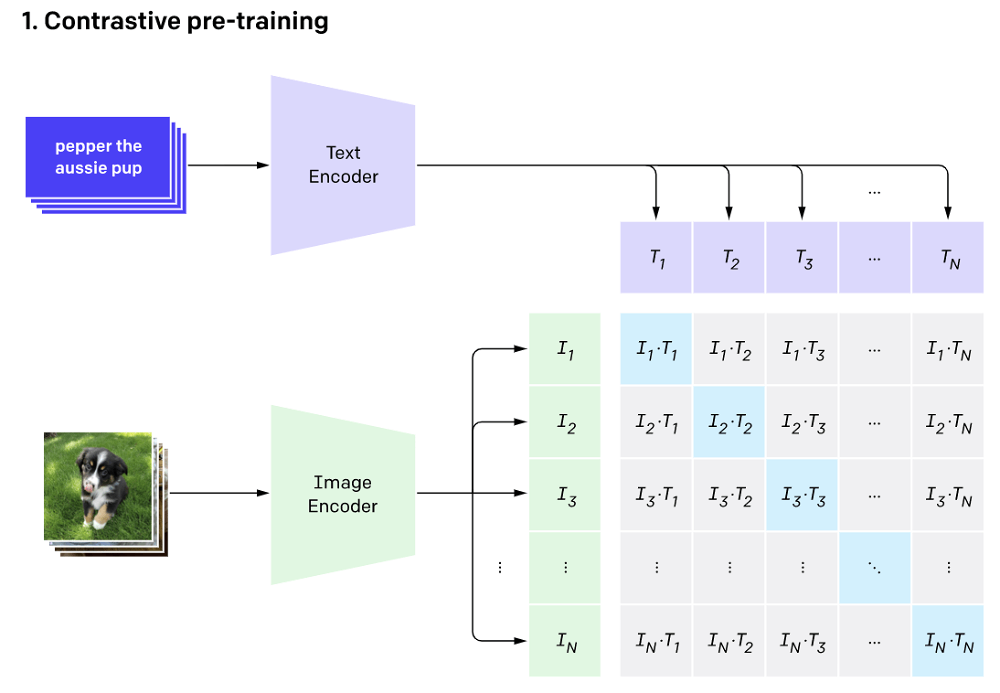

该工具的核心原理是利用OpenAI的CLIP(Contrastive Language-Image Pre-training)模型。CLIP是一个强大的多模态AI模型,可以理解图像内容并将其与文本描述进行匹配。clip-image-sorter将CLIP模型移植到浏览器中运行,结合新的文件系统访问API,实现了完全本地化的AI图像检索功能。

主要特点和优势

-

完全本地化处理:所有计算都在用户浏览器中完成,无需上传图片,保护隐私。

-

基于语义的智能检索:可以用自然语言描述搜索图片,而不局限于标签或文件名。

-

零样本学习能力:无需针对特定数据集训练,可以泛化到各种图像内容。

-

跨模态理解:可以将文本描述与图像内容进行语义层面的匹配。

-

使用便捷:完全基于Web,无需安装任何软件,打开网页即可使用。

-

开源免费:代码完全开源,可以自由使用和定制。

如何使用clip-image-sorter?

使用clip-image-sorter非常简单,只需几个步骤:

-

选择要处理的本地图片文件夹

-

等待模型加载和图像嵌入计算完成

-

输入文本描述,比如"一只可爱的小猫"

-

点击搜索,查看按相关度排序的图片结果

整个过程都在浏览器中完成,无需上传任何图片。你可以尝试各种文本描述,探索图片集合中的内容。

技术原理深入解析

clip-image-sorter的核心是CLIP(Contrastive Language-Image Pre-training)模型。CLIP通过对大规模图文对数据进行对比学习,学会了将图像和文本映射到同一个向量空间。在这个空间中,语义相似的图像和文本会被映射到相近的位置。

具体工作流程如下:

-

图像编码:将输入图片通过视觉编码器(如ResNet或ViT)编码成特征向量。

-

文本编码:将输入文本通过文本编码器(如Transformer)编码成特征向量。

-

相似度计算:计算图像向量和文本向量的余弦相似度。

-

排序:根据相似度对图片进行排序。

clip-image-sorter将这个过程在浏览器中实现,利用WebGL加速计算,实现了高效的本地化处理。

应用场景和潜在影响

clip-image-sorter为图像管理和检索带来了新的可能性。它的潜在应用场景包括:

-

个人照片管理:快速找到特定场景、物体或人物的照片。

-

设计素材库:根据创意概念搜索合适的图片素材。

-

电商图片检索:通过文本描述查找相似商品图片。

-

媒体资产管理:智能组织和检索大型图片库。

-

视觉AI训练数据筛选:快速从大量图片中筛选符合条件的样本。

这种基于AI的语义图像检索方式,有望大幅提升图像数据的管理效率和使用价值。它为我们提供了一种更自然、更智能的与图像数据交互的方式。

局限性和未来展望

尽管clip-image-sorter展现了令人兴奋的潜力,但它也存在一些局限性:

-

计算资源要求较高,在大规模图片集上可能会较慢。

-

对于抽象概念的理解还有提升空间。

-

目前主要支持英文输入,多语言支持有待加强。

未来,随着模型的进一步优化和硬件性能的提升,我们可以期待:

-

更快速和高效的处理能力

-

更精确的语义理解和匹配

-

多模态融合,支持图像、文本、语音等多种输入方式

-

个性化定制,根据用户习惯进行优化

结语

clip-image-sorter为我们展示了AI在图像管理领域的巨大潜力。它不仅是一个实用的工具,更代表了一种全新的人机交互范式。在这个范式中,AI扮演着智能助手的角色,帮助我们更自然、更高效地管理和利用视觉信息。

随着技术的不断进步,我们有理由相信,未来会涌现出更多类似的创新应用,进一步改变我们与数字世界交互的方式。无论你是技术爱好者、设计师、还是普通用户,不妨亲自体验一下clip-image-sorter,探索AI辅助图像管理的魅力。