CLIP-ImageSearch-NCNN:让图片搜索变得简单自然

在这个图像数据爆炸的时代,如何快速准确地从海量图片中找到我们需要的内容,一直是一个具有挑战性的问题。传统的基于标签或元数据的搜索方式往往难以满足用户复杂多变的需求。而近年来,随着人工智能技术的飞速发展,特别是自然语言处理和计算机视觉的结合,为图像搜索带来了新的可能性。

今天要为大家介绍的CLIP-ImageSearch-NCNN项目,正是这一技术潮流下的产物。它基于OpenAI的CLIP(Contrastive Language-Image Pre-training)模型,结合腾讯开源的NCNN深度学习推理框架,实现了一个轻量级的、支持自然语言的图片搜索引擎。让我们一起来探索这个有趣的项目吧!

项目背景:从GPT到CLIP的灵感迸发

CLIP-ImageSearch-NCNN的作者EdVince在GitHub上分享了他开发这个项目的初衷。有趣的是,这个想法并非一开始就聚焦于图像搜索,而是源于他之前开发GPT模型的经历。

"其实想做CLIP是因为我前面还想做GPT来的,当时想着既然要做GPT,为什么不把CLIP也做了呢?"

这种将不同技术领域联系起来的思维方式,正是创新的源泉。EdVince进一步解释道,在浏览CLIP相关项目时,他被natural-language-image-search这个项目深深吸引。该项目展示了如何通过自然语言描述来搜索图片,这让他立即意识到这种功能非常适合集成到手机相册应用中。

项目目标:打造跨平台的自然语言图片搜索引擎

基于这一灵感,CLIP-ImageSearch-NCNN项目的核心目标被确定下来:

- 使用NCNN框架部署CLIP模型

- 实现基于自然语言的图像检索功能

- 提供Android和x86平台的demo应用

这个目标既考虑了技术的前沿性(CLIP模型),又兼顾了实用性(跨平台支持)和性能(使用NCNN优化)。

工作原理:CLIP模型的魔力

CLIP-ImageSearch-NCNN的核心原理基于CLIP模型的独特设计。让我们简单回顾一下CLIP是如何工作的:

-

特征提取:

- 使用CLIP的

encode_image函数提取图片的特征向量 - 使用CLIP的

encode_text函数提取文字的特征向量

- 使用CLIP的

-

相似度计算: 对图像特征向量和文本特征向量计算相似度

-

双向匹配: 支持文本匹配图片,也可以图片匹配文本

-

灵活应用: 基于这一原理,可以实现以图搜图、以字搜图、以图搜字等多种功能

值得一提的是,项目作者选择了"RN50"模型作为图像特征提取的backbone,即使用ResNet50网络进行特征抽取。这在保证性能的同时,也确保了模型的轻量化,适合在移动设备上运行。

项目架构:紧凑而高效

CLIP-ImageSearch-NCNN的仓库结构清晰明了:

android: 包含Android平台APK程序的源代码x86: 包含Windows平台EXE程序的源代码,基于Qt开发gallery: 一个小型图库,用于测试resources: README文件的资源文件夹

这种结构设计使得项目易于理解和维护,也方便其他开发者参与贡献。

使用演示:简单直观的操作流程

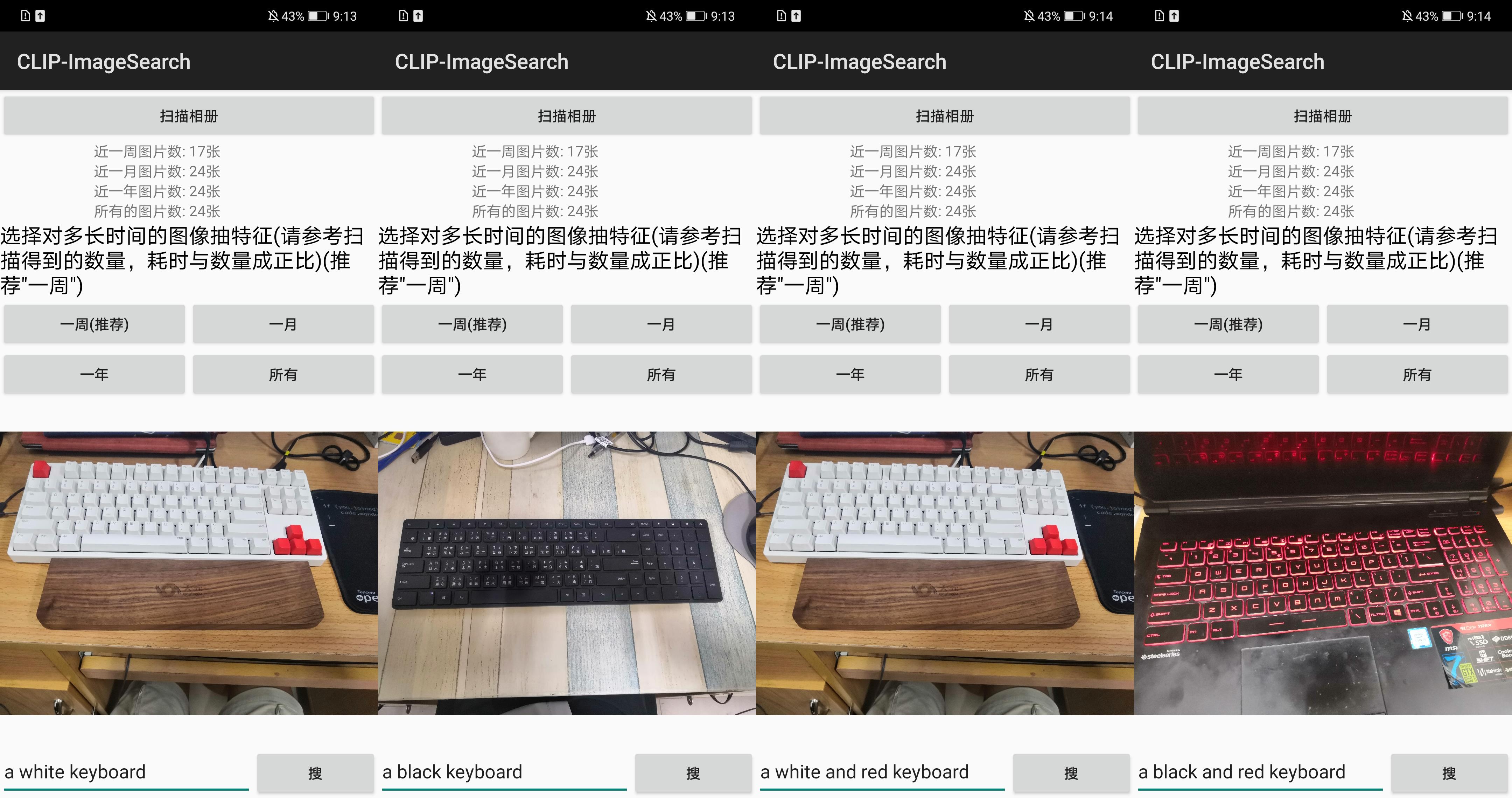

为了让用户直观地了解项目的功能,作者提供了Android和x86两个平台的演示应用。让我们分别看看它们是如何工作的:

Android版本

Android版本的使用流程如下:

- 点击"扫描相册",扫描手机中的图片

- 选择合适的时间段进行特征提取(注意:这个过程可能比较耗时,在麒麟970芯片上,处理一张图片约需0.5秒)

- 在底部输入框中输入要搜索的内容(注意:必须使用英文)

- 点击"搜"按钮获取结果(在麒麟970上,大约1.5秒就能出结果)

x86版本

x86版本的操作步骤如下:

- 点击"1.选择图库",选择repo中的gallery文件夹

- 点击"2.抽取图库特征",提取所选文件夹中所有图片的特征(耗时与图片数量成正比)

- 在文本框中输入描述要搜索图片的英文句子(大小写不敏感)

- 点击"4.搜",程序会返回图库中与输入文字最匹配的图片

这种简洁的界面设计和直观的操作流程,大大降低了用户的使用门槛,使得复杂的AI技术变得平易近人。

技术亮点:性能与便利性的平衡

CLIP-ImageSearch-NCNN项目在技术实现上有几个值得关注的亮点:

-

使用NCNN框架: NCNN是一个高性能的神经网络推理框架,专为移动平台优化。使用NCNN部署CLIP模型,既保证了推理速度,又能适应移动设备的资源限制。

-

预计算与缓存: 项目采用了"先提取特征,后检索"的策略。虽然初次提取特征可能耗时较长,但这种方式大大加快了后续的搜索速度。

-

跨平台支持: 同时提供Android和x86版本,大大扩展了项目的应用范围。

-

开放模型下载: 作者贴心地将所有模型和执行文件上传到了GitHub,方便用户直接下载使用。

未来展望:更多可能性

虽然CLIP-ImageSearch-NCNN项目已经展示了令人印象深刻的功能,但仍有很大的发展空间:

-

多语言支持: 目前搜索仅支持英文输入,未来可以考虑加入多语言支持,特别是中文的支持。

-

结果优化: 当前版本只显示匹配概率最高的一个结果,未来可以展示更多相关图片,并按相似度排序。

-

实时处理: 探索如何在不影响用户体验的前提下,实现图片的实时特征提取。

-

集成到相册应用: 将这一功能直接集成到手机自带相册中,提供更seamless的用户体验。

-

扩展应用场景: 除了图片搜索,CLIP模型还可以应用于图像分类、内容审核等领域,值得进一步探索。

结语

CLIP-ImageSearch-NCNN项目展示了如何将前沿的AI技术转化为实用的应用。它不仅为图片搜索提供了一种新的范式,更为开发者展示了如何将复杂的深度学习模型部署到资源受限的设备上。

虽然该项目目前还处于相对早期的阶段,但其潜力是巨大的。随着更多开发者的参与和技术的进步,我们有理由相信,基于自然语言的图片搜索将会变得越来越普及,为用户提供更直观、更精准的图像检索体验。

最后,让我们向项目的作者EdVince和所有为开源社区做出贡献的开发者们致敬。正是因为有了他们的无私奉献,技术的创新才能如此快速地从实验室走向现实应用,造福更多的人。

如果你对这个项目感兴趣,不妨去GitHub上给它点个star,或者尝试运行demo,体验一下基于自然语言的图片搜索的魅力。相信这将会是一次有趣而富有启发性的体验!