CLIP-Retrieval: 构建高效的多模态语义检索系统

在当今的人工智能时代,多模态语义检索系统正变得越来越重要。CLIP-Retrieval作为一个强大的开源工具,为构建这类系统提供了便捷高效的解决方案。本文将详细介绍CLIP-Retrieval的功能、特点及应用,帮助读者了解如何利用这一工具构建自己的多模态检索系统。

CLIP-Retrieval简介

CLIP-Retrieval是由GitHub用户rom1504开发的开源项目,旨在简化CLIP(Contrastive Language-Image Pre-training)嵌入的计算过程,并基于这些嵌入构建检索系统。CLIP是OpenAI开发的一种多模态模型,能够理解图像和文本之间的语义关系。CLIP-Retrieval充分利用了CLIP的这一特性,使得用户可以轻松地构建基于语义的图像-文本检索系统。

主要功能

CLIP-Retrieval提供了一系列功能模块,包括:

-

CLIP客户端: 允许通过Python远程查询后端。

-

CLIP推理: 快速计算图像和文本嵌入(在3080 GPU上可达到1500样本/秒)。

-

CLIP索引: 基于嵌入构建高效索引。

-

CLIP过滤器: 使用CLIP索引对数据进行过滤。

-

CLIP后端: 使用简单的Flask服务托管索引。

-

CLIP前端: 一个简单的UI,用于查询后端。

-

CLIP端到端: 运行img2dataset、推理、索引,然后运行后端和前端,使整个过程更加简单。

这些模块共同构成了一个完整的语义搜索系统,使用户能够从原始数据到最终的检索界面,一站式完成整个流程。

安装与使用

CLIP-Retrieval的安装非常简单,只需通过pip安装即可:

pip install clip-retrieval

对于想要运行LAION5B索引的用户,可以参考项目文档中的详细说明。

CLIP客户端

CLIP-Retrieval提供了ClipClient类,允许用户通过Python远程查询CLIP-Retrieval后端。使用示例如下:

from clip_retrieval.clip_client import ClipClient, Modality

client = ClipClient(url="https://knn.laion.ai/knn-service", indice_name="laion5B-L-14")

# 文本查询

results = client.query(text="an image of a cat")

# 图像查询

cat_results = client.query(image="cat.jpg")

dog_results = client.query(image="https://example.com/dog.jpg")

# 嵌入查询

cat_results = client.query(embedding_input=cat_embedding)

CLIP推理

CLIP推理模块允许用户快速计算大量图像和文本的CLIP嵌入。使用示例:

clip-retrieval inference --input_dataset image_folder --output_folder embeddings_folder

这个命令将处理image_folder中的图像,并将计算得到的嵌入保存在embeddings_folder中。

CLIP索引

CLIP索引模块使用autofaiss库,基于CLIP推理的输出创建高效的索引。使用示例:

clip-retrieval index --embeddings_folder embeddings_folder --index_folder index_folder

CLIP后端

CLIP后端是一个简单的kNN服务后端,可以高效地处理查询请求。启动后端的示例命令:

echo '{"example_index": "output_folder"}' > indices_paths.json

clip-retrieval back --port 1234 --indices-paths indices_paths.json

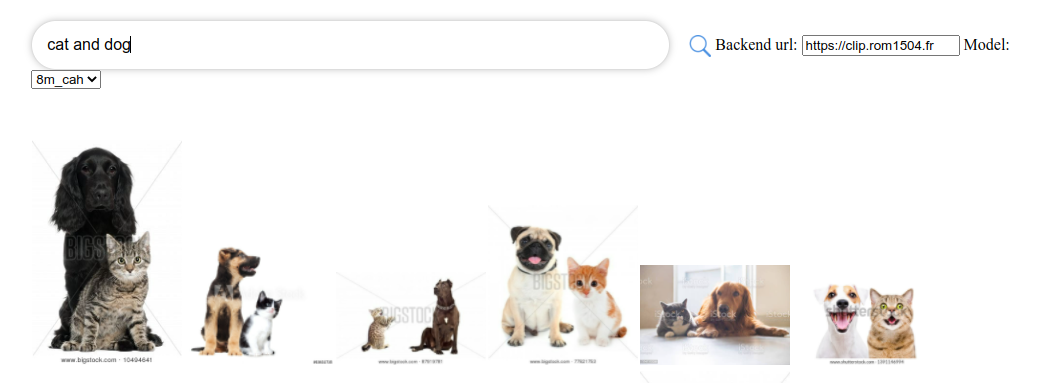

CLIP前端

CLIP-Retrieval还提供了一个简单的用户界面,可以直接连接到后端并显示检索结果。用户可以在clip-retrieval ui上体验,也可以通过以下命令在本地运行:

npm install -g clip-retrieval-front

clip-retrieval-front 3005

应用场景

CLIP-Retrieval的应用场景非常广泛,包括但不限于:

-

图像搜索引擎: 构建基于语义的图像搜索系统,用户可以通过文本描述查找相关图像。

-

内容推荐系统: 基于用户兴趣,推荐相关的图文内容。

-

数据集过滤与增强: 使用CLIP过滤器对大规模数据集进行语义过滤和增强。

-

多模态数据分析: 在科研或商业领域,分析图像与文本之间的语义关联。

-

创意设计辅助: 为设计师提供基于语义的图像检索工具,辅助创意过程。

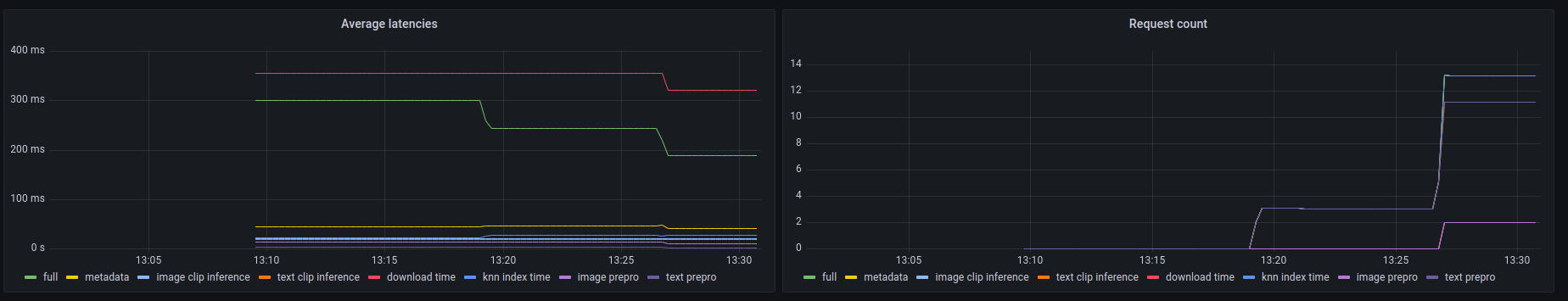

性能与扩展性

CLIP-Retrieval在处理大规模数据时表现出色。根据项目文档,使用3080 GPU可以在20小时内处理1亿条文本+图像嵌入。这种高效率使得CLIP-Retrieval能够应对大规模数据集的处理需求。

此外,CLIP-Retrieval还支持分布式处理,可以在多个节点和多个GPU上运行,进一步提高了处理速度和系统的可扩展性。

社区与生态

CLIP-Retrieval拥有活跃的开源社区,在GitHub上已获得2.3k+星标和200+分支。许多项目和研究都在使用CLIP-Retrieval,例如:

- cah-prepro: 使用CLIP-Retrieval处理400M图像+文本爬取数据集。

- autofaiss: 在其多模态笔记本示例中使用CLIP-Retrieval。

- antarctic-captions: 使用autofaiss和CLIP推理生成图像到文本任务的锚点。

这些应用案例展示了CLIP-Retrieval在实际项目中的价值和潜力。

未来展望

随着多模态AI技术的不断发展,CLIP-Retrieval也在持续更新和改进。未来,我们可以期待:

- 支持更多的CLIP模型变体,提供更丰富的选择。

- 进一步优化性能,支持更大规模的数据处理。

- 增强与其他AI工具和平台的集成能力。

- 提供更多的预训练索引和数据集,方便用户快速部署。

结语

CLIP-Retrieval为构建高效的多模态语义检索系统提供了强大而灵活的工具集。无论是研究人员、开发者还是企业用户,都可以利用CLIP-Retrieval快速构建和部署自己的检索系统。随着技术的不断进步和社区的持续贡献,CLIP-Retrieval必将在多模态AI应用领域发挥越来越重要的作用。

如果您对构建语义检索系统感兴趣,不妨尝试使用CLIP-Retrieval,探索其强大的功能,为您的项目注入新的活力。同时,也欢迎您为这个开源项目贡献自己的力量,共同推动多模态AI技术的发展。