对比式无配对图像翻译(CUT)简介

对比式无配对图像翻译(Contrastive Unpaired Translation, CUT)是由加州大学伯克利分校和Adobe研究院的研究人员在2020年ECCV会议上提出的一种新型图像到图像翻译方法。该方法基于分块对比学习和对抗学习,无需手工设计损失函数和反向网络,相比传统的CycleGAN等方法具有更快的训练速度和更低的内存消耗。

CUT的核心思想是最大化输入图像块和输出图像块之间的互信息,从而实现跨域图像翻译。具体来说,CUT使用多层次的分块方法,而不是对整张图像进行操作。此外,CUT从输入图像本身而不是数据集中的其他图像中提取负样本。这些设计使得CUT能够在无配对数据的情况下实现高质量的图像翻译,甚至可以扩展到单图像训练的场景。

CUT的核心原理

1. 分块对比学习

CUT的核心是分块对比学习。对于输入图像x和生成的输出图像G(x),CUT从多个层次提取特征图,并从这些特征图中随机采样L个位置,得到两组特征向量{ql}和{kl}。CUT的目标是最大化这两组特征向量之间的互信息。

具体的损失函数如下:

def PatchNCELoss(f_q, f_k, tau=0.07):

B, C, S = f_q.shape

l_pos = (f_k * f_q).sum(dim=1)[:, :, None]

l_neg = torch.bmm(f_q.transpose(1, 2), f_k)

identity_matrix = torch.eye(S)[None, :, :]

l_neg.masked_fill_(identity_matrix, -float('inf'))

logits = torch.cat((l_pos, l_neg), dim=2) / tau

predictions = logits.flatten(0, 1)

targets = torch.zeros(B * S, dtype=torch.long)

return cross_entropy_loss(predictions, targets)

这个损失函数鼓励对应的图像块映射到特征空间中的相似位置,同时与其他图像块保持距离。

2. 对抗学习

除了对比学习损失,CUT还使用了对抗学习来进一步提高生成图像的质量。生成器G和判别器D进行对抗训练,其中D试图区分真实图像和生成图像,而G则试图生成能够骗过D的逼真图像。

3. 身份保持损失

为了保持图像内容的一致性,CUT还引入了身份保持损失。这个损失鼓励生成器在源域内的图像上表现为恒等映射。

CUT的优势特点

相比传统的CycleGAN等方法,CUT具有以下优势:

-

更快的训练速度:CUT不需要反向映射网络,大大减少了训练时间。

-

更低的内存消耗:由于采用分块方法,CUT的内存消耗显著降低,可以处理更大尺寸的图像。

-

单图像训练能力:CUT可以扩展到每个"域"只有一张图像的极端情况,实现单图像的无监督翻译。

-

更强的分布匹配能力:通过对比学习,CUT能够学习到更强大的跨域分布匹配。

CUT的应用实例

1. 无配对图像到图像翻译

CUT在多个经典的图像翻译任务上都取得了优秀的效果,如马到斑马、猫到狗等。下图展示了CUT在不同数据集上的翻译结果:

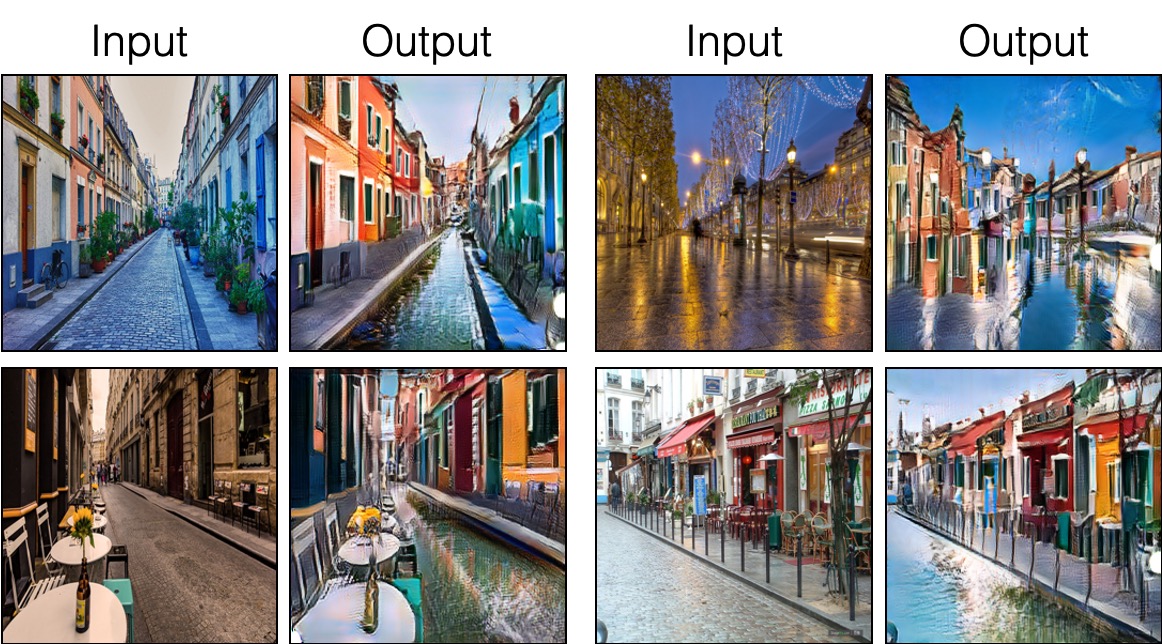

2. 单图像无配对翻译

CUT的一个独特应用是单图像翻译,即每个域只有一张图像的情况。这在艺术风格迁移等任务中非常有用。下图展示了将巴黎街景转换为布拉诺彩色房屋的效果:

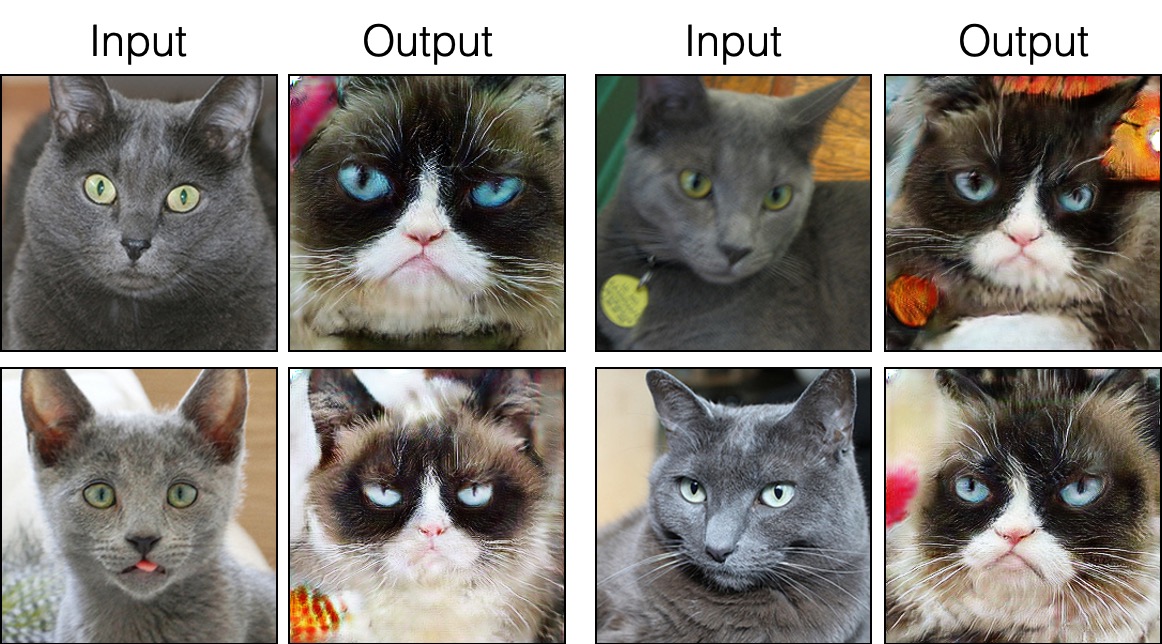

3. 俄罗斯蓝猫到生气猫的转换

CUT还可以实现更细粒度的图像转换,如将俄罗斯蓝猫转换为"生气猫"(Grumpy Cat):

CUT的实现与使用

CUT的官方实现基于PyTorch框架。要使用CUT,需要以下环境:

- Linux或macOS

- Python 3

- CPU或NVIDIA GPU + CUDA CuDNN

安装步骤如下:

- 克隆代码仓库:

git clone https://github.com/taesungp/contrastive-unpaired-translation CUT

cd CUT

- 安装依赖:

pip install -r requirements.txt

- 下载数据集:

bash ./datasets/download_cut_dataset.sh grumpifycat

- 训练模型:

python train.py --dataroot ./datasets/grumpifycat --name grumpycat_CUT --CUT_mode CUT

- 测试模型:

python test.py --dataroot ./datasets/grumpifycat --name grumpycat_CUT --CUT_mode CUT --phase train

更多详细的使用说明和高级功能,可以参考CUT的官方GitHub仓库。

CUT与其他方法的对比

CUT主要与CycleGAN进行了对比。相比CycleGAN,CUT在以下方面表现更优:

- 训练速度:CUT的训练速度是CycleGAN的两倍。

- 内存消耗:CUT只需要CycleGAN一半的GPU内存。

- 图像质量:CUT生成的图像质量通常优于CycleGAN。

- 分布匹配:CUT能够学习到更强大的跨域分布匹配。

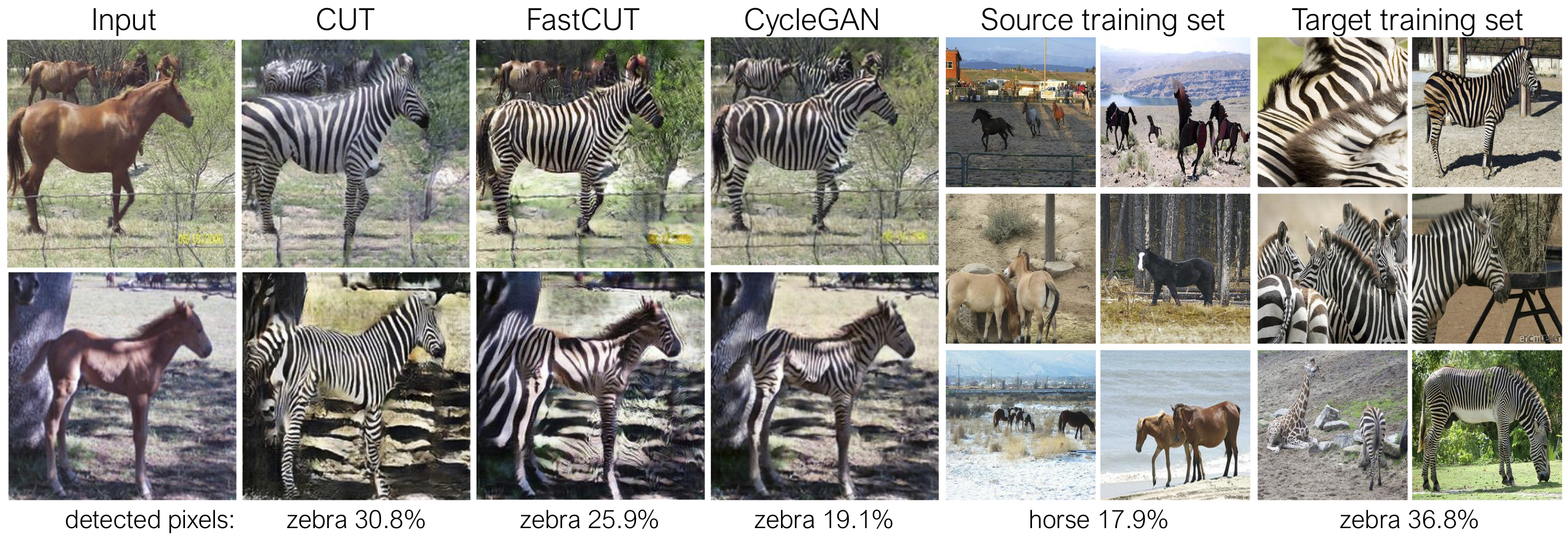

下图展示了CUT、FastCUT(CUT的轻量版本)和CycleGAN在马到斑马转换任务上的对比:

可以看到,CUT生成的斑马图像在大小和比例上更接近真实斑马的分布。

总结与展望

对比式无配对图像翻译(CUT)作为一种新型的图像到图像翻译方法,通过创新的分块对比学习策略,在训练速度、内存消耗和生成质量等多个方面都取得了显著的进步。CUT不仅在传统的无配对图像翻译任务中表现出色,还开创了单图像翻译的新应用场景,为图像处理和计算机视觉领域带来了新的可能性。

未来,CUT技术还有很大的发展空间。可能的研究方向包括:

- 进一步提高生成图像的质量和真实度。

- 扩展到更多样化的应用场景,如医学图像处理、遥感图像分析等。

- 结合其他先进技术,如自监督学习、元学习等,进一步提升模型的性能和泛化能力。

- 探索CUT在视频处理、3D图像转换等更复杂任务中的应用。

总的来说,CUT为图像到图像翻译领域带来了新的思路和方法,其简洁高效的设计理念值得研究者和开发者深入探索和应用。随着技术的不断发展和完善,我们可以期待看到更多基于CUT的创新应用在未来涌现。

参考资料

-

Park, T., Efros, A. A., Zhang, R., & Zhu, J. Y. (2020). Contrastive Learning for Unpaired Image-to-Image Translation. In European Conference on Computer Vision (pp. 319-345). Springer, Cham.

-

CUT官方GitHub仓库: https://github.com/taesungp/contrastive-unpaired-translation

-

Zhu, J. Y., Park, T., Isola, P., & Efros, A. A. (2017). Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks. In Proceedings of the IEEE International Conference on Computer Vision (pp. 2223-2232).

-

Isola, P., Zhu, J. Y., Zhou, T., & Efros, A. A. (2017). Image-to-Image Translation with Conditional Adversarial Networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (pp. 1125-1134).