Computer Vision in the Wild: 开启计算机视觉的新纪元

近年来,随着人工智能和深度学习技术的飞速发展,计算机视觉领域取得了长足的进步。然而,传统的计算机视觉模型往往局限于特定的任务和数据集,难以应对真实世界中复杂多变的视觉场景。为了克服这一挑战,一个名为"Computer Vision in the Wild" (CVinW)的新兴研究领域应运而生,旨在开发能够灵活适应各种视觉任务的通用模型。本文将深入探讨CVinW的核心理念、主要特点和最新进展,展望这一领域未来的发展方向。

CVinW的核心理念:构建通用视觉基础模型

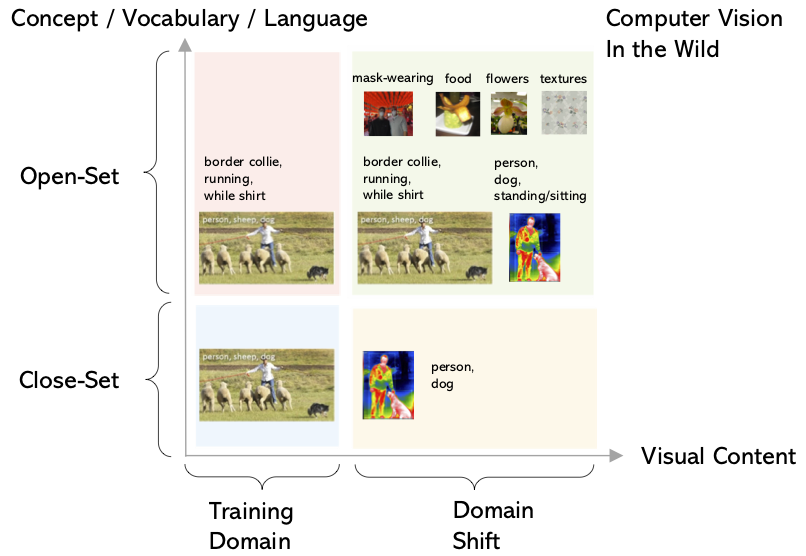

CVinW的核心目标是开发一个可迁移的视觉基础模型或系统,能够轻松适应真实世界中的各种视觉任务。与传统的计算机视觉方法不同,CVinW强调模型的通用性和灵活性,追求在广泛的任务转移场景中实现低成本的模型适应。

具体来说,CVinW的核心理念可以概括为以下两个关键特征:

- 广泛的任务转移场景

CVinW模型能够处理各种不同的视觉任务,如图像分类、目标检测、语义分割等。更重要的是,这些模型可以适应新的视觉域和概念,而不仅仅局限于训练数据中出现的场景和类别。

- 低成本的任务转移

CVinW模型可以以极低的成本适应新任务,无需大量的标注数据和计算资源。这种高效的模型适应能力使得CVinW在实际应用中具有巨大的潜力。

图1: CVinW与其他计算机视觉设置的对比

CVinW的主要特点:灵活性与效率并重

为了实现上述核心理念,CVinW研究主要关注以下几个方面:

- 跨任务和跨域泛化能力

CVinW模型能够在不同的视觉任务和视觉域之间进行灵活迁移。例如,一个在自然图像上训练的模型可以迁移到医学图像分析或工业检测等领域,而无需大量的领域特定数据。

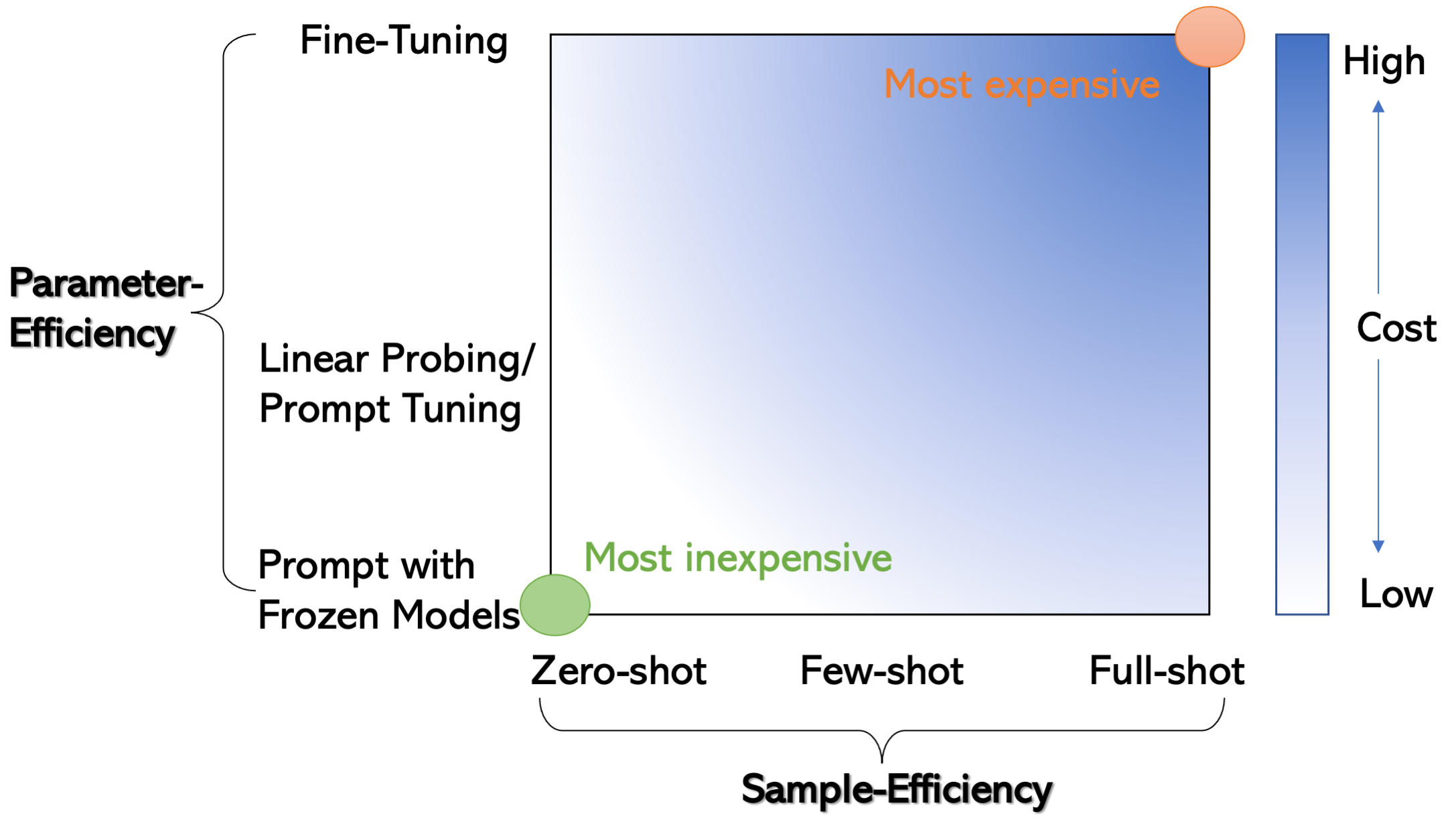

- 样本效率

CVinW模型追求高样本效率,能够在极少量的标注数据(甚至零样本)情况下快速适应新任务。这一特点大大降低了模型应用的成本和难度。

- 参数效率

除了样本效率,CVinW还注重参数效率。研究者们探索了各种参数高效的模型适应方法,如提示学习(prompt tuning)、线性探测(linear probing)等,以最小化模型适应所需的可训练参数数量。

图2: 模型适应成本的二维图表

CVinW的最新进展:多模态学习引领潮流

近年来,CVinW领域取得了一系列重要突破,其中最引人注目的是基于多模态学习的方法。通过结合视觉和语言信息,研究者们开发出了一批性能优异的CVinW模型。以下是一些代表性的工作:

- CLIP (Contrastive Language-Image Pre-training)

OpenAI团队提出的CLIP模型是CVinW领域的里程碑之作。CLIP通过大规模的图像-文本对预训练,学习了强大的视觉-语言对齐表示,展现出惊人的零样本迁移能力。

- ALIGN (A Large-scale ImaGe and Noisy-text embedding)

Google研究团队提出的ALIGN模型进一步扩大了训练规模,使用了超过10亿张图像-文本对进行训练,在多项视觉任务上取得了state-of-the-art的性能。

- Florence

微软研究院开发的Florence模型是一个统一的视觉基础模型,可以支持多种下游视觉任务。Florence在大规模图像-文本数据上进行预训练,并引入了多任务学习和对比学习等技术,展现出优秀的泛化能力。

- GLIP (Grounded Language-Image Pre-training)

GLIP模型将视觉-语言预训练与目标检测任务相结合,通过学习视觉-语言对齐和目标定位能力,实现了开放词汇目标检测的突破。

- Grounding DINO

Grounding DINO模型将DINO (self-DIstillation with NO labels)自监督学习方法与基于语言的目标检测相结合,在开放集目标检测任务上取得了显著进展。

这些模型的成功充分展示了多模态学习在CVinW领域的巨大潜力。通过融合视觉和语言信息,模型可以学习到更加丰富和通用的表示,从而在各种视觉任务中表现出色。

CVinW的应用前景:赋能智能视觉系统

作为一个快速发展的研究领域,CVinW正在为各种实际应用场景带来新的可能性。以下是一些潜在的应用方向:

- 智能监控系统

CVinW模型可以应用于智能监控系统,实现对各种异常事件的实时检测和识别,而无需为每种可能的场景单独训练模型。

- 医学图像分析

在医学领域,CVinW模型可以帮助快速开发各种疾病诊断工具,即使对于罕见疾病或新出现的病症,也能够快速适应并提供准确的分析结果。

- 工业质量控制

CVinW技术可以应用于工业生产线的质量控制,灵活适应不同产品和缺陷类型,提高检测效率和准确性。

- 自动驾驶

在自动驾驶领域,CVinW模型可以帮助车辆视觉系统更好地应对各种复杂的道路场景和意外情况,提高行车安全性。

- 增强现实

CVinW技术可以为增强现实应用提供更加智能和灵活的视觉理解能力,实现更自然和沉浸式的用户体验。

CVinW的未来发展方向

尽管CVinW领域已经取得了令人瞩目的进展,但仍然存在许多待解决的挑战和值得探索的方向:

- 模型效率与性能的平衡

如何在保持模型高性能的同时,进一步提高其计算效率和推理速度,是CVinW领域面临的一个重要挑战。

- 跨模态理解的深化

进一步加强视觉与语言等其他模态之间的联系,实现更深层次的跨模态理解和推理能力。

- 可解释性和鲁棒性

提高CVinW模型的可解释性和鲁棒性,使其在实际应用中更加可靠和可信赖。

- 持续学习能力

探索使CVinW模型具备持续学习的能力,能够不断从新数据中学习和更新知识,而不会遗忘已掌握的技能。

- 与其他AI技术的融合

将CVinW与强化学习、图神经网络等其他AI技术相结合,开发出更加智能和通用的视觉系统。

结语

Computer Vision in the Wild作为一个充满活力的新兴研究领域,正在为计算机视觉技术带来革命性的变革。通过追求通用性、灵活性和效率,CVinW有望突破传统计算机视觉的局限,开发出能够真正适应"野外"复杂环境的智能视觉系统。随着研究的不断深入和技术的持续进步,我们可以期待CVinW在未来为各行各业带来更多创新应用,推动人工智能技术向着更加通用和智能的方向发展。

参考资源

- CVinW Readings GitHub仓库: https://github.com/Computer-Vision-in-the-Wild/CVinW_Readings

- ELEVATER基准测试: https://computer-vision-in-the-wild.github.io/ELEVATER/

- CVPR 2023 CVinW研讨会: https://computer-vision-in-the-wild.github.io/cvpr-2023/

通过持续关注这一领域的最新进展,我们将能够见证计算机视觉技术在"野外"环境中的蓬勃发展,并为其贡献自己的力量。让我们共同期待CVinW为人工智能和计算机视觉带来的无限可能!