datasketch:让大数据分析更快更省

在当今数据爆炸的时代,如何高效地处理和分析海量数据成为了一个巨大的挑战。传统的精确算法在面对TB甚至PB级别的数据时往往力不从心,耗时长、内存消耗大。而概率数据结构(Probabilistic Data Structures)为我们提供了一个绝佳的解决方案 - 以很小的准确性损失换取巨大的性能提升。datasketch正是这样一个强大的Python库,它实现了多种先进的概率数据结构,让开发者可以轻松地应对大数据处理的挑战。

datasketch的核心优势

datasketch的最大特点就是"让大数据变小"。它提供的各种数据结构都具有如下共同优势:

-

极低的内存占用:即使面对数十亿级别的数据集,datasketch的数据结构通常只需要几KB到几MB的内存。

-

超快的处理速度:大多数操作的时间复杂度为O(1)或O(log n),可以在毫秒级完成。

-

可调节的精度:用户可以通过参数来平衡准确度和资源消耗。

-

支持流式处理:可以增量式地处理数据流,无需一次性加载所有数据。

-

易于使用:API设计简洁直观,集成到现有项目中非常方便。

这些优势使得datasketch特别适合于大规模数据的相似性搜索、去重、基数估计等任务。无论是在数据清洗、用户行为分析,还是推荐系统构建等场景中,datasketch都能大显身手。

datasketch提供的主要数据结构

datasketch实现了多种经典和前沿的概率数据结构,主要包括:

-

MinHash:用于估计集合间的Jaccard相似度和基数。

-

Weighted MinHash:可以处理带权重的集合相似度估计。

-

HyperLogLog:用于基数估计(即统计不重复元素数量)。

-

HyperLogLog++:HyperLogLog的改进版本,提供更好的准确性。

-

LSH(Locality Sensitive Hashing):支持大规模数据的相似性搜索。

-

LSH Forest:LSH的改进版本,支持Top-K查询。

-

LSH Ensemble:专门针对集合包含关系查询优化的LSH变体。

-

HNSW(Hierarchical Navigable Small World):支持高维向量的近似最近邻搜索。

这些数据结构覆盖了大数据处理中的多个关键领域,为开发者提供了一站式的解决方案。

深入了解核心数据结构

接下来,让我们深入了解datasketch中几个最常用和最强大的数据结构。

MinHash:高效估计集合相似度

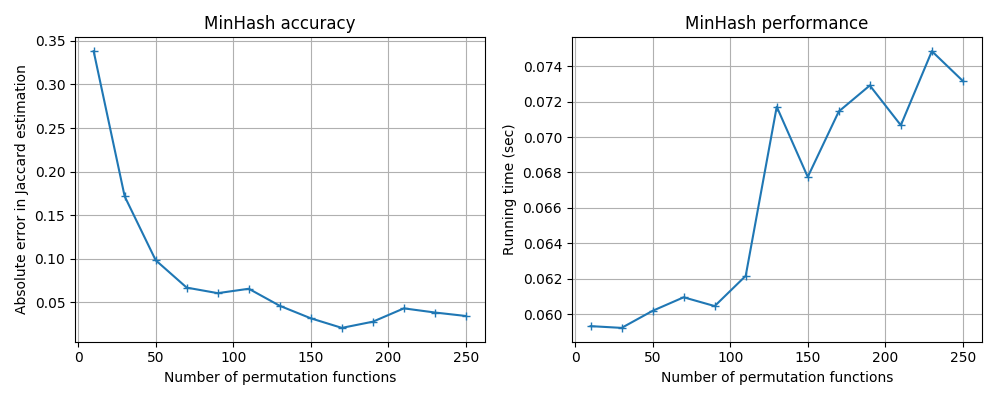

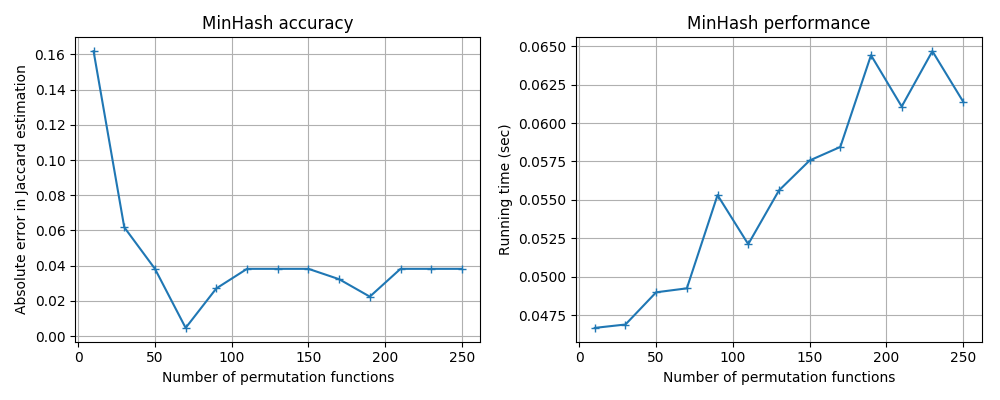

MinHash是datasketch的核心数据结构之一,它可以在常数时间内估计两个集合的Jaccard相似度。其基本原理是通过哈希函数将集合映射到一个小的签名,然后比较签名来估计相似度。

使用MinHash非常简单:

from datasketch import MinHash

# 创建两个MinHash对象

m1, m2 = MinHash(), MinHash()

# 向MinHash对象添加数据

for d in ['a', 'b', 'c', 'd']:

m1.update(d.encode('utf8'))

for d in ['c', 'd', 'e', 'f']:

m2.update(d.encode('utf8'))

# 估计Jaccard相似度

print("Estimated Jaccard:", m1.jaccard(m2))

# 估计集合的基数(不重复元素数量)

print("Estimated cardinality:", m1.count())

MinHash不仅可以估计相似度,还可以用于基数估计、集合并集等操作,是一个非常versatile的工具。

LSH(Locality Sensitive Hashing):大规模相似性搜索

当我们需要在海量数据中快速找出与给定项相似的其他项时,LSH就派上了大用场。它可以将相似的项以较大概率哈希到相同的"桶"中,从而大大缩小搜索范围。

datasketch提供了MinHashLSH类来支持基于MinHash的LSH索引:

from datasketch import MinHash, MinHashLSH

lsh = MinHashLSH(threshold=0.5, num_perm=128)

# 添加文档到LSH索引

for i, doc in enumerate(documents):

minhash = MinHash(num_perm=128)

for word in doc:

minhash.update(word.encode('utf8'))

lsh.insert(f"doc_{i}", minhash)

# 查询相似文档

query = MinHash(num_perm=128)

for word in query_doc:

query.update(word.encode('utf8'))

result = lsh.query(query)

print("Similar documents:", result)

LSH使得在亿级数据中进行相似性搜索成为可能,广泛应用于去重、聚类、推荐系统等场景。

HyperLogLog:超高效的基数估计

在大数据分析中,我们经常需要估计一个大集合中不重复元素的数量(即基数)。HyperLogLog可以在使用极小内存的情况下,给出一个较为准确的估计。

from datasketch import HyperLogLog

hll = HyperLogLog()

# 添加元素

for i in range(1000000):

hll.update(str(i).encode('utf8'))

# 估计基数

print("Estimated cardinality:", hll.count())

HyperLogLog在处理流量统计、用户数统计等场景中表现出色,可以轻松应对PB级别的数据。

datasketch的实际应用案例

datasketch在多个领域都有广泛应用,下面是几个典型的使用场景:

-

网页去重:使用MinHash和LSH可以快速识别并去除爬虫抓取的重复网页。

-

用户行为分析:利用HyperLogLog估算网站的日活跃用户数(DAU)。

-

推荐系统:使用LSH Forest实现基于内容的item-to-item推荐。

-

异常检测:通过比较多个时间窗口的MinHash签名,检测数据流中的异常模式。

-

大规模聚类:结合MinHash和LSH实现海量文本数据的快速聚类。

-

相似图片搜索:将图片特征向量存入HNSW索引,实现大规模的相似图片检索。

这些应用充分展示了datasketch在处理大规模数据时的强大能力。

使用datasketch的最佳实践

为了充分发挥datasketch的性能,这里有一些建议:

-

根据数据规模和要求的精度,合理设置参数(如MinHash的排列数)。

-

对于大规模数据,考虑使用datasketch提供的Redis或Cassandra存储后端。

-

在处理流式数据时,利用数据结构的增量更新特性。

-

对于MinHash,选择合适的哈希函数可以提升性能,如MurmurHash3。

-

在分布式环境中,利用MinHash等结构的可合并性实现并行处理。

-

对于高维数据,考虑使用HNSW代替传统的LSH,以获得更好的查询性能。

遵循这些最佳实践,可以让您在各种大数据场景中更好地运用datasketch。

总结与展望

datasketch为处理和分析大规模数据集提供了一套高效、灵活的工具。通过巧妙地运用概率算法,它让开发者可以在有限的计算资源下快速获得有价值的数据洞察。随着大数据和AI技术的不断发展,datasketch这样的概率数据结构库必将发挥越来越重要的作用。

未来,我们可以期待datasketch在以下方面继续演进:

-

支持更多新兴的概率数据结构,如Count-Min Sketch、Bloom Filter等。

-

提供更好的GPU加速支持,进一步提升性能。

-

增强与大数据生态系统(如Spark、Flink等)的集成。

-

改进现有算法,在准确性和效率之间取得更好的平衡。

总之,datasketch为我们提供了一个强大的武器来应对大数据时代的挑战。无论您是数据科学家、软件工程师还是研究人员,都值得将datasketch纳入您的工具箱,探索它在您特定领域的应用潜力。让我们一起拥抱概率算法,让大数据分析变得更快、更省、更智能!