深入解析RAG技术: 检索增强生成如何提升大语言模型的能力

RAG技术简介

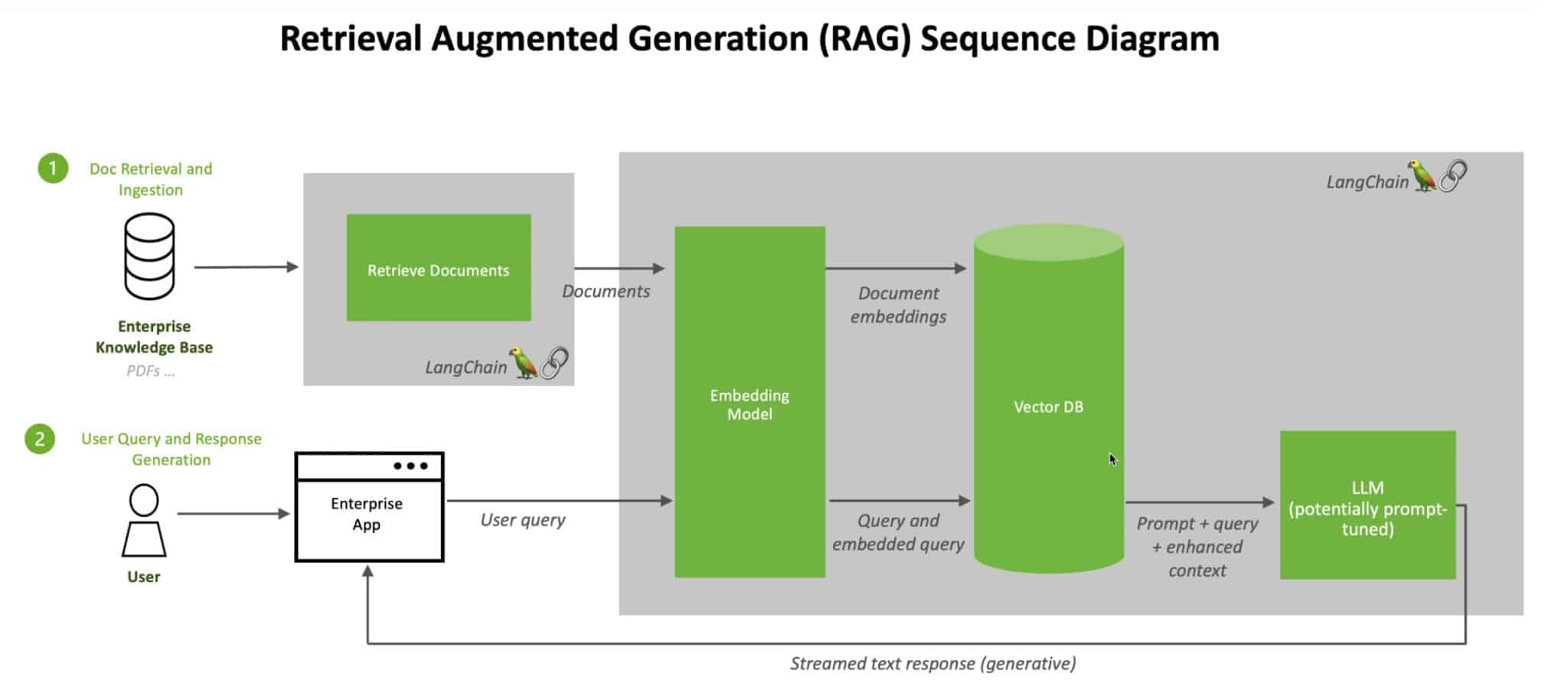

在人工智能领域中,RAG (Retrieval Augmented Generation)技术正在迅速崛起,成为提升大语言模型(LLMs)性能的关键方法之一。RAG通过将外部知识库的检索能力与LLMs的生成能力相结合,极大地增强了AI系统回答问题和生成内容的准确性和可靠性。

RAG的核心思想

RAG的核心思想非常简单而优雅:在生成回答之前,先从外部知识库中检索相关信息,然后将这些信息作为上下文提供给语言模型,从而引导模型生成更加准确、相关和有依据的回答。这种方法弥补了LLMs仅依赖训练数据的局限性,使其能够利用最新、最相关的外部知识。

RAG的诞生背景

RAG技术的诞生可以追溯到2020年。当时,来自Facebook AI Research(现Meta AI)、伦敦大学学院和纽约大学的研究人员在一篇开创性论文中首次提出了这一概念。论文的主要作者Patrick Lewis回忆道,他们当时正在寻找一种方法来增强语言模型的知识容量,并开发了一个基准来衡量进展。

Lewis表示:"我们有一个令人信服的愿景,即一个训练有素的系统,其中间有一个检索索引,因此它可以学习并生成您想要的任何文本输出。"这个愿景最终演变成了今天我们所知的RAG技术。

RAG的工作原理

要深入理解RAG,我们需要剖析其工作流程:

-

查询处理:当用户提出问题时,RAG系统首先对查询进行处理。

-

信息检索:系统使用嵌入模型将查询转换为机器可读的数值格式(向量)。然后,它在知识库索引中搜索与这个向量最相似的匹配项。

-

上下文生成:系统从检索到的相关文档中提取信息,形成上下文。

-

LLM生成:将上下文与原始查询一起输入到LLM中。LLM基于这些信息生成最终回答。

-

结果呈现:系统将生成的回答呈现给用户,通常还会包含引用的信息来源。

这个过程像是一个智能的法官助理系统。就如同法官在审理案件时,有时需要书记员去法律图书馆查找相关判例和具体案例以供引用。RAG系统扮演了这个"AI书记员"的角色,为LLM提供必要的背景信息和事实依据。

RAG的优势和应用

RAG技术为AI系统带来了多方面的优势:

-

提高准确性:通过引入外部知识,RAG显著减少了LLMs生成错误信息或"幻觉"的可能性。

-

增强可信度:RAG系统能够提供信息来源,使用户可以验证AI生成内容的可靠性。

-

实时性:RAG允许AI系统访问最新信息,克服了传统LLMs仅依赖训练数据的局限性。

-

灵活性:可以根据需要轻松更新或替换知识库,无需重新训练整个模型。

-

领域适应性:通过连接特定领域的知识库,RAG可以快速适应各种专业场景。

这些优势使RAG在多个领域找到了广泛应用:

- 医疗健康:结合医学文献库,RAG可以协助医生进行诊断和治疗决策。

- 金融服务:连接实时市场数据,RAG可以为分析师提供更准确的金融洞察。

- 客户支持:RAG可以访问产品手册和常见问题解答,提供精准的客户服务。

- 法律咨询:结合法律数据库,RAG可以协助律师快速检索相关法规和案例。

RAG的技术实现

实现RAG系统涉及多个关键组件:

- 嵌入模型:负责将文本转换为向量表示。

- 向量数据库:存储和索引知识库的向量表示。

- 检索系统:基于相似度搜索找到最相关的信息。

- 大语言模型:生成最终的回答。

许多开发者发现LangChain等开源库在链接LLMs、嵌入模型和知识库方面特别有用。NVIDIA也提供了RAG的参考架构,包括使用NVIDIA NeMo框架来开发和定制生成式AI模型。

RAG的未来发展

随着AI技术的快速发展,RAG也在不断演进。以下是一些值得关注的趋势:

-

图RAG:利用知识图谱或语义图来生成上下文,提供更结构化的信息检索。

-

多模态RAG:将文本、图像、音频等多种数据类型整合到检索和生成过程中。

-

动态RAG:根据用户交互和反馈实时调整检索策略。

-

分布式RAG:在边缘设备上实现RAG,提高隐私保护和响应速度。

-

自适应RAG:系统能够学习和优化检索策略,以提供更相关的上下文。

结语

RAG技术代表了AI系统向更智能、更可靠方向发展的重要一步。通过将人类积累的知识与AI的生成能力相结合,RAG开启了一个新的可能性空间,使AI系统能够更好地服务于各行各业的需求。

随着技术的不断进步,我们可以期待看到更多创新的RAG应用,推动AI系统在准确性、可解释性和实用性方面取得突破。对于开发者和企业来说,深入了解和掌握RAG技术将成为在AI时代保持竞争力的关键。

无论是改进现有的AI系统,还是开发全新的智能应用,RAG都提供了一个强大而灵活的框架。让我们共同期待RAG技术带来的更多惊喜和突破,推动人工智能向着更加智慧和有益于人类的方向发展。

编辑推荐精选

讯飞智文

一键生成PPT和Word,让学习生活更轻松

讯飞智文是一个利用 AI 技术的项目,能够帮助用户生成 PPT 以及各类文档。无论是商业领域的市场分析报告、年度目标制定,还是学生群体的职业生涯规划、实习避坑指南,亦或是活动策划、旅游攻略等内容,它都能提供支持,帮助用户精准表达,轻松呈现各种信息。

讯飞星火

深度推理能力全新升级,全面对标OpenAI o1

科大讯飞的星火大模型,支持语言理解、知识问答和文本创作等多功能,适用于多种文件和业务场景,提升办公和日常生活的效率。讯飞星火是一个提供丰富智能服务的平台,涵盖科技资讯、图像创作、写作辅助、编程解答、科研文献解读等功能,能为不同需求的用户提供便捷高效的帮助,助力用户轻松获取信息、解决问题,满足多样化使用场景。

Spark-TTS

一种基于大语言模型的高效单流解耦语音令牌文本到语音合成模型

Spark-TTS 是一个基于 PyTorch 的开源文本到语音合成项目,由多个知名机构联合参与。该项目提供了高效的 LLM(大语言模型)驱动的语音合成方案,支持语音克隆和语音创建功能,可通过命令行界面(CLI)和 Web UI 两种方式使用。用户可以根据需求调整语音的性别、音高、速度等参数,生成高质量的语音。该项目适用于多种场景,如有声读物制作、智能语音助手开发等。

Trae

字节跳动发布的AI编程神器IDE

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

咔片PPT

AI助力,做PPT更简单!

咔片是一款轻量化在线演示设计工具,借助 AI 技术,实现从内容生成到智能设计的一站式 PPT 制作服务。支持多种文档格式导入生成 PPT,提供海量�模板、智能美化、素材替换等功能,适用于销售、教师、学生等各类人群,能高效制作出高品质 PPT,满足不同场景演示需求。

讯飞绘文

选题、配图、成文,一站式创作,让内容运营更高效

讯飞绘文,一个AI集成平台,支持写作、选题、配图、排版和发布。高效生成适用于各类媒体的定制内容,加速品牌传播,提升内容营销效果。

材料星

专业的AI公文写作平台,公文写作神器

AI 材料星,专业的 AI 公文写作辅助平台,为体制内工作人员提供高效的公文写作解决方案。拥有海量公文文库、9 大核心 AI 功能,支持 30 + 文稿类型生成,助力快速完成领导讲话、工作总结、述职报告等材料,提升办公效率,是体制打工人的得力写作神器。

openai-agents-python

OpenAI Agents SDK,助力开发者便捷使用 OpenAI 相关功能。

openai-agents-python 是 OpenAI 推出的一款强大 Python SDK,它为开发者提供了与 OpenAI 模型交互的高效工具,支持工具调用、结果处理、追踪等功能,涵盖多种应用场景,如研究助手、财务研究等,能显著提升开发效率,让开发者更轻松地利用 OpenAI 的技术优势。

Hunyuan3D-2

高分辨率纹理 3D 资产生成

Hunyuan3D-2 是腾讯开发的用于 3D 资产生成的强大工具,支持从文本描述、单张图片或多视角图片生成 3D 模型,具备快速形状生成能力,可生成带纹理的高质量 3D 模型,适用于多个领域,为 3D 创作提供了高效解决方案。

3FS

一个具备存储、管理和客户端操作等多种功能的分布式文件系统相关项目。

3FS 是一个功能强大的分布式文件系统项目,涵盖了存储引擎、元数据管理、客户端工具等多个模块。它支持多种文件操作,如创建文件和目录、设置布局等,同时具备高效的事件循环、节点选择和协程池管理等特性。适用于需要大规模数据存储和管理的场景,能够提高系统的性能和可靠性,是分布式存储领域的优质解决方案。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号