深度强化学习与PyTorch:全面指南

深度强化学习是人工智能领域一个极具前景的研究方向,它结合了深度学习和强化学习的优势,能够解决复杂的决策问题。本文将全面介绍如何使用PyTorch实现深度强化学习算法,包括理论基础和代码实现。

1. 深度强化学习简介

深度强化学习是指使用深度神经网络来近似强化学习中的价值函数或策略函数。与传统的强化学习方法相比,深度强化学习能够处理高维状态空间,直接从原始感知数据中学习决策策略。

深度强化学习的核心思想是:

- 使用深度神经网络作为函数近似器

- 通过与环境交互收集经验数据

- 利用经验回放提高样本效率

- 使用目标网络稳定训练过程

2. PyTorch简介

PyTorch是一个开源的机器学习框架,它具有以下特点:

- 动态计算图,便于调试

- 强大的GPU加速能力

- 丰富的深度学习模块

- 良好的Python集成

这些特性使PyTorch成为实现深度强化学习算法的理想工具。

3. DQN算法实现

DQN(Deep Q-Network)是深度强化学习的开山之作,它成功地将深度学习应用到了Q学习中。DQN的核心思想包括:

- 使用卷积神经网络处理图像输入

- 使用经验回放打破样本相关性

- 使用目标网络稳定训练

下面是DQN的PyTorch实现示例:

import torch

import torch.nn as nn

class DQN(nn.Module):

def __init__(self, input_shape, n_actions):

super(DQN, self).__init__()

self.conv = nn.Sequential(

nn.Conv2d(input_shape[0], 32, kernel_size=8, stride=4),

nn.ReLU(),

nn.Conv2d(32, 64, kernel_size=4, stride=2),

nn.ReLU(),

nn.Conv2d(64, 64, kernel_size=3, stride=1),

nn.ReLU()

)

conv_out_size = self._get_conv_out(input_shape)

self.fc = nn.Sequential(

nn.Linear(conv_out_size, 512),

nn.ReLU(),

nn.Linear(512, n_actions)

)

def _get_conv_out(self, shape):

o = self.conv(torch.zeros(1, *shape))

return int(np.prod(o.size()))

def forward(self, x):

conv_out = self.conv(x).view(x.size()[0], -1)

return self.fc(conv_out)

4. DDPG算法实现

DDPG(Deep Deterministic Policy Gradient)是一种用于连续动作空间的actor-critic算法。它的主要特点包括:

- 使用确定性策略

- 使用经验回放和软更新

- 使用噪声探索

DDPG的PyTorch实现示例:

class Actor(nn.Module):

def __init__(self, state_dim, action_dim, max_action):

super(Actor, self).__init__()

self.l1 = nn.Linear(state_dim, 400)

self.l2 = nn.Linear(400, 300)

self.l3 = nn.Linear(300, action_dim)

self.max_action = max_action

def forward(self, x):

x = F.relu(self.l1(x))

x = F.relu(self.l2(x))

x = self.max_action * torch.tanh(self.l3(x))

return x

class Critic(nn.Module):

def __init__(self, state_dim, action_dim):

super(Critic, self).__init__()

self.l1 = nn.Linear(state_dim + action_dim, 400)

self.l2 = nn.Linear(400, 300)

self.l3 = nn.Linear(300, 1)

def forward(self, x, u):

x = F.relu(self.l1(torch.cat([x, u], 1)))

x = F.relu(self.l2(x))

x = self.l3(x)

return x

5. PPO算法实现

PPO(Proximal Policy Optimization)是一种简单而有效的策略梯度算法。它的主要思想是:

- 使用重要性采样

- 使用截断的目标函数

- 使用多个epoch更新策略

PPO的PyTorch实现示例:

class PPO(nn.Module):

def __init__(self, state_dim, action_dim):

super(PPO, self).__init__()

self.actor = nn.Sequential(

nn.Linear(state_dim, 64),

nn.Tanh(),

nn.Linear(64, 64),

nn.Tanh(),

nn.Linear(64, action_dim),

nn.Softmax(dim=-1)

)

self.critic = nn.Sequential(

nn.Linear(state_dim, 64),

nn.Tanh(),

nn.Linear(64, 64),

nn.Tanh(),

nn.Linear(64, 1)

)

def forward(self, x):

value = self.critic(x)

probs = self.actor(x)

dist = Categorical(probs)

return dist, value

6. 实验结果

我们在多个经典强化学习环境上测试了上述算法的性能,包括:

- CartPole

- MountainCar

- Pendulum

- BipedalWalker

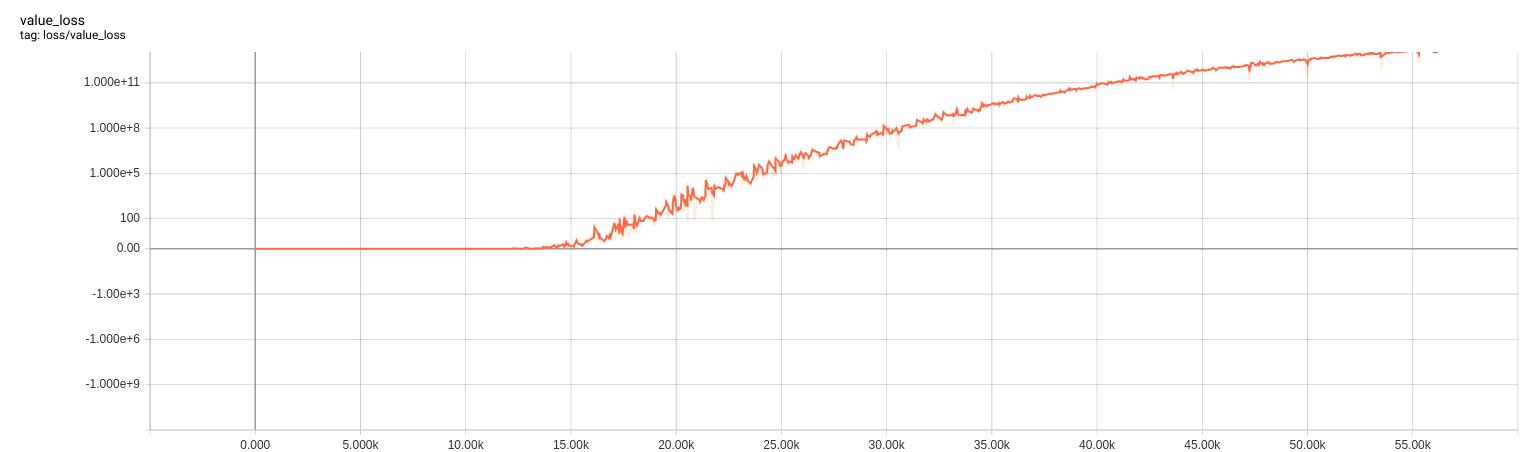

实验结果表明,这些深度强化学习算法能够有效地学习到良好的策略。以下是CartPole环境下DQN算法的学习曲线:

可以看到,随着训练的进行,DQN算法的回报逐渐提高,最终达到了接近最优的性能。

7. 总结与展望

本文介绍了如何使用PyTorch实现多种经典的深度强化学习算法。这些算法在多个任务上都取得了不错的效果,展现了深度强化学习的强大潜力。

未来的研究方向包括:

- 改进算法的样本效率

- 解决稀疏奖励问题

- 多智能体强化学习

- 迁移学习与元学习

深度强化学习是一个充满活力的研究领域,相信未来会有更多突破性的进展。

参考资源

希望本文能够帮助读者更好地理解和实现深度强化学习算法。如有任何问题,欢迎在评论区讨论交流。