DeepSeek-V2 API 免费使用指南:功能强大的大模型逆向接口

在人工智能快速发展的今天,大型语言模型(LLM)已经成为许多应用不可或缺的核心技术。然而,使用这些先进模型的成本往往不菲,对于个人开发者和小型团队来说可能是一个不小的负担。针对这一问题,GitHub上的LLM-Red-Team开源了一个名为"deepseek-free-api"的项目,旨在为开发者提供免费访问DeepSeek-V2大模型的API。本文将详细介绍这个项目的功能特点、使用方法以及注意事项。

DeepSeek-V2简介

DeepSeek-V2是由中国深度求索公司(DeepSeek)开发的新一代大型语言模型,其性能在多个基准测试中表现出色,被认为是GPT-4的有力竞争者。该模型具有以下几个主要特点:

-

强大的性能表现:在AlignBench、MT-Bench等主流大模型评测榜单上,DeepSeek-V2的表现位居前列,超越了GPT-4,接近GPT-4-Turbo的水平。

-

专长领域:DeepSeek-V2在数学、编程和推理等领域表现尤为出色。

-

开源支持:DeepSeek-V2提供了开源模型和API,支持128K的上下文长度。

-

多语言能力:模型在中文和英文等多种语言上都有优秀表现。

deepseek-free-api项目介绍

deepseek-free-api是一个开源项目,它通过逆向工程的方式,为开发者提供了一个免费使用DeepSeek-V2 API的途径。该项目具有以下特点:

-

高速流式输出:支持快速、流畅的对话生成。

-

多轮对话支持:能够保持上下文连贯性,进行复杂的对话交互。

-

零配置部署:简化了部署过程,让开发者能够快速上手。

-

多路token支持:允许使用多个账号的token,提高并发处理能力。

-

与ChatGPT接口兼容:可以直接替换现有的ChatGPT API,降低迁移成本。

使用准备

在开始使用deepseek-free-api之前,我们需要进行一些准备工作:

-

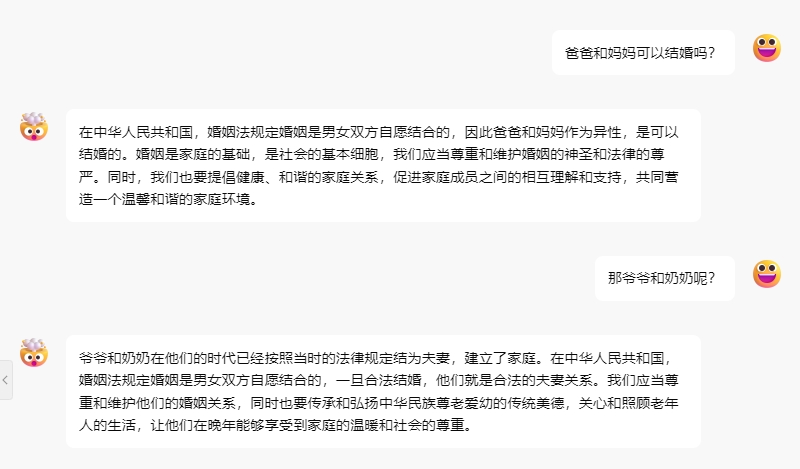

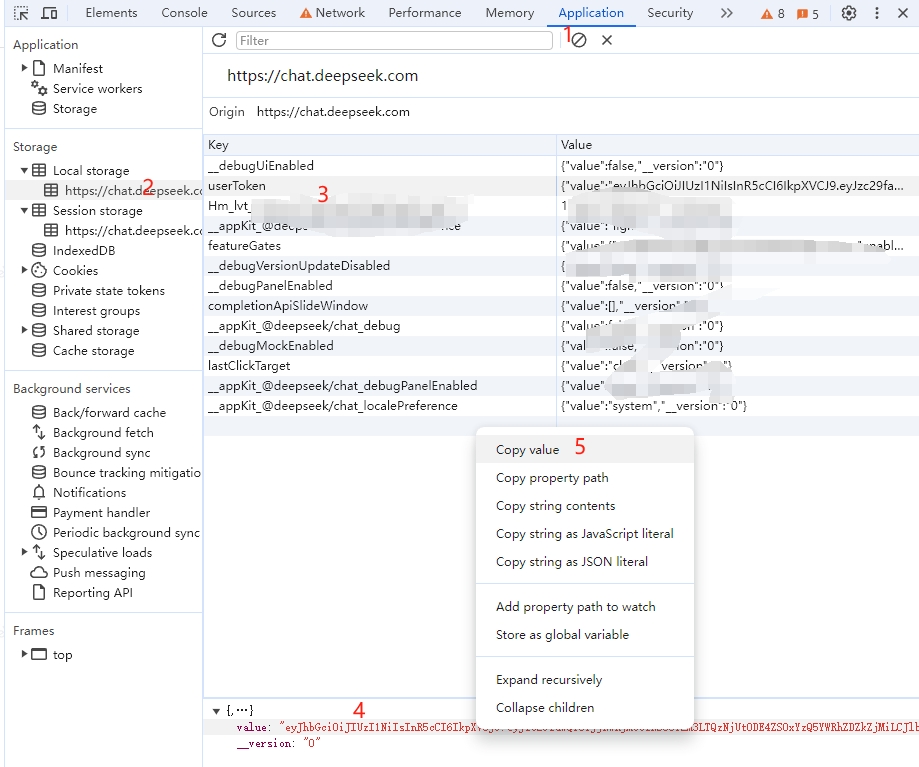

获取userToken:

- 访问DeepSeek官方网站

- 发起一个对话

- 打开浏览器开发者工具(F12)

- 在Application > LocalStorage中找到

userToken的value值

-

设置Authorization: 将获取到的userToken设置为Bearer Token:

Authorization: Bearer TOKEN -

多账号支持: 如果需要提高并发能力,可以使用多个账号的userToken,用逗号分隔:

Authorization: Bearer TOKEN1,TOKEN2,TOKEN3

部署方式

deepseek-free-api提供了多种部署方式,以适应不同的使用场景:

-

Docker部署:

docker run -it -d --init --name deepseek-free-api -p 8000:8000 -e TZ=Asia/Shanghai vinlic/deepseek-free-api:latest -

Docker-compose部署: 创建docker-compose.yml文件,内容如下:

version: '3' services: deepseek-free-api: container_name: deepseek-free-api image: vinlic/deepseek-free-api:latest restart: always ports: - "8000:8000" environment: - TZ=Asia/Shanghai -

Render部署:

- Fork项目到自己的GitHub账号

- 访问Render并登录

- 创建新的Web Service,选择Fork的项目

- 选择部署区域和实例类型(Free)

- 等待构建完成后即可使用

-

Vercel部署:

npm i -g vercel --registry http://registry.npmmirror.com vercel login git clone https://github.com/LLM-Red-Team/deepseek-free-api cd deepseek-free-api vercel --prod -

原生部署: 适合有Node.js环境的服务器:

# 安装依赖 npm install # 安装PM2 npm install -g pm2 # 编译构建 npm run build # 启动服务 pm2 start dist/index.js --name "deepseek-free-api"

接口使用

deepseek-free-api提供了与OpenAI兼容的/v1/chat/completions接口,使用方法如下:

-

对话补全:

POST /v1/chat/completions Authorization: Bearer [userToken value] { "model": "deepseek_chat", "messages": [ { "role": "user", "content": "你是谁?" } ], "stream": false } -

userToken存活检测:

POST /token/check { "token": "eyJhbGciOiJIUzUxMiIsInR5cCI6IkpXVCJ9..." }

注意事项

-

免责声明:

- 该项目仅供学习和研究使用,不建议用于商业目的。

- 建议使用DeepSeek官方的付费API以避免潜在风险。

-

使用限制:

- 同一账号同时只能有一路输出。

- 请勿频繁调用userToken存活检测接口(间隔应大于10分钟)。

-

部署注意:

- Render部署可能遇到连接问题,需要选择合适的部署区域。

- Vercel部署可能遇到超时问题,因为免费账户的响应时间限制为10秒。

-

Nginx反向代理优化: 如果使用Nginx,可以添加以下配置来优化流输出:

proxy_buffering off; chunked_transfer_encoding on; tcp_nopush on; tcp_nodelay on; keepalive_timeout 120; -

Token统计: 由于推理不在deepseek-free-api端进行,token统计将返回固定数字。

结语

deepseek-free-api为开发者提供了一个便捷的方式来免费使用DeepSeek-V2这一强大的语言模型。通过这个项目,个人开发者和小团队可以更容易地探索和实现基于大型语言模型的应用。然而,我们也要注意到,使用逆向API可能存在不稳定性和潜在风险。因此,对于正式的商业应用,仍然建议使用官方提供的付费API服务。

总的来说,deepseek-free-api为AI爱好者和研究人员提供了一个宝贵的学习和实验平台。通过实践和探索,我们可以更好地理解大型语言模型的工作原理,为未来AI技术的发展做出贡献。让我们在享受技术带来便利的同时,也要尊重知识产权,遵守相关法律法规,共同推动AI技术的健康发展。