Dify2OpenAI:打通Dify与OpenAI生态的桥梁

在人工智能快速发展的今天,各种AI平台和工具层出不穷。其中,Dify作为一个开源的AI应用开发平台,以其强大的功能和灵活性吸引了众多开发者。而OpenAI则凭借其广泛使用的API接口,成为了许多AI应用的首选。那么,如何将这两个优秀的平台结合起来,发挥各自的优势呢?Dify2OpenAI项目应运而生,为开发者们提供了一个绝佳的解决方案。

Dify2OpenAI:功能强大的转换工具

Dify2OpenAI是一个创新的开源项目,其核心目标是将Dify API转换为OpenAI API格式。这意味着用户可以在他们喜爱的OpenAI客户端中无缝地访问Dify的语言模型(LLMs)、知识库、工具和工作流。这个项目不仅仅是简单的API转换,它为AI开发者和爱好者们开启了一个充满可能性的新世界。

主要特性

Dify2OpenAI的特性丰富而实用,满足了不同用户的多样化需求:

-

API转换:将Dify API无缝转换为OpenAI API格式,实现了两个平台的完美对接。

-

支持流式和阻塞式响应:根据不同的应用场景,开发者可以选择使用流式或阻塞式响应,提高了系统的灵活性和效率。

-

多种bot类型支持:支持Dify的聊天(Chat)、完成(Completion)、代理(Agent)和工作流(Workflow)等多种bot类型的API,覆盖了绝大多数应用场景。

-

变量支持:可以灵活配置输入和输出变量,特别适用于自定义的Dify工作流bot。

-

持续对话:支持上下文相关的持续对话,提升了用户体验。

-

多种部署选项:提供了Zeabur、Vercel和本地部署等多种选择,满足不同用户的部署需求。

部署Dify2OpenAI

Dify2OpenAI提供了多种部署方式,以适应不同用户的需求和技术环境:

Zeabur部署

Zeabur是一个简单易用的云平台,适合快速部署和测试。用户只需点击"Deploy on Zeabur"按钮,即可一键部署Dify2OpenAI。

Vercel部署

Vercel作为一个流行的无服务器部署平台,也是Dify2OpenAI的一个很好选择。点击"Deploy with Vercel"按钮即可开始部署。

注意:Vercel的无服务器函数有10秒的超时限制,这可能会影响某些长时间运行的操作。

本地部署

对于希望完全控制部署环境的用户,本地部署是一个理想的选择。以下是本地部署的步骤:

-

设置环境变量: 在

.env文件中设置DIFY_API_URL=https://api.dify.ai/v1 -

安装依赖:

pnpm install -

运行项目:

pnpm start

Docker部署

对于喜欢使用容器化技术的用户,Dify2OpenAI也提供了Docker部署的选项:

-

构建镜像:

docker build -t dify2openai:latest . -

运行容器:

docker run -d -name dify2openai \ --network bridge \ -p 3000:3000 \ -e DIFY_API_URL=https://api.dify.ai/v1 \ -e BOT_TYPE=Chat \ --restart always \ dify2openai:latest

也可以使用Docker Compose来简化部署过程,具体配置可以参考项目的docker-compose.yml文件。

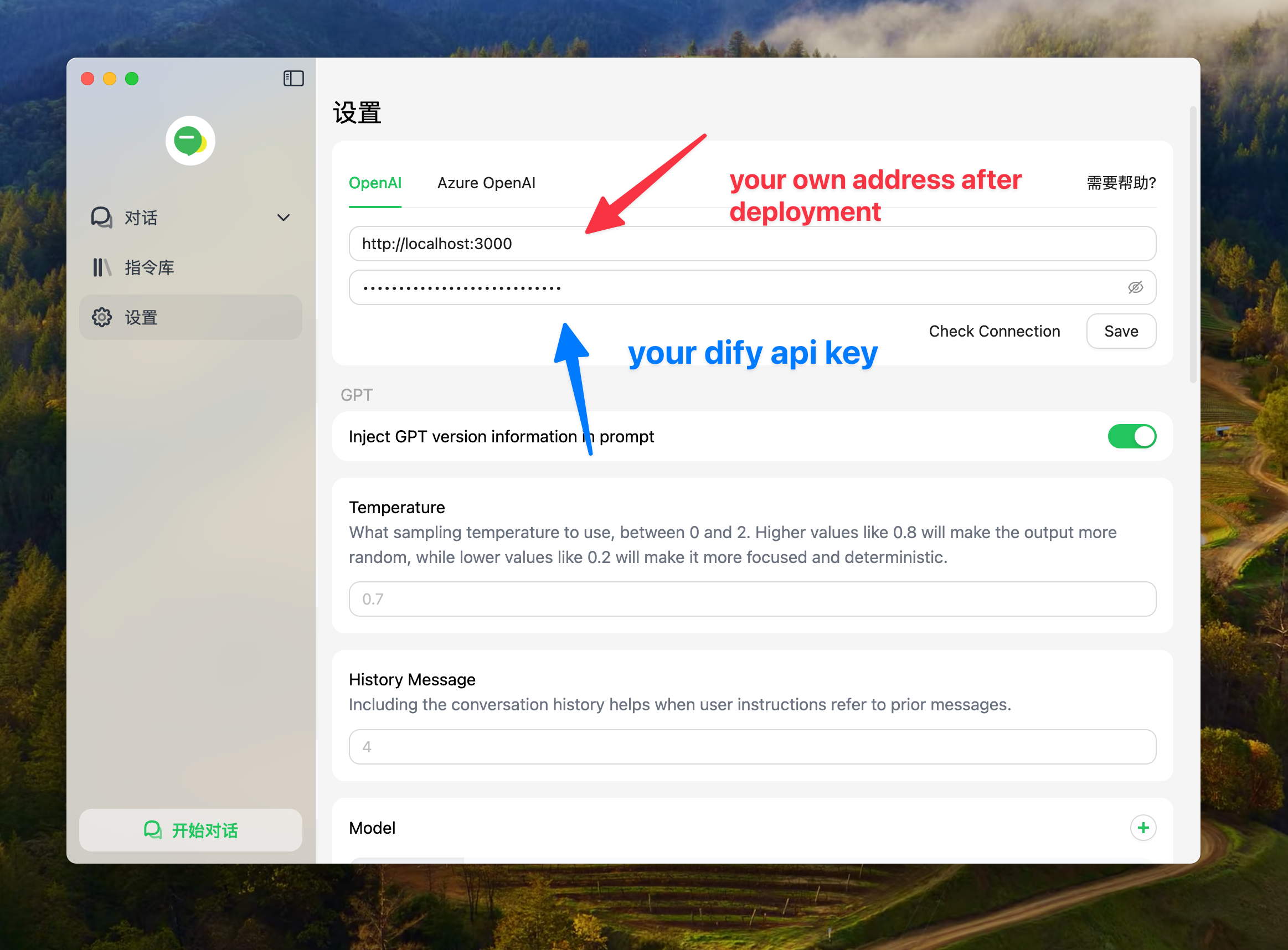

使用Dify2OpenAI

部署完成后,使用Dify2OpenAI非常简单。以下是一个使用JavaScript的示例代码:

const response = await fetch('http://localhost:3000/v1/chat/completions', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'Authorization': 'Bearer YOUR_DFIY_API_KEY',

},

body: JSON.stringify({

model: 'dify',

messages: [

{ role: 'system', content: 'You are a helpful assistant.' },

{ role: 'user', content: 'Hello, how are you?' },

],

}),

});

const data = await response.json();

console.log(data);

这段代码展示了如何向Dify2OpenAI发送一个简单的聊天请求,并获取响应。开发者可以根据自己的需求,灵活调整请求的参数和内容。

环境变量配置

Dify2OpenAI提供了一些额外的配置项,可以通过环境变量来设置:

| 环境变量 | 是否必需 | 描述 | 示例 |

|---|---|---|---|

DIFY_API_URL | 是 | 你的Dify API地址 | https://api.dify.ai/v1 |

BOT_TYPE | 是 | 你的Dify bot类型 | Chat,Completion,Workflow |

INPUT_VARIABLE | 否 | 你的Dify工作流bot的输入变量名 | query,text |

OUTPUT_VARIABLE | 否 | 你的Dify工作流bot的输出变量名 | text |

MODELS_NAME | 否 | /v1/models端点输出的模型名称 | dify |

这些环境变量的灵活配置,让Dify2OpenAI能够适应各种不同的使用场景和需求。

未来发展路线

Dify2OpenAI项目团队有着明确的发展规划,未来将会添加更多激动人心的功能:

- 图像支持

- 音频转文本

- 文本转音频

- Docker支持(已实现)

目前已经实现的功能包括工作流Bot、变量支持、持续对话、多种部署方式、流式和阻塞式响应,以及Agent和Chat bot等。这些功能的不断完善,将使Dify2OpenAI成为一个更加全面和强大的工具。

结语

Dify2OpenAI为AI开发者和爱好者们提供了一个强大而灵活的解决方案,它巧妙地将Dify的强大功能与OpenAI的广泛生态系统结合在一起。无论你是想在自己喜欢的OpenAI客户端中使用Dify的功能,还是希望将Dify集成到现有的OpenAI工作流中,Dify2OpenAI都能满足你的需求。

随着项目的不断发展和完善,我们可以期待看到更多创新的AI应用和解决方案的出现。Dify2OpenAI不仅仅是一个简单的API转换工具,它代表了AI技术融合和创新的一个重要方向,为AI的民主化和普及化贡献了自己的力量。

如果你对Dify2OpenAI感兴趣,不妨亲自尝试一下,探索它所能带来的无限可能。同时,也欢迎你为这个开源项目贡献自己的想法和代码,一起推动AI技术的发展与创新。