DistriFusion: 加速高分辨率扩散模型推理的突破性技术

在人工智能和计算机视觉领域,扩散模型因其优秀的图像生成能力而备受关注。然而,生成高分辨率图像时,扩散模型面临着巨大的计算成本和耗时问题,这严重限制了其在交互式应用中的使用。为了解决这一挑战,麻省理工学院、普林斯顿大学、Lepton AI和NVIDIA的研究团队联合开发了一种创新的技术 - DistriFusion。这项突破性的技术不仅加速了高分辨率扩散模型的推理过程,还保持了生成图像的高质量,为扩散模型的实际应用开辟了新的可能性。

DistriFusion的核心理念

DistriFusion的核心思想是利用多GPU的并行计算能力,通过分布式推理来加速扩散模型的图像生成过程。与传统的单设备推理相比,DistriFusion采用了一种巧妙的方法来分割和处理图像:

-

同步通信: 在推理的第一步,DistriFusion采用同步通信方式,确保不同GPU之间的patch能够进行充分的交互。这一步骤是至关重要的,因为它避免了简单分割可能导致的图像片段之间的明显边界问题。

-

异步通信: 在初始同步步骤之后,DistriFusion转向异步通信模式。它重复使用前一步骤的激活值,通过异步通信方式在不同GPU之间传递信息。这种方法巧妙地将通信开销隐藏在计算流程中,大大提高了整体效率。

上图展示了DistriFusion的工作原理:(a)传统的单设备扩散模型推理;(b)简单地将图像分割成两个patch并在两个GPU上处理,会在边界处产生明显的接缝;(c)DistriFusion通过在第一步使用同步通信实现patch间交互,之后通过异步通信重用前一步的激活值,有效地隐藏了通信开销。

性能突破

DistriFusion在性能方面取得了显著的突破,尤其是在处理高分辨率图像时:

-

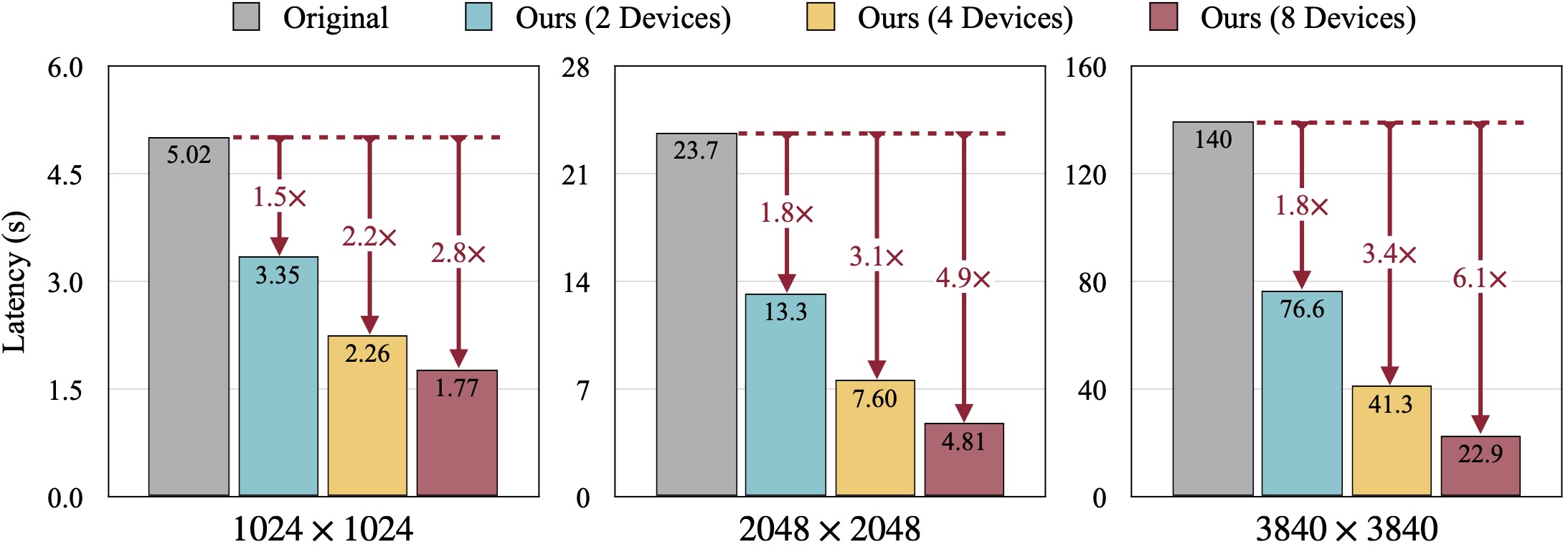

加速效果: 在使用NVIDIA A100 GPU生成3840×3840分辨率的图像时,DistriFusion实现了令人瞩目的加速效果:

- 使用2个A100 GPU时,速度提升1.8倍

- 使用4个A100 GPU时,速度提升3.4倍

- 使用8个A100 GPU时,速度提升高达6.1倍

-

质量保证: 更重要的是,DistriFusion在显著提高推理速度的同时,还保持了生成图像的高质量。通过与ground-truth图像比较的FID (Fréchet Inception Distance)指标显示,DistriFusion生成的图像质量与原始单GPU方法相当。

上图展示了DistriFusion在不同分辨率下的性能提升。随着分辨率的增加,GPU的利用率显著提高,特别是在生成3840×3840分辨率图像时,性能提升最为显著。

技术细节与实现

DistriFusion的实现涉及多个技术层面:

-

预处理:

- 使用Python3作为主要编程语言

- 需要NVIDIA GPU,CUDA版本 >= 12.0,以及相应的CuDNN

- 采用PyTorch 2.2作为深度学习框架

-

安装: DistriFusion可以通过多种方式安装,包括:

- 通过PyPI直接安装

- 从GitHub克隆仓库并本地安装

- 使用pip从GitHub安装最新版本

-

使用示例: DistriFusion提供了简洁的API,与huggingface的diffusers库兼容:

import torch from distrifuser.pipelines import DistriSDXLPipeline from distrifuser.utils import DistriConfig distri_config = DistriConfig(height=1024, width=1024, warmup_steps=4) pipeline = DistriSDXLPipeline.from_pretrained( distri_config=distri_config, pretrained_model_name_or_path="stabilityai/stable-diffusion-xl-base-1.0", variant="fp16", use_safetensors=True, ) image = pipeline( prompt="Astronaut in a jungle, cold color palette, muted colors, detailed, 8k", generator=torch.Generator(device="cuda").manual_seed(233), ).images[0] -

基准测试: DistriFusion提供了多种基准测试脚本,用于评估性能和图像质量:

- COCO数据集上的图像生成质量测试

- 不同配置下的延迟测试

- PSNR, LPIPS和FID等图像质量指标的计算

应用前景与影响

DistriFusion的出现为高分辨率图像生成领域带来了新的可能性:

-

互动应用: 通过大幅减少生成时间,DistriFusion使得在实时或近实时的互动应用中使用高分辨率扩散模型成为可能。

-

创意产业: 在广告、电影和游戏等领域,DistriFusion可以加速高质量视觉内容的创作过程。

-

科研加速: 对于需要大量高分辨率图像样本的研究项目,DistriFusion可以显著缩短实验周期。

-

资源优化: 通过更有效地利用多GPU资源,DistriFusion可以帮助研究机构和企业降低硬件投资和能源消耗。

未来展望

DistriFusion的成功为扩散模型的优化开辟了新的研究方向:

-

跨平台适配: 未来可能会看到DistriFusion在更多硬件平台上的实现,如TPU或专用AI芯片。

-

动态资源分配: 开发更智能的算法,根据输入和任务动态调整GPU资源分配。

-

与其他技术结合: 探索DistriFusion与模型压缩、量化等技术的结合,进一步提升效率。

-

应用拓展: 将DistriFusion的思想扩展到其他类型的生成模型或大规模语言模型中。

结论

DistriFusion代表了扩散模型优化的一个重要里程碑。通过巧妙的分布式并行技术,它成功地解决了高分辨率图像生成的效率问题,同时保持了图像质量。这项技术不仅推动了学术研究的前沿,还为人工智能在创意和商业领域的应用开辟了新的可能性。随着DistriFusion的进一步发展和完善,我们可以期待看到更多令人兴奋的高分辨率AI生成内容应用出现。

DistriFusion的成功也凸显了跨学科合作的重要性。来自不同机构的研究者通力合作,将并行计算、深度学习和计算机视觉等领域的专业知识融合,最终产生了这一突破性的技术。这种合作模式为未来AI研究提供了宝贵的范例。

随着AI技术不断发展,像DistriFusion这样的创新将继续推动计算机视觉和生成AI领域的进步。我们可以期待在不久的将来,更多基于DistriFusion的应用将改变我们创造和体验视觉内容的方式。