探索因果关系的前沿实验室:Causality Lab 综述

引言

在人工智能和机器学习快速发展的今天,因果关系研究正成为一个备受关注的前沿领域。Intel Labs的Causality Lab作为该领域的先锋,致力于开发新颖的因果发现算法和工具,为因果结构学习提供了强大的支持。本文将全面介绍Causality Lab的研究内容、主要算法以及应用前景,为读者展现因果研究的最新进展。

Causality Lab 概述

Causality Lab 是 Intel Labs 旗下的一个专注于因果关系研究的实验室。该实验室的主要目标是开发新型的因果发现算法,并提供一系列工具来支持因果结构学习的研究和应用。

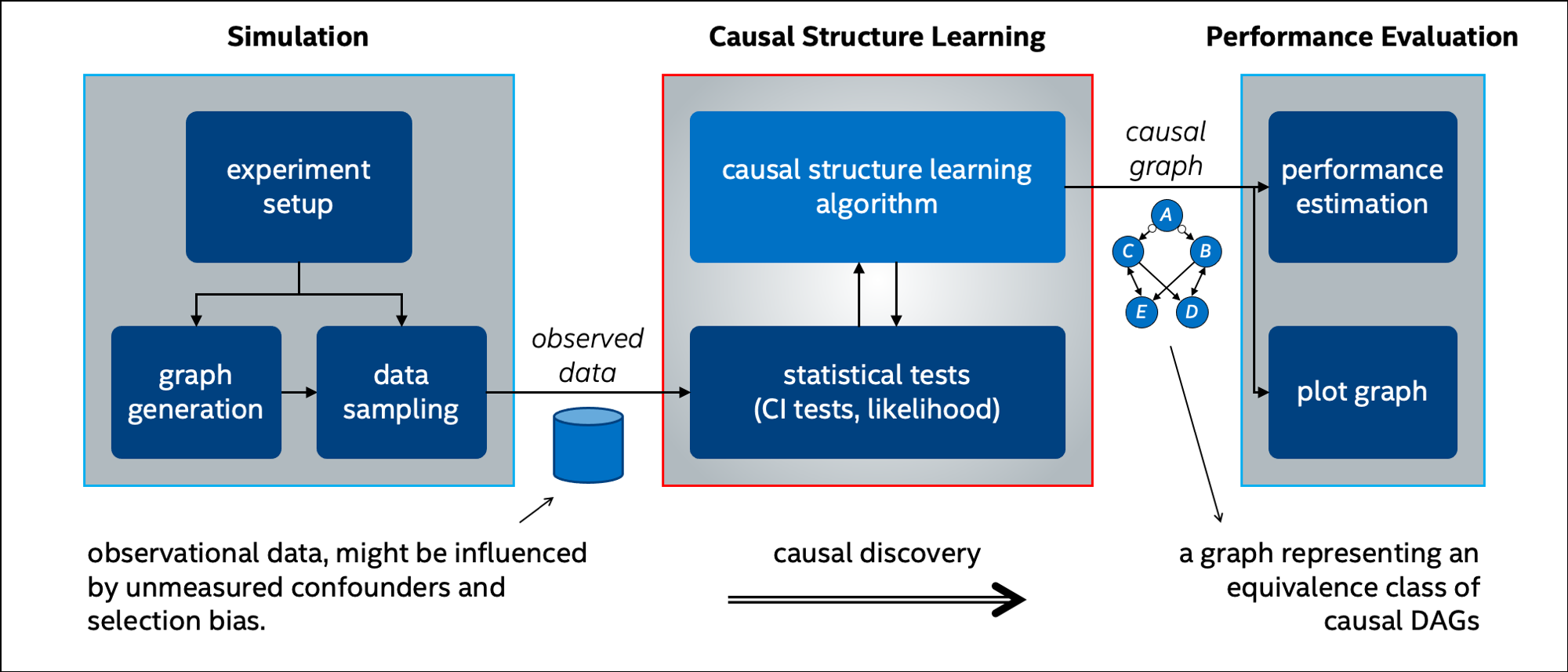

如上图所示,Causality Lab 提供了一个完整的因果研究框架,包括数据生成、算法实现、性能评估等多个模块。这个框架不仅包含了已有的经典算法,还为研究人员开发和测试新算法提供了便利。

主要研究方向

Causality Lab 的研究主要集中在以下三个方向:

- 因果充分性下的因果发现和贝叶斯网络结构学习

- 存在潜在混杂因素和选择偏差时的因果发现

- 因果推理

这些研究方向涵盖了因果关系研究的多个重要方面,从基础的因果结构学习到复杂场景下的因果发现,再到实际应用中的因果推理,形成了一个完整的研究体系。

核心算法

Causality Lab 开发并实现了多种因果发现和推理算法,主要包括:

- PC 算法:一种经典的因果发现算法

- RAI 算法:递归自主识别算法,用于 B2N 算法中的结构学习

- B-RAI 算法:基于 Bootstrap/Bayesian 的 RAI 算法,用于不确定性估计

- FCI 算法:快速因果推断算法,适用于存在潜在混杂因素的情况

- ICD 算法:迭代因果发现算法,用于处理潜在混杂因素和选择偏差

- TS-ICD 算法:时间序列数据的 ICD 算法

- CLEANN 算法:基于神经网络注意力机制的因果解释算法

这些算法覆盖了不同场景下的因果发现和推理需求,为研究人员提供了丰富的工具选择。

工具与支持

除了核心算法,Causality Lab 还提供了一系列支持工具和功能:

- 模拟工具:包括随机 DAG 采样和观测数据采样

- 图形模型处理:支持 DAG、PDAG/CPDAG、UG 和 PAG/MAG 等多种图形模型

- 统计测试:实现了条件独立性测试等统计方法

- 性能评估:提供了结构准确性、计算成本等多个维度的评估指标

- 可视化工具:支持 DAG 和祖先图的绘制

这些工具和功能大大降低了因果研究的门槛,使得研究人员可以更加专注于算法本身的设计和改进。

应用案例

Causality Lab 的研究成果在多个领域都有潜在的应用价值。例如:

- 医疗健康:通过因果发现帮助识别疾病的潜在原因和风险因素

- 金融分析:探索经济指标间的因果关系,辅助决策制定

- 推荐系统:利用因果推理提高推荐的准确性和可解释性

- 自动驾驶:分析交通事故的因果链,改进安全系统

上图展示了 ICD 算法在因果发现中的应用示例,直观地呈现了算法的工作过程。

最新进展

Causality Lab 一直保持着对最新研究趋势的关注。2023 年 12 月,该实验室在 NeurIPS 2023 会议上发布了 CLEANN 算法。这一算法能够为预训练的 Transformer 神经网络的输出生成因果解释,标志着因果研究在深度学习领域的最新突破。

使用指南

对于有兴趣使用 Causality Lab 的研究人员,该实验室提供了详细的安装和使用说明:

- 环境要求:Ubuntu 18.04 LTS 或 macOS Catalina,Python 3.5 及以上版本

- 安装步骤:

sudo -E pip3 install virtualenv virtualenv -p python3 causal_env . causal_env/bin/activate git clone https://github.com/IntelLabs/causality-lab.git cd causality-lab pip install -r requirements.txt - 使用示例:

par_corr_test = CondIndepParCorr(dataset, threshold=0.01) icd = LearnStructICD(nodes_set, par_corr_test) icd.learn_structure()

这些指南确保了研究人员能够快速上手并开始自己的因果研究。

未来展望

随着人工智能和机器学习技术的不断发展,因果关系研究将在更多领域发挥重要作用。Causality Lab 作为该领域的重要力量,未来可能会在以下方面继续深化研究:

- 大规模数据的因果发现:开发能够处理海量、高维数据的算法

- 动态系统的因果分析:研究时变因果关系和反馈循环

- 因果推理与机器学习的深度融合:探索将因果推理整合到深度学习模型中的方法

- 可解释 AI:利用因果关系提高 AI 模型的可解释性和可信度

结语

Causality Lab 为因果关系研究提供了一个全面而强大的平台。通过持续开发新算法、提供实用工具和支持跨领域应用,该实验室正在推动因果研究的前沿发展。随着更多研究人员加入这一领域,我们有理由相信,因果关系研究将为人工智能的进步带来新的突破,为解决复杂的现实问题提供更有力的支持。

参考文献

- Rohekar, R., Gurwicz, Y., & Nisimov, S. (2023). Causal Interpretation of Self-Attention in Pre-Trained Transformers. Advances in Neural Information Processing Systems (NeurIPS) 36.

- Rohekar, R. Y., Nisimov, S., Gurwicz, Y., & Novik, G. (2023). From Temporal to Contemporaneous Iterative Causal Discovery in the Presence of Latent Confounders. International Conference on Machine Learning (ICML).

- Rohekar, R. Y., Nisimov, S., Gurwicz, Y., & Novik, G. (2021). Iterative Causal Discovery in the Possible Presence of Latent Confounders and Selection Bias. Advances in Neural Information Processing Systems (NeurIPS) 34.

- Spirtes, P., Glymour, C. N., Scheines, R., & Heckerman, D. (2000). Causation, prediction, and search. MIT press.

通过本文的介绍,读者可以全面了解 Causality Lab 的研究内容、主要成果以及未来发展方向。无论是对因果关系研究感兴趣的学者,还是希望将因果分析应用到实际问题中的从业者,都能从中获得有价值的信息和启发。

编辑推荐精选

讯飞智文

一键生成PPT和Word,让学习生活更轻松

讯飞智文是一个利用 AI 技术的项目,能够帮助用户生成 PPT 以及各类文档。无论是商业领域的市场分析报告、年度目标制定,还是学生群体的职业生涯规划、实习避坑指南,亦或是活动策划、旅游攻略等内容,它都能提供支持,帮助用户精准表达,轻松呈现各种信息。

讯飞星火

深度推理能力全新升级,全面对标OpenAI o1

科大讯飞的星火大模型,支持语言理解、知识问答和文本创作等多功能,适用于多种文件和业务场景,提升办公和日常生活的效率。讯飞星火是一个提供丰富智能服务的平台,涵盖科技资讯、图像创作、写作辅助、编程解答、科研文献解读等功能,能为不同需求的用户提供便捷高效的帮助,助力用户轻松获取信息、解决问题,满足多样化使用场景。

Spark-TTS

一种基于大语言模型的高效单流解耦语音令牌文本到语音合成模型

Spark-TTS 是一个基于 PyTorch 的开源文本到语音合成项目,由多个知名机构联合参与。该项目提供了高效的 LLM(大语言模型)驱动的语音合成方案,支持语音克隆和语音创建功能,可通过命令行界面(CLI)和 Web UI 两种方式使用。用户可以根据需求调整语音的性别、音高、速度等参数,生成高质量的语音。该项目适用于多种场景,如有声读物制作、智能语音助手开发等。

Trae

字节跳动发布的AI编程神器IDE

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

咔片PPT

AI助力,做PPT更简单!

咔片是一款轻量化在线演示设计工具,借助 AI 技术,实现从内容生成到智能设计的一站式 PPT 制作服务。支持多种文档格式导入生成 PPT,提供海量模板、智能美化、素材替换等功能,适用于销售、教师、学生等各类人群,能高效制作出高品质 PPT,满足不同场景演示需求。

讯飞绘文

选题、配图、成文,一站式创作,让内容运营更高效

讯飞绘文,一个AI集成平台,支持写作、选题、配图、排版和发布。高效生成适用于各类媒体的定制内容,加速品牌传播,提升内容营销效果。

材料星

专业的AI公文写作平台,公文写作神器

AI 材料星,专业的 AI 公文写作辅助平台,为体制内工作人员提供高效的公文写作解决方案。拥有海量公文文库、9 大核心 AI 功能,支持 30 + 文稿类型生成,助力快速完成领导讲话、工作总结、述职报告等材料,提升办公效率,是体制打工人的得力写作神器。

openai-agents-python

OpenAI Agents SDK,助力开发者便捷使用 OpenAI 相关功能。

openai-agents-python 是 OpenAI 推出的一款强大 Python SDK,它为开发者提供了与 OpenAI 模型交互的高效工具,支持工具调用、结果处理、追踪等功能,涵盖多种应用场景,如研究助手、财务研究等,能显著提升开发效率,让开发者更轻松地利用 OpenAI 的技术优势。

Hunyuan3D-2

高分辨率纹理 3D 资产生成

Hunyuan3D-2 是腾讯开发的用于 3D 资产生成的强大工具,支持从文本描述、单张图片或多视角图片生成 3D 模型,具备快速形状生成能力,可生成带纹理的高质量 3D 模型,适用于多个领域,为 3D 创作提供了高效解决方案。

3FS

一个具备存储、管理和客户端操作等多种功能的分布式文件系统相关项目。

3FS 是一个功能强大的分布式文件系统项目,涵盖了存储引擎、元数据管理、客户端工具等多个模块。它支持多种文件操作,如创建文件和目录、设置布局等,同时具备高效的事件循环、节点选择和协程池管理等特性。适用于需要大规模数据存储和管理的场景,能够提高系统的性能和可靠性,是分布式存储领域的优质解决方案。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众��号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号