引言

在人工智能快速发展的今天,智能代理系统(Agentic System)作为构建通用人工智能的重要组成部分,正受到越来越多的关注。近期,Meta推出了Llama-agentic-system框架,为开发者提供了一套强大的工具,用于构建具备多步推理、工具使用和安全保护能力的智能代理应用。本文将深入探讨Llama-agentic-system的核心特性、组件架构以及应用场景,帮助读者全面了解这一创新框架。

Llama-agentic-system概述

Llama-agentic-system是基于Llama Stack构建的智能代理系统框架。它允许开发者创建能够执行以下任务的应用:

- 分解复杂任务并进行多步推理

- 使用各种工具执行操作

- 内置工具:模型具备搜索、代码解释器等内置工具的知识

- 零样本学习:模型可以学习调用先前未见过的、上下文中定义的工具

- 利用Llama Guard等模型提供系统级安全保护

值得注意的是,Llama Stack API仍在不断演进中,可能会发生变化。开发者可以自由构建和实验,但目前还不建议过度依赖其稳定性。

核心组件

一个完整的智能代理应用通常需要以下几个关键组件:

- 能够在底层Llama系列模型上运行推理

- 能够使用Llama Guard系列模型进行安全检查

- 能够执行工具,包括代码执行环境,并使用模型的多步推理过程进行循环

Llama Stack Distribution将这些组件整合在一起,为开发者提供了一站式解决方案。

安装与配置

要开始使用Llama Stack Distribution,需要完成以下步骤:

- 安装先决条件

- 设置提供核心

llamaCLI的工具链 - 下载模型

- 构建Llama Stack Distribution镜像

- 启动Llama Stack服务器

安装先决条件

首先,建议创建一个独立的conda Python环境:

ENV=app_env

conda create -n $ENV python=3.10

cd <path-to-llama-stack-apps-repo>

conda activate $ENV

# 安装依赖

pip install -r requirements.txt

此外,还需要安装bubblewrap用于代码执行环境的隔离。如果计划使用Ollama进行推理,还需要按照说明安装Ollama服务器。

下载模型

可以从Meta或Hugging Face下载所需的模型检查点。以下是从Meta下载的示例命令:

# 下载8B模型(单GPU可运行)

llama download --source meta --model-id Meta-Llama3.1-8B-Instruct --meta-url META_URL

# 下载70B模型(需要8个GPU)

llama download --source meta --model-id Meta-Llama3.1-70B-Instruct --meta-url META_URL

# 下载安全模型

llama download --source meta --model-id Prompt-Guard-86M --meta-url META_URL

llama download --source meta --model-id Llama-Guard-3-8B --meta-url META_URL

安装和配置分发版

Llama Stack提供了多种分发版,如local、remote、local-ollama等。以下是安装和配置local-ollama分发版的步骤:

- 启动Ollama服务器

- 安装Llama Stack分发版:

llama stack build local-ollama --name 8b-instruct - 配置分发版:

llama stack configure local-ollama --name 8b-instruct

启动Stack服务器

使用以下命令启动Llama Stack服务器:

llama stack run local-ollama --name 8b-instruct --port 5000

服务器启动后,你将看到它支持的API列表。

构建智能代理应用

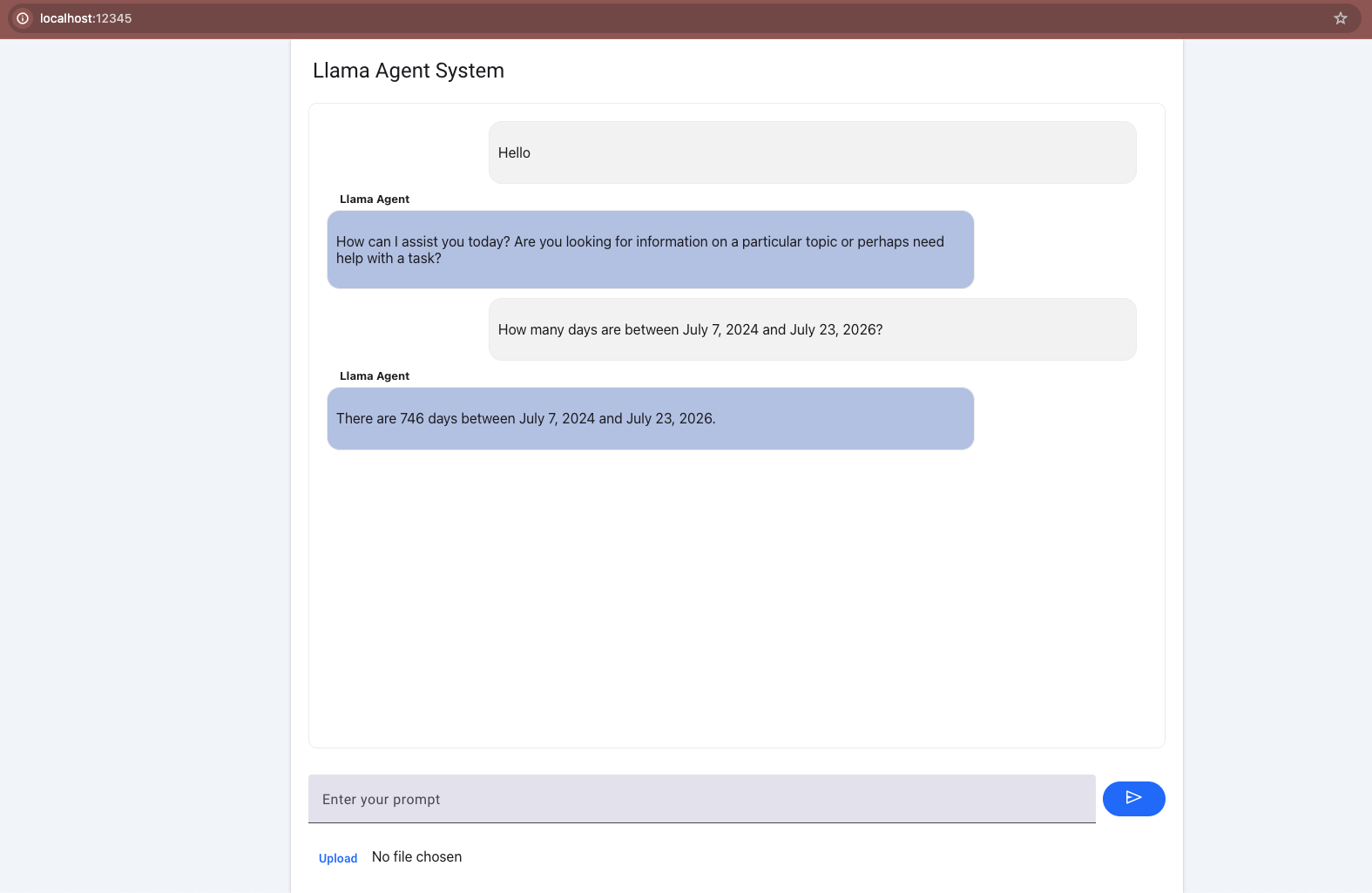

现在Stack服务器已经设置完成,接下来就可以使用AgenticSystem API构建智能代理应用了。Llama-agentic-system提供了示例脚本、notebooks和UI聊天界面(使用Mesop构建),帮助开发者快速入门。

添加工具API密钥

Llama Stack支持多种工具,如Brave搜索和Wolfram数学运算。在安装Llama Stack分发版时,llama stack build脚本会询问Agentic System的API密钥配置。

启动应用并与服务器交互

使用以下命令启动一个本地应用并与之交互:

PYTHONPATH=. mesop app/chat.py

这将启动一个Mesop应用,你可以在localhost:32123访问聊天界面。

除了基本聊天应用,还可以尝试其他变体:

PYTHONPATH=. mesop app/chat_with_custom_tools.py: 展示如何集成自定义工具PYTHONPATH=. mesop app/chat_moderation_with_llama_guard.py: 展示如何将应用修改为安全聊天监控器

应用场景与潜力

Llama-agentic-system为开发者提供了构建复杂智能代理系统的强大工具。以下是一些潜在的应用场景:

- 智能客服: 能够理解复杂查询,分解任务,并利用多种工具提供全面解答。

- 个人助理: 帮助用户规划行程、管理日程、回答问题等。

- 代码助手: 理解编程需求,分解任务,并生成、解释和优化代码。

- 教育辅助: 根据学生的问题提供个性化解答,分解复杂概念。

- 研究助手: 协助研究人员收集信息、分析数据、生成报告等。

未来展望

随着Llama-agentic-system的不断发展,我们可以期待以下方面的进展:

- 更强大的推理能力: 模型将能够处理更复杂的任务和更长的上下文。

- 更丰富的工具集成: 支持更多类型的外部工具和API。

- 增强的安全机制: 更全面的安全检查和偏见控制。

- improved多模态能力: 支持图像、音频等多模态输入和输出。

- 更好的可解释性: 提供更清晰的决策过程解释。

结语

Llama-agentic-system为构建智能代理应用开辟了新的可能性。通过提供一个统一的框架,它简化了复杂AI系统的开发过程。尽管该框架仍在不断发展中,但已经展现出巨大的潜力。随着更多开发者参与其中,我们有理由相信,基于Llama-agentic-system的创新应用将不断涌现,推动AI技术向着更智能、更实用的方向发展。

对于有志于探索AI前沿的开发者来说,Llama-agentic-system无疑是一个值得深入研究的框架。通过实践和创新,我们可以共同推动智能代理技术的进步,为人工智能的未来贡献力量。