nanoGPT:小而美的GPT训练工具

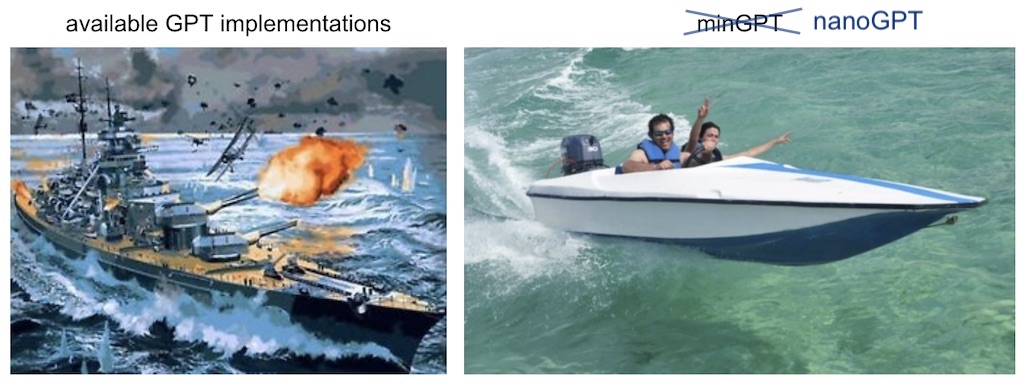

nanoGPT是由Andrej Karpathy开发的一个用于训练和微调中等规模GPT模型的简单而快速的代码库。它是minGPT的重写版本,旨在提供更高效的训练过程。尽管仍在积极开发中,但nanoGPT已经展现出了令人印象深刻的性能。

nanoGPT的主要特点

-

简单性: nanoGPT的核心代码非常简洁。

train.py文件只有约300行的训练循环代码,而model.py文件也只有约300行的GPT模型定义。这种简洁性使得代码易于理解和修改。 -

高效性: 尽管代码简单,但nanoGPT的性能却不容小觑。它可以在单个8XA100 40GB节点上,在约4天内完成对OpenWebText数据集的GPT-2(124M参数)模型的训练。

-

灵活性: 由于代码简单,用户可以轻松地根据自己的需求进行修改,训练全新的模型,或者微调预训练的检查点。

-

可扩展性: nanoGPT支持使用更大规模的预训练模型作为起点,如OpenAI的GPT-2 1.3B模型。

安装和依赖

要使用nanoGPT,您需要安装以下依赖项:

pip install torch numpy transformers datasets tiktoken wandb tqdm

主要依赖包括:

- PyTorch: 深度学习框架

- NumPy: 科学计算库

- Transformers: 用于加载GPT-2检查点

- Datasets: 用于下载和预处理OpenWebText数据集

- Tiktoken: OpenAI的快速BPE编码工具

- Wandb: 用于可选的日志记录

- tqdm: 用于显示进度条

快速入门

对于初学者来说,最快的入门方法是在莎士比亚作品集上训练一个字符级的GPT模型。步骤如下:

-

下载数据集并准备:

python data/shakespeare_char/prepare.py -

训练模型:

python train.py config/train_shakespeare_char.py -

生成样本:

python sample.py --out_dir=out-shakespeare-char

在一个A100 GPU上,这个训练过程只需要约3分钟,就可以得到一个具有256字符上下文大小、384特征通道、6层Transformer(每层6个头)的GPT模型。

在不同硬件上的训练

nanoGPT的灵活性使其能够适应不同的硬件环境:

-

在GPU上: 使用默认配置即可快速训练。

-

在CPU或低配置设备上: 可以通过调整参数来降低计算需求,例如:

python train.py config/train_shakespeare_char.py --device=cpu --compile=False --eval_iters=20 --log_interval=1 --block_size=64 --batch_size=12 --n_layer=4 --n_head=4 --n_embd=128 --max_iters=2000 --lr_decay_iters=2000 --dropout=0.0 -

在Apple Silicon Macbooks上: 使用

--device=mps参数可以显著加速训练(2-3倍)并允许使用更大的网络。

复现GPT-2结果

对于更专业的深度学习研究者,nanoGPT还提供了复现GPT-2结果的功能:

-

准备数据集:

python data/openwebtext/prepare.py -

开始训练:

torchrun --standalone --nproc_per_node=8 train.py config/train_gpt2.py

这个过程在使用PyTorch分布式数据并行(DDP)的情况下,大约需要4天时间,最终损失可以达到约2.85。

微调和采样

nanoGPT还支持对预训练模型进行微调:

-

准备新数据集:

cd data/shakespeare python prepare.py -

开始微调:

python train.py config/finetune_shakespeare.py

微调后,可以使用sample.py脚本从模型中生成文本样本。

效率说明

nanoGPT默认使用PyTorch 2.0,这可以显著提高训练效率。例如,它可以将每次迭代的时间从约250ms减少到135ms。

未来发展方向

nanoGPT的开发团队计划在未来添加更多功能,包括:

- 引入FSDP(全量分片数据并行)替代DDP

- 评估标准测试集上的零样本困惑度

- 优化微调脚本的超参数

- 在训练过程中实现线性批量大小增加

- 集成其他嵌入方法(如rotary, alibi)

- 改进检查点中优化器缓冲区和模型参数的分离

- 添加更多关于网络健康状况的日志记录

- 探索更好的初始化方法

总结

nanoGPT为研究人员和开发者提供了一个简单而强大的工具,用于训练和微调中等规模的GPT模型。它的简洁性和灵活性使其成为学习和实验GPT模型的理想选择。无论您是初学者还是经验丰富的NLP专家,nanoGPT都能为您的项目提供有价值的支持。

随着自然语言处理技术的不断发展,像nanoGPT这样的工具将在推动GPT模型的创新和应用方面发挥重要作用。我们期待看到更多基于nanoGPT的有趣应用和研究成果。

🔗 更多信息和讨论,欢迎访问nanoGPT GitHub仓库或加入Discord上的#nanoGPT频道。

最后,感谢Lambda labs为nanoGPT实验提供GPU支持。他们是Andrej Karpathy最喜欢的云GPU提供商,为nanoGPT的开发做出了重要贡献。