Sensei:开源AI问答引擎的新尝试

在人工智能快速发展的今天,越来越多的开发者和企业开始关注并探索AI技术在各个领域的应用。其中,AI驱动的问答系统因其强大的知识获取和信息检索能力,成为了一个备受瞩目的研究方向。本文将为大家介绍一个名为Sensei的开源AI问答引擎项目,探讨其技术实现、功能特性以及开发过程中的经验与挑战。

Sensei项目概览

Sensei是一个由开发者jjleng发起的开源项目,旨在构建一个类似Perplexity AI的智能问答系统。该项目利用多个开源大语言模型(LLMs)和搜索引擎,为用户提供准确、全面的问题解答服务。

项目地址: https://github.com/jjleng/sensei

在线演示: https://www.heysensei.app

核心特性与技术栈

Sensei集成了多项先进技术,构建了一个功能完善的AI问答平台:

-

前端技术:

- Next.js: React框架,用于构建用户界面

- Tailwind CSS: 实用的CSS框架,提供灵活的样式定制

-

后端技术:

- FastAPI: 高性能Python Web框架

- OpenAI client: 用于与OpenAI API交互

-

大语言模型(LLMs):

- Command-R

- Qwen-2-72b-instruct

- WizardLM-2 8x22B

- Claude Haiku

- GPT-3.5-turbo

-

搜索引擎:

- SearxNG

- Bing

-

内存存储:

- Redis: 用于缓存和会话管理

-

部署方案:

- AWS: 云服务平台

- Paka: 自定义部署工具

界面展示

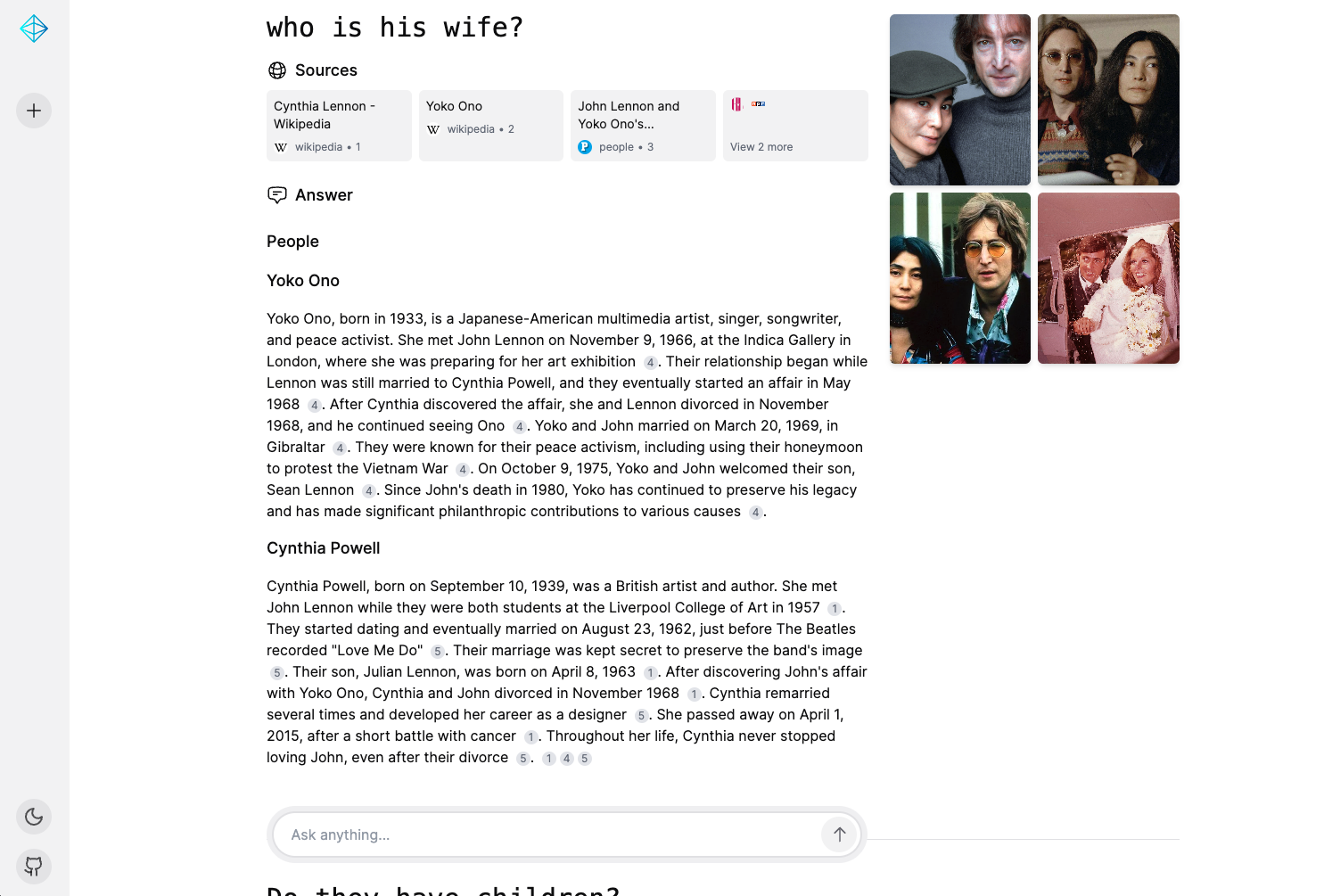

Sensei提供了简洁直观的用户界面,支持浅色和深色两种主题模式:

图1: Sensei浅色模式界面

图2: Sensei深色模式界面

本地部署指南

如果您想在本地运行Sensei,可以按照以下步骤操作:

-

准备后端环境:

cd sensei_root_folder/backend/ mv .env.development.example .env.development编辑

.env.development文件,根据需要调整配置。默认配置假设您通过Ollama运行模型。请确保您的GPU性能足以运行Command-R/Qwen-2-72b-instruct/WizardLM-2 8x22B等大型模型。 -

前端无需额外配置。

-

启动应用:

cd sensei_root_folder/ docker compose up -

打开浏览器访问 http://localhost:3000

云端部署方案

Sensei项目使用自定义的Paka工具在AWS上部署。由于模型需要GPU实例运行,请确保您的AWS账户有足够的GPU配额。

部署步骤如下:

-

安装Paka:

pip install paka -

在AWS上配置集群:

make provision-prod -

部署后端:

make deploy-backend -

部署前端:

make deploy-frontend -

获取前端URL:

paka function list -

在浏览器中打开获得的URL即可访问。

使用开源LLMs的经验与见解

开发Sensei项目的过程中,团队积累了丰富的开源大语言模型使用经验。以下是一些关键洞察:

-

模型选择:

- Command-R、Qwen-2-72b-instruct和WizardLM-2 8x22B等开源模型在某些任务上表现出色,可以作为商业模型的替代方案。

- 不同模型在不同类型的问题上有各自的优势,需要进行充分测试和比较。

-

计算资源:

- 运行大型LLMs需要强大的GPU支持,这对硬件要求和成本控制提出了挑战。

- 使用云服务可以灵活调配资源,但需要注意成本管理。

-

模型微调:

- 针对特定领域或任务对模型进行微调可以显著提升性能。

- 微调过程需要大量高质量数据和计算资源,是一项复杂的工作。

-

集成与优化:

- 将多个模型和搜索引擎结合使用可以互补优势,提供更全面的答案。

- 需要设计合理的调度策略,平衡性能和资源消耗。

-

隐私与合规:

- 使用开源模型可以更好地控制数据隐私,避免敏感信息泄露。

- 但仍需注意模型输出的合规性,防止生成不当或有害内容。

-

社区支持:

- 开源LLMs拥有活跃的开发者社区,可以获得持续的更新和支持。

- 参与社区讨论和贡献也是提升项目质量的好方法。

更多详细讨论可以参考Reddit上的相关帖子。

未来发展方向

Sensei项目仍在积极开发中,未来计划在以下几个方面进行改进和扩展:

-

模型优化:持续跟进和集成最新的开源LLMs,提升问答质量。

-

多语言支持:扩展对更多语言的支持,使Sensei成为一个真正的多语言AI助手。

-

领域适配:针对特定领域(如医疗、法律、教育等)进行模型微调和知识库构建。

-

用户体验:优化界面交互,提供更多个性化设置和功能。

-

性能提升:优化后端架构,提高响应速度和并发处理能力。

-

社区生态:鼓励更多开发者参与,共同完善和扩展Sensei的功能。

结语

Sensei项目展示了开源AI技术在问答系统领域的巨大潜力。通过整合多个开源LLMs和先进的Web技术,Sensei为用户提供了一个功能强大、灵活可定制的AI问答平台。尽管在计算资源、模型性能和系统优化等方面仍面临挑战,但Sensei的开发经验为今后类似项目的实施提供了宝贵参考。

随着AI技术的不断进步和开源社区的持续贡献,我们有理由相信,像Sensei这样的开源AI项目将在推动人工智能技术普及和创新方面发挥越来越重要的作用。无论您是AI爱好者、研究人员还是企业开发者,都可以从Sensei项目中获得启发,并为这个充满活力的领域贡献自己的力量。

让我们共同期待Sensei及其他开源AI项目的蓬勃发展,为构建更智能、更开放的未来贡献力量! 🚀🤖💡