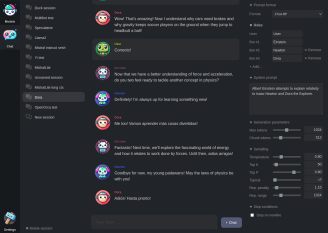

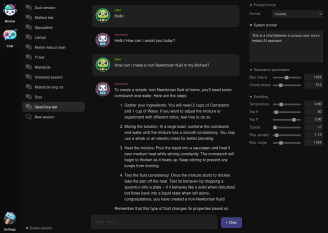

ExUI: 为ExLlamaV2打造的轻量级Web界面

在人工智能和大语言模型快速发展的今天,如何便捷地使用这些强大的工具成为了许多AI爱好者和开发者关注的焦点。ExUI应运而生,它是一个为ExLlamaV2量身定制的简单、轻量级的基于浏览器的用户界面,旨在为用户提供流畅的本地推理体验。本文将深入探讨ExUI的特性、使用方法以及它为AI社区带来的价值。

ExUI的核心特性

ExUI虽然轻量,但功能丰富,满足了用户对大语言模型交互的多样需求:

-

友好的响应式界面:ExUI采用简洁明了的设计,确保用户在各种设备上都能获得良好的使用体验。无论是在桌面电脑还是移动设备上,界面都能自适应调整,保证操作的流畅性。

-

持久会话:这一功能让用户可以保存对话历史,方便随时回顾和继续之前的交互。对于需要长期进行的项目或研究,这一特性尤为重要。

-

多种指令格式支持:ExUI灵活支持多种指令格式,适应不同用户的使用习惯和需求。这种灵活性使得ExUI能够满足从新手到专业人士的各类用户群体。

-

推测性解码:这一先进特性能够提高模型响应的速度,为用户带来更加流畅的对话体验。

-

广泛的模型支持:ExUI不仅支持EXL2模型,还兼容GPTQ和FP16模型,为用户提供了丰富的选择空间。

-

记事本模式:这一独特功能让ExUI不仅仅是一个对话工具,还可以作为创意写作和笔记工具使用,大大拓展了其应用场景。

本地运行ExUI

对于想要在本地环境中运行ExUI的用户,过程相当简单直接:

- 首先,克隆ExUI的GitHub仓库并安装所需依赖:

git clone https://github.com/turboderp/exui

cd exui

pip install -r requirements.txt

- 然后,使用包含的server.py文件启动Web服务器:

python server.py

执行这些步骤后,您的浏览器应该会自动打开默认的IP和端口。值得注意的是,ExUI的配置和会话默认存储在~/exui目录下,方便用户管理和备份。

为了获得最佳性能,建议安装ExLlamaV2的预构建wheel包,这些可以在ExLlamaV2的发布页面找到。此外,安装最新版本的Flash Attention也是推荐的做法,它能够显著提升模型的推理速度。

在Google Colab上运行ExUI

对于那些可能没有强大的本地硬件,或者想要快速尝试ExUI的用户,项目还提供了在Google Colab上运行的选项。这为用户提供了一个便捷的方式来体验ExUI的功能,而无需进行复杂的本地设置。感兴�ise的用户可以在项目文档中找到详细的Colab笔记本示例。

深入安装指南

对于那些希望对ExUI进行更深入定制或在特定环境中部署的用户,项目提供了更为详细的安装说明。这些指南涵盖了各种可能的使用场景和配置选项,确保用户能够根据自己的需求优化ExUI的性能。详细的安装指南可以在项目的手动安装文档中找到。

ExUI的未来展望

ExUI的开发团队表示,这只是开始。他们承诺将继续改进和扩展ExUI的功能,以满足用户不断变化的需求。虽然具体的路线图尚未公布,但可以预期未来的更新可能包括更多的模型支持、增强的用户界面、更强大的定制选项,以及与其他AI工具的集成。

结语

ExUI为ExLlamaV2提供了一个简洁而功能强大的Web界面,让更多用户能够轻松地探索和利用大语言模型的能力。无论是AI研究人员、开发者,还是对AI技术感兴趣的普通用户,都能从ExUI中受益。它不仅简化了与复杂AI模型的交互过程,还为用户提供了一个灵活、可定制的平台,以满足各种应用场景的需求。

随着AI技术的不断发展,像ExUI这样的工具将在推动AI民主化和普及方面发挥重要作用。它为用户提供了一个窗口,让他们能够直观地了解和使用最新的AI技术,而无需深入了解底层的复杂性。

对于那些希望开始探索ExUI的用户,项目的GitHub页面提供了全面的文档和资源。无论您是想要在本地运行ExUI,还是在云平台上尝试,亦或是对其进行定制开发,都能找到相应的指南和支持。

随着ExUI的不断发展和社区的贡献,我们可以期待看到更多创新功能和应用场景的出现。这个项目不仅仅是一个工具,更是AI技术与日常应用之间的桥梁,为AI的未来发展铺平了道路。