FasterAI:让神经网络更小更快的利器

在深度学习日益普及的今天,如何让庞大的神经网络模型变得更小更快,以便部署到资源受限的设备上,成为了一个重要的研究方向。FasterAI正是为解决这一问题而诞生的开源库,它提供了一系列强大而灵活的神经网络压缩工具,让研究人员和工程师可以轻松地对模型进行瘦身和加速。

FasterAI的核心特性

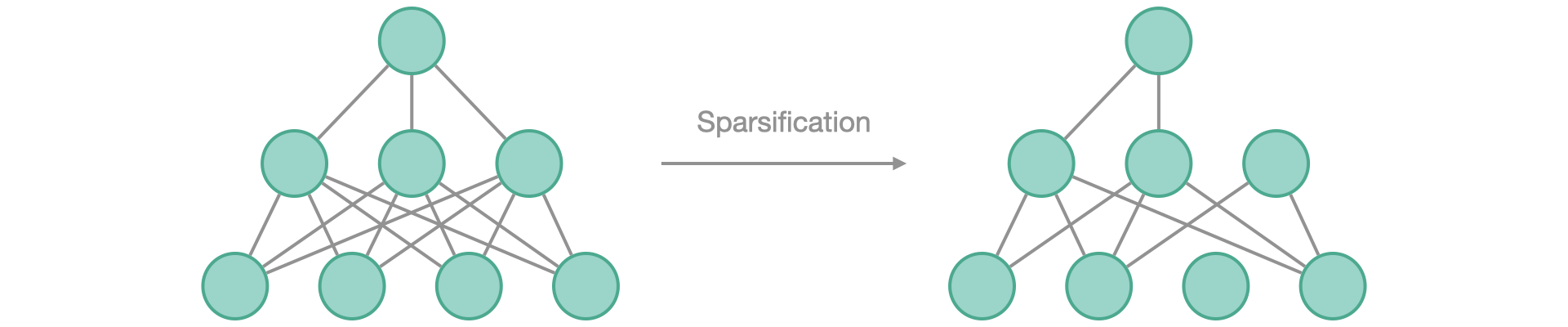

FasterAI的核心功能是网络稀疏化,它由四个主要模块构成:

- 粒度(Granularity):可以在权重、向量、卷积核等不同粒度上进行操作

- 上下文(Context):支持局部剪枝和全局剪枝

- 标准(Criteria):提供多种选择权重的标准,如幅度、移动量等

- 调度(Schedule):灵活的剪枝调度,如一次性、迭代式、渐进式等

这四个模块高度可定制,用户可以根据需求进行组合和扩展,创造出适合自己任务的压缩方案。

除了稀疏化之外,FasterAI还提供了以下重要功能:

- 剪枝:移除网络中的无用节点

- 正则化:通过正则化训练出稀疏连接的网络

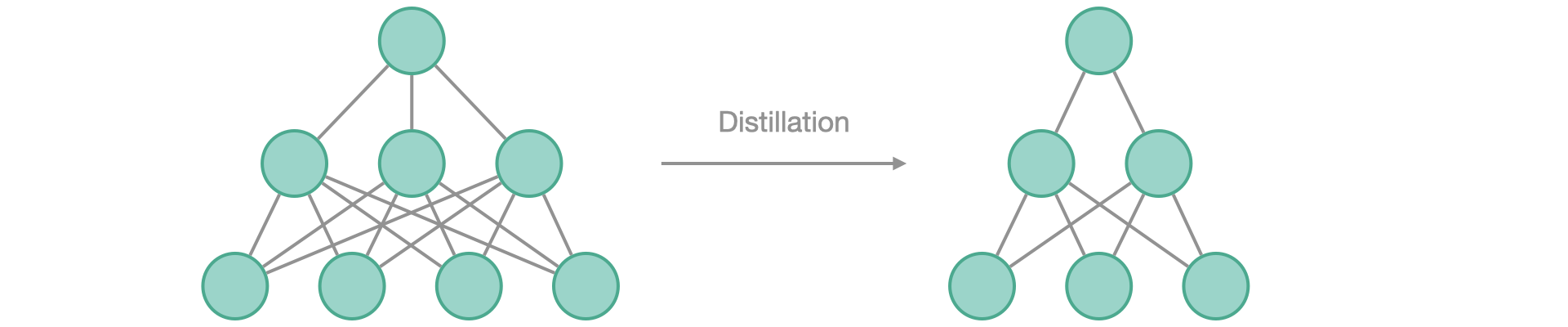

- 知识蒸馏:将大模型的知识转移到小模型中

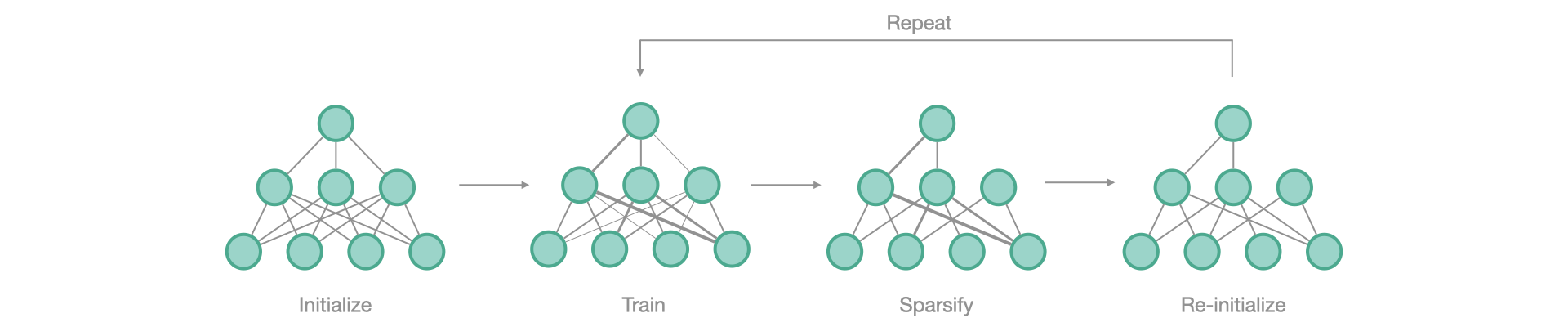

- 彩票假说:寻找网络中的"中奖彩票"子网络

快速上手FasterAI

使用FasterAI非常简单,只需几行代码即可完成模型压缩:

- 首先安装FasterAI:

pip install git+https://github.com/nathanhubens/fasterai.git

- 导入所需模块:

from fasterai.sparse.all import *

- 创建FastAI的Learner对象:

learn = cnn_learner(dls, model)

- 创建FasterAI的回调函数:

sp_cb = SparsifyCallback(sparsity, granularity, context, criteria, schedule)

- 训练模型:

learn.fit_one_cycle(n_epochs, cbs=sp_cb)

就这么简单,你的模型就开始变得更小更快了!

FasterAI的优势

-

与FastAI和PyTorch无缝集成:FasterAI基于FastAI和PyTorch构建,可以轻松地与现有的深度学习工作流程结合。

-

高度可定制:FasterAI的各个模块都可以根据需求进行自定义,为研究人员提供了极大的灵活性。

-

功能丰富:除了基本的剪枝功能,还提供了知识蒸馏、彩票假说等先进技术。

-

易于使用:简洁的API设计使得即使是深度学习初学者也能快速上手。

-

开源社区支持:活跃的GitHub社区和Discord讨论组,可以获得及时的帮助和支持。

应用场景

FasterAI可以应用在多种深度学习场景中:

-

移动设备部署:将大型模型压缩到可以在手机等移动设备上运行的规模。

-

边缘计算:优化模型以适应边缘设备的有限计算资源。

-

实时系统:加速模型推理速度,满足实时系统的低延迟需求。

-

模型蒸馏:将复杂的教师模型的知识转移到更小的学生模型中。

-

模型分析:通过剪枝和彩票假说实验,深入分析神经网络的结构和冗余性。

快速入门教程

FasterAI提供了一系列详细的教程,帮助用户快速掌握各项功能:

这些教程涵盖了从基础到高级的各种使用场景,是学习FasterAI的绝佳资源。

社区与支持

FasterAI拥有一个活跃的开源社区。你可以通过以下方式参与到FasterAI的开发和讨论中:

- GitHub仓库:https://github.com/nathanhubens/fasterai

- Discord讨论组:https://discord.gg/32BwhJSB9u

在这里,你可以报告问题、提出建议、分享你的项目,或者直接为FasterAI贡献代码。

结语

随着深度学习模型变得越来越大,模型压缩和加速技术的重要性也日益凸显。FasterAI作为一个强大而灵活的工具,为研究人员和工程师提供了一个便捷的解决方案。无论你是想将模型部署到移动设备,还是对神经网络结构进行深入研究,FasterAI都能为你提供所需的工具和支持。

让我们一起探索FasterAI的潜力,共同推动深度学习向更快、更小、更高效的方向发展!