FasterTransformer - 高性能Transformer模型推理加速库

FasterTransformer是NVIDIA开发的一个高性能Transformer模型推理加速库,专门用于优化基于Transformer架构的编码器和解码器组件。它通过CUDA、cuBLAS等底层库实现,可以显著提升BERT、GPT等大型语言模型的推理速度。

主要特性

- 针对Transformer层进行了高度优化,支持编码器和解码器

- 自动利用Tensor Core计算能力(当使用FP16精度时)

- 提供C++、TensorFlow、PyTorch和Triton后端API

- 支持多种模型,如BERT、GPT、T5等

- 支持FP16、INT8等低精度推理

- 支持张量并行和流水线并行

支持矩阵

FasterTransformer对主流Transformer模型提供了全面的支持:

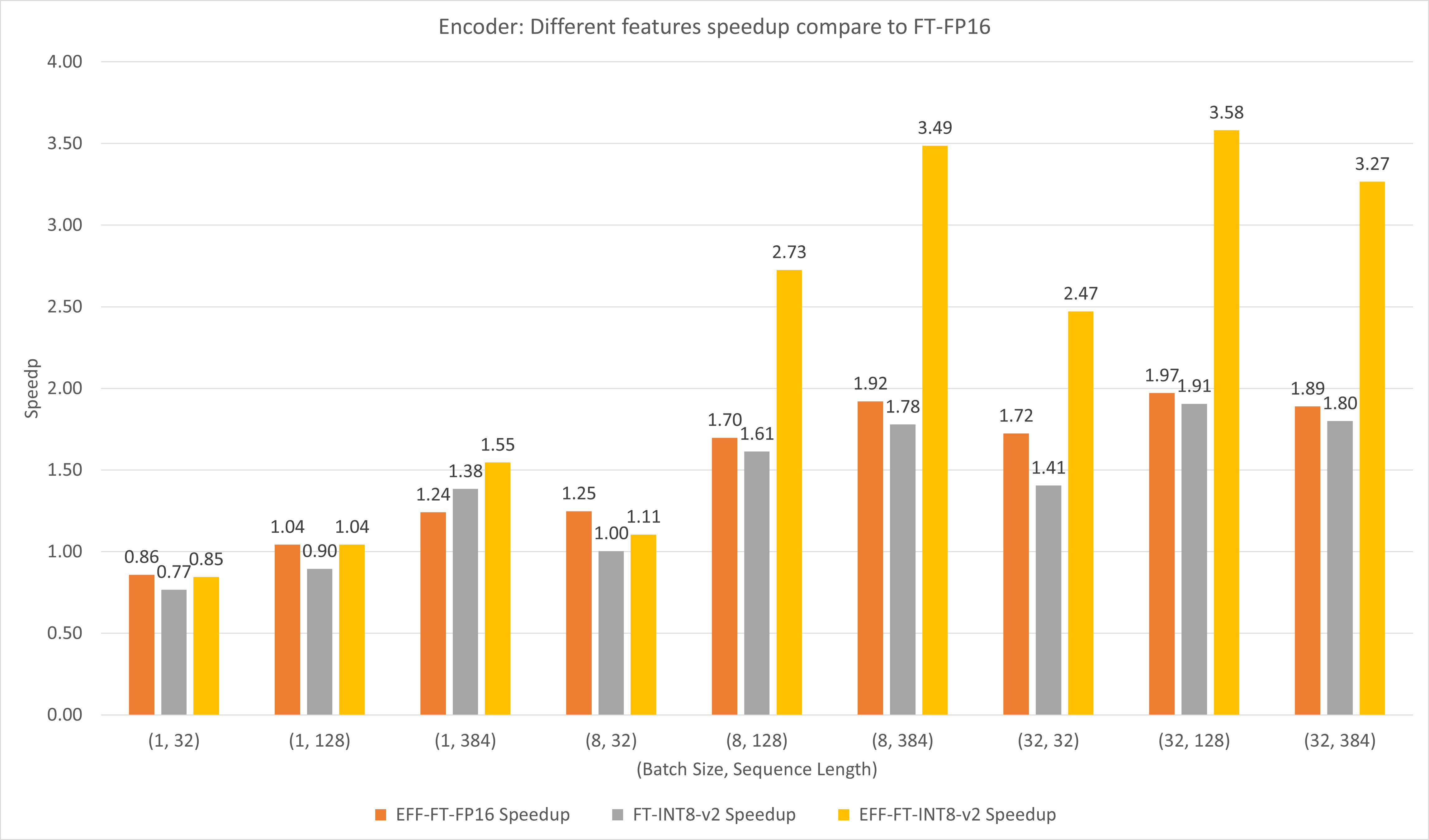

性能表现

在T4 GPU上,FasterTransformer相比原生框架可以带来显著的性能提升:

- BERT模型:小批量下可达3-6倍加速,大批量下可达5倍加速

- GPT模型:可达1.35-3.73倍加速

快速使用

- 克隆FasterTransformer代码库

git clone https://github.com/NVIDIA/FasterTransformer.git

cd FasterTransformer

- 编译安装

mkdir build && cd build

cmake -DSM=75 -DCMAKE_BUILD_TYPE=Release ..

make -j

- 运行示例

./bin/bert_example 32 12 32 12 64 0 0

更多使用方法请参考官方文档。

FasterTransformer为Transformer模型推理提供了强大的加速能力,是部署大规模语言模型的重要工具。欢迎读者尝试使用并分享使用体验!