FunClip: 开源视频剪辑的新纪元

在当今信息爆炸的时代,视频内容的快速提取和精准剪辑变得越来越重要。FunClip应运而生,为用户提供了一个强大而易用的开源视频剪辑工具。本文将深入介绍FunClip的特性、功能和使用方法,展示它如何revolutionize视频处理流程。

FunClip简介

FunClip是由阿里巴巴达摩院语音实验室开源的自动化视频剪辑工具。它利用先进的语音识别技术和大语言模型,实现了视频内容的精准识别和智能剪辑。作为一个完全开源的项目,FunClip为研究人员和开发者提供了探索和改进视频处理技术的平台。

核心特性

FunClip的核心优势在于其强大而全面的功能:

- 先进的语音识别: FunClip集成了阿里巴巴开源的工业级模型Paraformer-Large,这是目前最先进的开源中文语音识别(ASR)模型之一。它不仅能够准确识别语音内容,还能精确预测时间戳。

- 热词定制: 通过SeACo-Paraformer的热词定制功能,用户可以指定特定的实体词或名称作为热词,进一步提高识别准确率。

- 说话人识别: 集成CAM++说话人识别模型,能够自动识别不同说话人,并支持基于说话人ID进行视频片段的剪辑。

- 多段自由剪辑: 支持用户自由选择多个文本片段或说话人进行剪辑,灵活性极高。

- 字幕生成: 自动生成全视频SRT字幕和目标片段SRT字幕,为后续编辑和翻译工作提供便利。

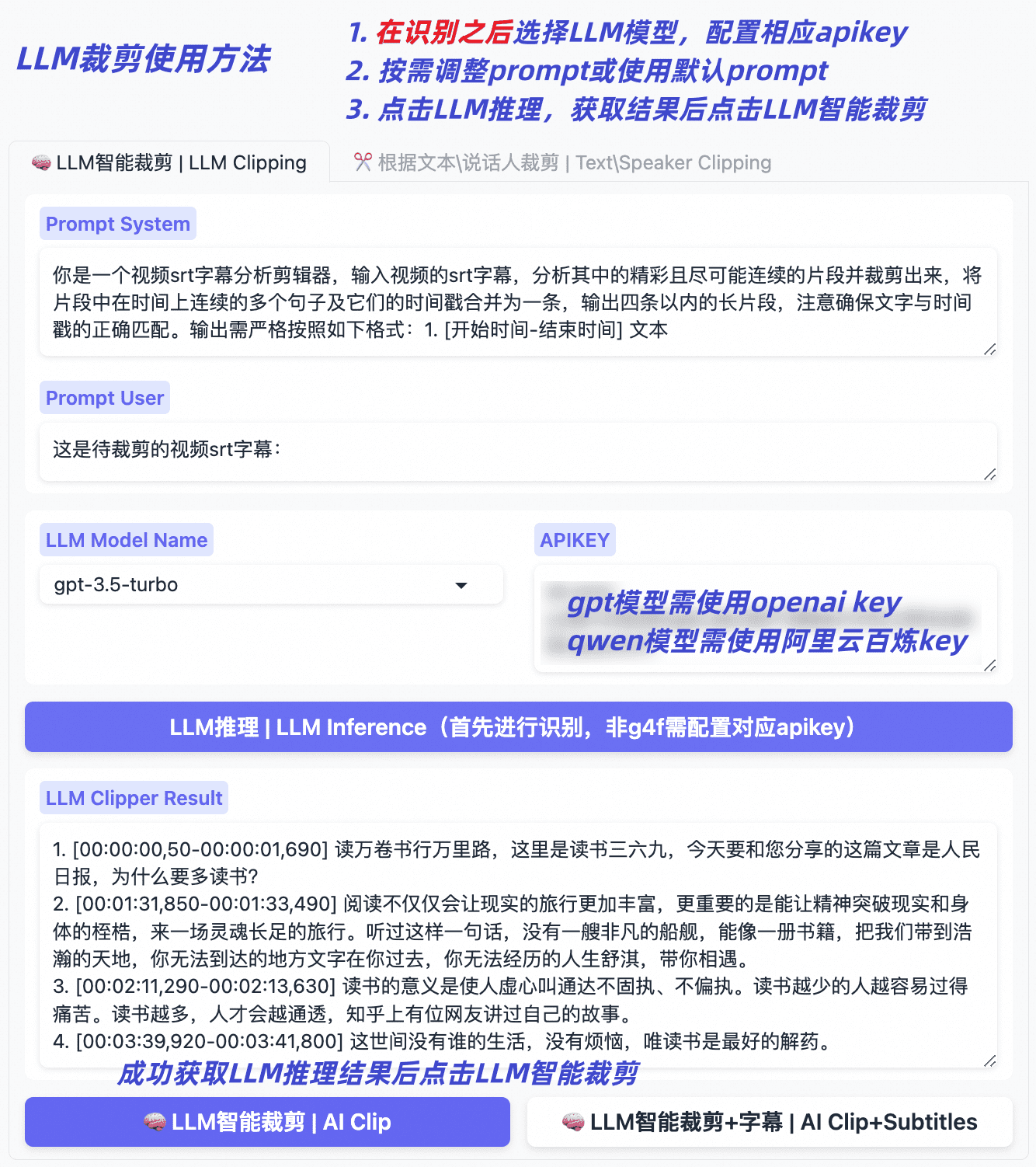

- 大语言模型集成: FunClip v2.0.0引入了基于大语言模型的智能剪辑功能,支持qwen系列、GPT系列等多种模型,开启了AI辅助视频剪辑的新篇章。

使用方法

FunClip的使用非常简单直观,主要有以下几种方式:

- 本地Gradio服务:

用户可以通过简单的命令在本地启动FunClip服务:

然后访问python funclip/launch.pylocalhost:7860即可使用Web界面进行操作。 - 命令行使用:

FunClip也支持命令行操作,例如:

python funclip/videoclipper.py --stage 1 --file example.mp4 --output_dir ./output - 在线体验: 用户可以在ModelScope创空间或HuggingFace Space上直接体验FunClip的功能。

安装与配置

FunClip的安装过程简单明了:

- 克隆仓库:

git clone https://github.com/alibaba-damo-academy/FunClip.git cd FunClip - 安装依赖:

pip install -r ./requirements.txt - (可选)安装imagemagick以支持字幕嵌入功能。

最新更新与未来展望

FunClip团队一直在积极改进和扩展项目功能:

- 最新版本支持英文音频文件的识别和剪辑。

- 引入了基于大语言模型的智能剪辑功能,开启了AI辅助视频编辑的新时代。

- 未来计划支持Whisper模型,进一步增强英文视频处理能力。

- 持续探索大语言模型在视频剪辑中的应用,欢迎社区贡献创意和实现。

社区与生态

FunClip是一个开放的社区项目,欢迎各界开发者和研究者参与贡献。项目维护团队提供了多个交流渠道:

- GitHub仓库: https://github.com/modelscope/FunClip

- 钉钉群和微信群: 可扫描官方提供的二维码加入

此外,FunClip是更大的FunASR生态系统的一部分。FunASR旨在搭建学术研究和工业应用之间的桥梁,推动语音识别技术的发展。

结语

FunClip作为一款开源、精准、易用的视频语音识别与剪辑工具,为内容创作者、研究人员和开发者提供了强大的支持。它不仅简化了视频处理流程,还通过开源模式促进了技术创新和社区协作。随着大语言模型等前沿技术的不断集成,FunClip正在开创视频处理的新纪元。无论您是视频创作者、技术爱好者还是研究人员,FunClip都值得您深入探索和使用。

让我们一起拥抱FunClip,开启视频处理的无限可能!