GPT-2客户端:让AI文本生成触手可及

在人工智能和自然语言处理领域,GPT-2模型无疑是一个里程碑式的存在。作为OpenAI开发的一款强大的语言模型,GPT-2凭借其惊人的文本生成能力,在学术界和工业界都引起了广泛关注。然而,对于许多开发者和研究人员来说,直接使用GPT-2模型可能存在一定的技术门槛。为了使这一强大工具更加易于使用,一位名叫Rishabh Anand的开发者创建了gpt2-client项目,为GPT-2模型提供了一个简洁而功能强大的Python封装器。

gpt2-client:GPT-2的得力助手

gpt2-client是一个围绕OpenAI原始gpt-2仓库构建的包装器,它保留了原始功能的同时,大大提高了可访问性、可理解性和实用性。使用gpt2-client,开发者只需几行代码就能够使用GPT-2的四个版本模型(117M、345M、774M和1.5B)进行文本生成。

主要特性

-

易于安装和使用: 通过pip即可轻松安装,支持Python 3.5及以上版本。

-

支持多个GPT-2模型版本: 可以使用117M、345M、774M和1.5B四个不同规模的模型。

-

灵活的文本生成选项: 支持交互式生成、批量生成、自定义提示等多种生成方式。

-

模型微调功能: 允许用户使用自定义数据集对模型进行微调,以适应特定领域的文本生成需求。

-

文本编码和解码: 提供了将文本序列转换为模型可理解的编码,以及将编码转回人类可读文本的功能。

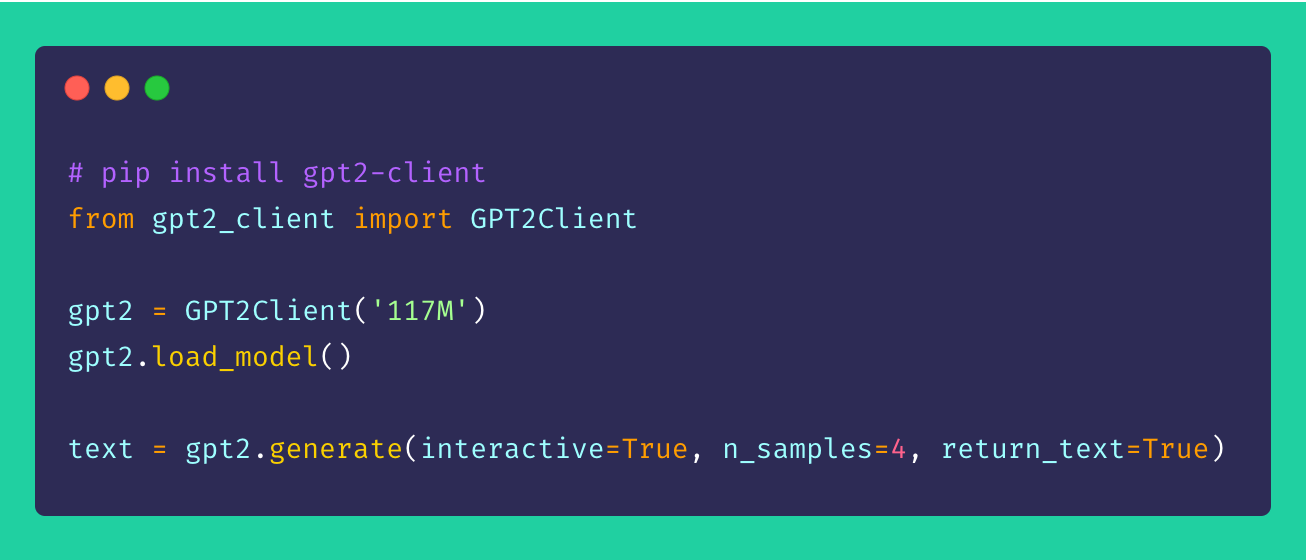

安装与基本使用

安装gpt2-client非常简单,只需通过pip执行以下命令:

pip install gpt2-client

注意: gpt2-client目前不兼容TensorFlow 2.0,建议使用TensorFlow 1.14.0版本。

安装完成后,使用gpt2-client生成文本只需几行代码:

from gpt2_client import GPT2Client

# 初始化客户端并加载模型

gpt2 = GPT2Client('117M') # 可选择'345M', '774M', 或 '1558M'

gpt2.load_model()

# 生成文本

generated_text = gpt2.generate(interactive=True) # 交互式生成

multiple_samples = gpt2.generate(n_samples=4) # 生成多个样本

高级功能

批量文本生成

gpt2-client支持从多个提示词批量生成文本:

prompts = [

"人工智能的未来",

"气候变化的影响",

"太空探索的重要性",

"教育改革的必要性"

]

batch_generated_text = gpt2.generate_batch_from_prompts(prompts)

模型微调

对于有特定领域文本生成需求的用户,gpt2-client提供了模型微调功能:

my_corpus = './data/custom_dataset.txt'

fine_tuned_text = gpt2.finetune(my_corpus, return_text=True)

提示: 进行模型微调时,建议使用GPU或TPU以加速训练过程。Google Colab是一个不错的选择。

文本编码与解码

gpt2-client还提供了文本序列的编码和解码功能:

# 编码文本

encoded_seq = gpt2.encode_seq("Hello world, this is a sentence")

# 解码编码序列

decoded_text = gpt2.decode_seq(encoded_seq)

GPT-2的应用前景

GPT-2模型及其客户端工具如gpt2-client的出现,为自然语言处理领域带来了诸多可能性:

-

内容创作辅助: 帮助作家、记者等创作者生成初始草稿或获取灵感。

-

对话系统: 构建更加自然、流畅的聊天机器人和虚拟助手。

-

语言翻译: 辅助改进机器翻译系统的流畅度和准确性。

-

教育工具: 生成练习题、模拟对话等教学资源。

-

营销与广告: 自动生成产品描述、广告文案等。

-

代码生成: 辅助程序员编写代码注释、文档等。

注意事项与伦理考量

尽管GPT-2及其客户端工具如gpt2-client带来了巨大的可能性,但在使用过程中我们也需要注意一些潜在的风险和伦理问题:

-

内容真实性: GPT-2生成的文本可能看似真实,但可能包含虚假或误导性信息。使用者应当谨慎验证生成内容的准确性。

-

版权问题: 大规模语言模型训练时使用的数据可能涉及版权问题,使用生成内容时需注意潜在的法律风险。

-

偏见与歧视: 模型可能会无意中复制训练数据中存在的偏见,使用时应当注意识别和消除这些偏见。

-

滥用风险: 这类强大的文本生成工具可能被用于生成垃圾邮件、假新闻等有害内容,使用时应当遵守相关法律法规和道德准则。

-

隐私保护: 在使用自定义数据集进行模型微调时,需确保不会泄露敏感的个人信息。

结语

gpt2-client为开发者和研究人员提供了一个便捷的途径来利用GPT-2这一强大的语言模型。它不仅简化了模型的使用过程,还提供了灵活的功能以适应各种应用场景。然而,正如技术的发展往往伴随着责任的增加,我们在享受GPT-2带来的便利的同时,也应当谨慎考虑其潜在的影响,确保这一技术被用于促进人类知识的进步和社会的发展。

随着自然语言处理技术的不断进步,我们可以期待在gpt2-client的基础上,未来会出现更加强大、更易使用的工具,进一步推动AI辅助创作、智能对话等领域的发展。对于开发者和研究者而言,积极探索GPT-2及类似模型的应用潜力,同时保持对技术伦理的敏感,将是一条充满挑战却也富有意义的道路。

贡献与支持

gpt2-client是一个开源项目,欢迎社区成员为其发展做出贡献。如果你有任何建议、改进或遇到问题,可以在项目的GitHub页面提出issues或提交pull requests。同时,如果你觉得这个项目对你有帮助,也可以考虑通过Buy Me A Coffee平台支持开发者Rishabh Anand,鼓励他继续维护和改进这个有价值的工具。

让我们共同期待GPT-2模型和gpt2-client在未来带来更多令人兴奋的应用和突破!

🔗 相关链接: