HiDiffusion:提升预训练扩散模型的分辨率和效率

随着人工智能技术的飞速发展,扩散模型在高分辨率图像合成领域展现出了巨大的潜力。然而,直接使用预训练的扩散模型生成更高分辨率的图像往往会遇到一些棘手的问题,如不合理的物体重复和生成时间的指数级增加。为了解决这些问题,研究人员提出了一种名为HiDiffusion的创新方法,旨在提高预训练扩散模型的分辨率和效率。

HiDiffusion的核心理念

HiDiffusion的核心思想是通过一种训练无关的方法来提高预训练扩散模型的性能。研究人员发现,物体重复的问题源于U-Net深层块中的特征重复,而生成时间过长则是由于U-Net顶层块中的自注意力冗余造成的。基于这些发现,HiDiffusion提出了两个关键组件:

-

分辨率感知U-Net(RAU-Net):动态调整特征图大小,以解决物体重复问题。

-

修改的滑动窗口多头自注意力(MSW-MSA):利用优化的窗口注意力机制来减少计算量。

这两个组件的结合使得HiDiffusion能够在保持图像质量的同时,显著提高生成速度和分辨率。

HiDiffusion的优势

-

高效性: HiDiffusion能够以1.5-6倍于以往方法的推理速度生成高达4096x4096分辨率的图像。

-

即插即用: HiDiffusion设计为一种即插即用的实现方式,只需添加一行代码即可集成到现有的扩散pipelines中。

-

多任务支持: 支持多种任务,包括文本到图像、图像到图像和修复等。

-

广泛兼容性: 支持多种流行的预训练扩散模型,如Stable Diffusion XL、Stable Diffusion XL Turbo、Stable Diffusion v2和Stable Diffusion v1等。

HiDiffusion的应用示例

为了更直观地展示HiDiffusion的强大功能,我们来看几个具体的应用示例:

1. 文本到图像生成

使用Stable Diffusion XL模型,我们可以轻松生成高分辨率的图像:

from hidiffusion import apply_hidiffusion

from diffusers import StableDiffusionXLPipeline, DDIMScheduler

import torch

# 初始化模型和pipeline

pretrain_model = "stabilityai/stable-diffusion-xl-base-1.0"

scheduler = DDIMScheduler.from_pretrained(pretrain_model, subfolder="scheduler")

pipe = StableDiffusionXLPipeline.from_pretrained(pretrain_model, scheduler=scheduler, torch_dtype=torch.float16, variant="fp16").to("cuda")

# 应用HiDiffusion

apply_hidiffusion(pipe)

# 生成图像

prompt = "Standing tall amidst the ruins, a stone golem awakens, vines and flowers sprouting from the crevices in its body."

negative_prompt = "blurry, ugly, duplicate, poorly drawn face, deformed, mosaic, artifacts, bad limbs"

image = pipe(prompt, guidance_scale=7.5, height=2048, width=2048, eta=1.0, negative_prompt=negative_prompt).images[0]

image.save("golem.jpg")

这个例子展示了如何使用HiDiffusion生成一个2048x2048分辨率的图像。通过简单地调整height和width参数,我们甚至可以生成4096x4096的超高分辨率图像。

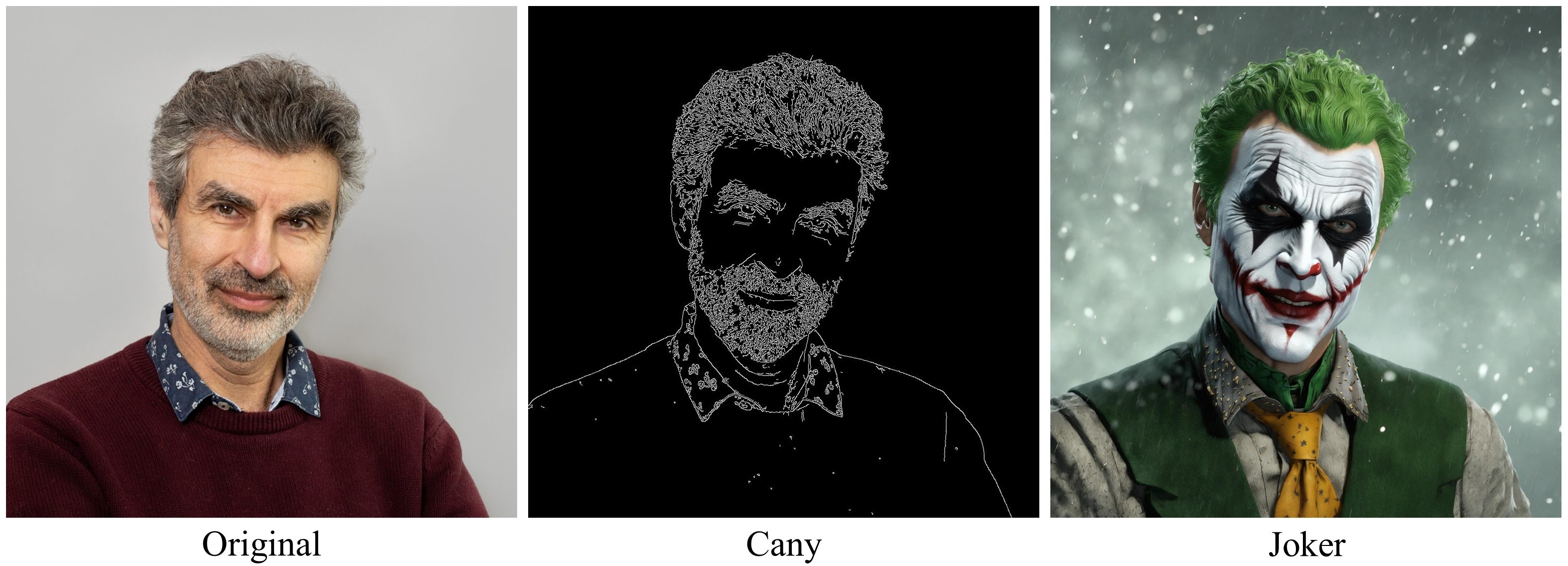

2. ControlNet应用

HiDiffusion还支持ControlNet,允许更精确的图像生成控制:

from diffusers import StableDiffusionXLControlNetPipeline, ControlNetModel, DDIMScheduler

import numpy as np

import torch

import cv2

from PIL import Image

from hidiffusion import apply_hidiffusion

# 加载和处理输入图像

path = './assets/Yoshua_Bengio.jpg'

image = Image.open(path)

image = np.array(image)

image = cv2.Canny(image, 100, 200)

image = image[:, :, None]

image = np.concatenate([image, image, image], axis=2)

canny_image = Image.fromarray(image)

# 初始化模型和pipeline

controlnet = ControlNetModel.from_pretrained(

"diffusers/controlnet-canny-sdxl-1.0", torch_dtype=torch.float16, variant="fp16"

)

scheduler = DDIMScheduler.from_pretrained("stabilityai/stable-diffusion-xl-base-1.0", subfolder="scheduler")

pipe = StableDiffusionXLControlNetPipeline.from_pretrained(

"stabilityai/stable-diffusion-xl-base-1.0", controlnet=controlnet, torch_dtype=torch.float16,

scheduler = scheduler

)

# 应用HiDiffusion

apply_hidiffusion(pipe)

# 生成图像

prompt = "The Joker, high face detail, high detail, muted color, 8k"

negative_prompt = "blurry, ugly, duplicate, poorly drawn, deformed, mosaic."

image = pipe(

prompt, controlnet_conditioning_scale=0.5, image=canny_image,

height=2048, width=2048, guidance_scale=7.5, negative_prompt=negative_prompt, eta=1.0

).images[0]

image.save('joker.jpg')

这个例子展示了如何使用HiDiffusion结合ControlNet来生成高度控制的图像。

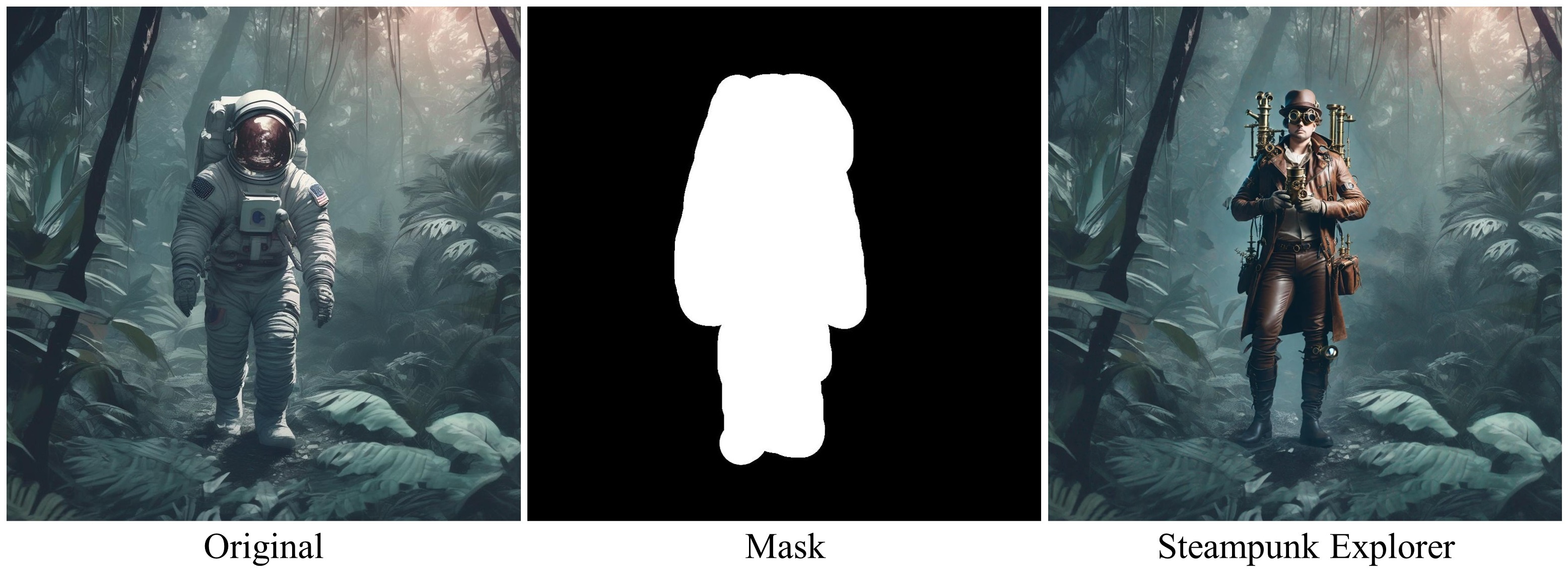

3. 图像修复

HiDiffusion还支持图像修复任务:

import torch

from diffusers import AutoPipelineForInpainting, DDIMScheduler

from diffusers.utils import load_image

from hidiffusion import apply_hidiffusion

from PIL import Image

scheduler = DDIMScheduler.from_pretrained("stabilityai/stable-diffusion-xl-base-1.0", subfolder="scheduler")

pipeline = AutoPipelineForInpainting.from_pretrained(

"diffusers/stable-diffusion-xl-1.0-inpainting-0.1", torch_dtype=torch.float16, variant="fp16",

scheduler=scheduler

)

# 应用HiDiffusion

apply_hidiffusion(pipeline)

# 加载基础图像和遮罩

img_url = "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/diffusers/sdxl-text2img.png"

init_image = load_image(img_url)

mask_image = Image.open("./assets/mask_image.png")

prompt = "A steampunk explorer in a leather aviator cap and goggles, with a brass telescope in hand, stands amidst towering ancient trees, their roots entwined with intricate gears and pipes."

negative_prompt = "blurry, ugly, duplicate, poorly drawn, deformed, mosaic"

image = pipeline(prompt=prompt, image=init_image, mask_image=mask_image, height=2048, width=2048, strength=0.85, guidance_scale=12.5, negative_prompt=negative_prompt, eta=1.0).images[0]

image.save('steampunk_explorer.jpg')

这个例子展示了如何使用HiDiffusion进行高分辨率的图像修复。

HiDiffusion的未来展望

HiDiffusion的出现为AI图像生成领域带来了新的可能性。它不仅提高了生成图像的分辨率和质量,还大大提升了生成速度,使得高质量、高分辨率的AI图像生成变得更加高效和实用。

未来,我们可以期待看到HiDiffusion在以下方面的进一步发展:

-

更广泛的模型支持: 随着更多预训练扩散模型的出现,HiDiffusion有望扩展其兼容性,支持更多种类的模型。

-

更高的分辨率: 虽然目前已经能够支持4096x4096的分辨率,但未来可能会看到更高分辨率的突破。

-

更多样的应用场景: 除了现有的文本到图像、图像到图像和修复任务,HiDiffusion可能会扩展到更多的应用领域,如视频生成、3D模型生成等。

-

更优化的性能: 随着研究的深入,HiDiffusion的核心算法可能会得到进一步优化,带来更快的速度和更高的效率。

-

与其他AI技术的结合: HiDiffusion可能会与其他AI技术,如大型语言模型(LLM)或强化学习等结合,创造出更加智能和创新的图像生成系统。

总的来说,HiDiffusion为AI图像生成领域注入了新的活力,它的出现不仅推动了技术的进步,也为创意工作者和开发者提供了强大的工具。随着技术的不断发展和完善,我们有理由相信,HiDiffusion将在未来的AI图像生成领域扮演越来越重要的角色。