Higgsfield简介

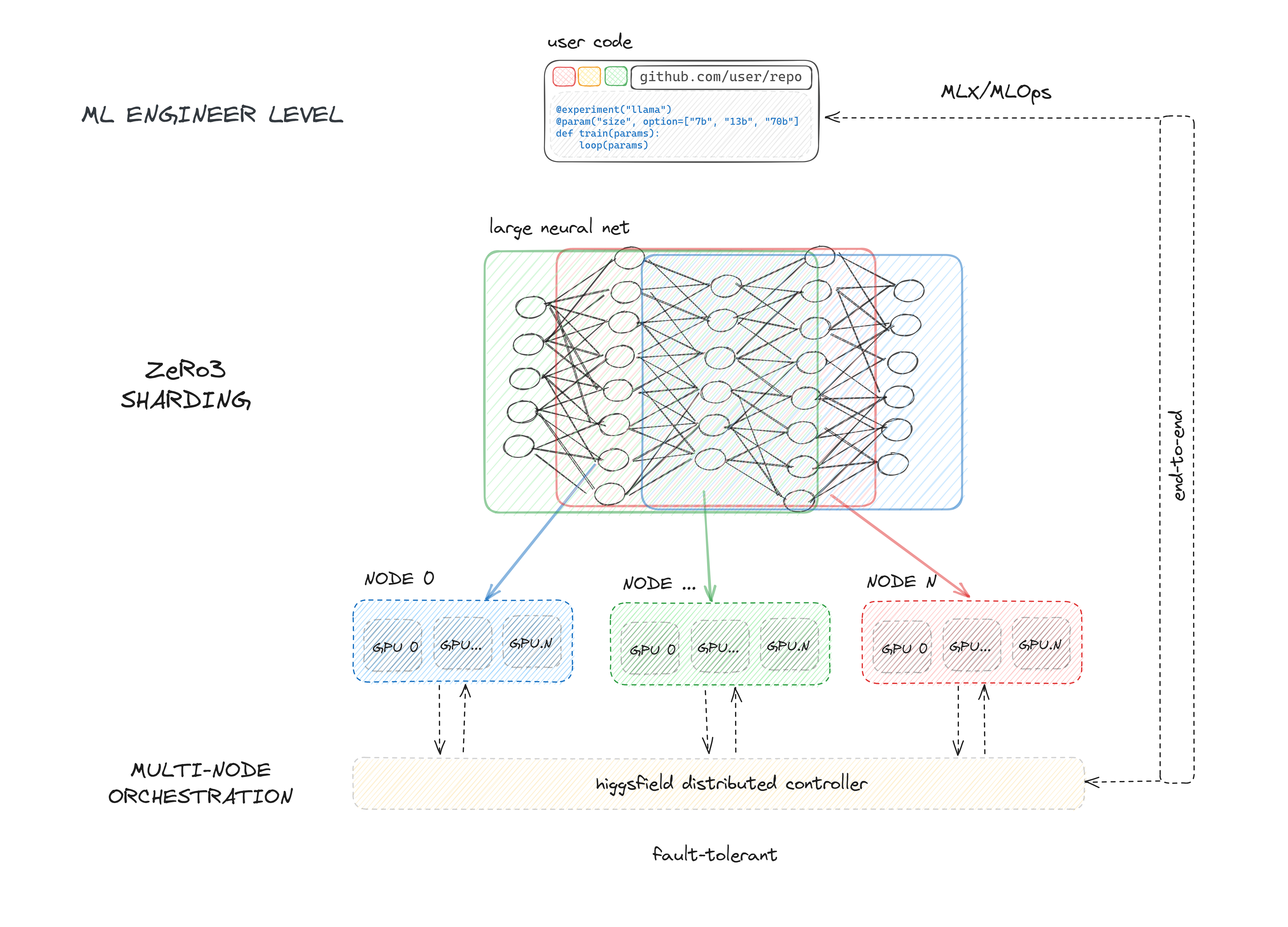

Higgsfield是一个开源的、容错的、高度可扩展的GPU编排和机器学习框架,专为训练大型语言模型(LLM)等拥有数十亿到万亿参数的模型而设计。它提供了一套完整的解决方案,用于管理GPU工作负载和训练大规模神经网络。

Higgsfield的主要功能包括:

- 为用户分配独占和非独占的计算资源(节点)用于训练任务

- 支持ZeRO-3 deepspeed API和PyTorch的完全分片数据并行API,实现万亿参数模型的高效分片

- 提供一个框架来启动、执行和监控分配节点上大型神经网络的训练

- 通过维护实验运行队列来管理资源竞争

- 通过与GitHub和GitHub Actions的无缝集成,促进机器学习开发的持续集成

快速入门

要开始使用Higgsfield,可以按以下步骤操作:

- 安装Higgsfield:

pip install higgsfield==0.0.3

核心特性

-

分布式训练: Higgsfield支持高效的分布式训练,可以轻松扩展到多个GPU和多个节点。

-

环境管理: 不再需要处理不同版本的PyTorch、NVIDIA驱动程序和数据处理库。Higgsfield可以轻松编排实验及其环境。

-

简化配置: Higgsfield引入了一个简单的接口来定义实验,无需复杂的配置文件。

-

容错设计: Higgsfield具有容错能力,可以处理训练过程中的各种故障情况。

-

与GitHub集成: 通过与GitHub和GitHub Actions的集成,实现机器学习开发的持续集成。

学习资源

-

官方文档: 包含详细的使用说明和API文档。

-

设置指南: 帮助你快速设置环境并开始使用Higgsfield。

-

教程: 提供了常见任务的API使用示例,如分布式模型训练、数据准备、模型优化等。

-

示例代码: 官方仓库中提供了多个示例代码,展示如何使用Higgsfield训练大型模型。

-

GitHub Issues: 如果遇到问题或有feature请求,可以在这里提出。

-

Twitter: 关注官方Twitter账号,获取最新的功能更新和公告。

-

官方网站: 提供更多关于Higgsfield的讨论和新闻。

社区支持

Higgsfield拥有活跃的开发者社区,你可以通过以下方式获取帮助:

- GitHub Issues: 报告bug、提出feature请求或咨询使用问题

- Twitter: 关注最新动态和功能更新

- 官方网站: 参与讨论,了解最新新闻

Higgsfield团队通常会在1天内响应GitHub Issues,对于Twitter和官网的查询也会及时回复。

通过以上资源,你可以全面了解Higgsfield,并开始使用这个强大的工具来训练你的大规模模型。无论你是想尝试最新的LLM技术,还是需要一个可扩展的分布式训练解决方案,Higgsfield都能满足你的需求。

Happy training! 🚀🧠💻