hlb-CIFAR10:重新定义深度学习训练速度的极限

在机器学习和深度学习领域,模型训练速度一直是一个备受关注的话题。训练速度直接影响了研究人员和工程师的工作效率,也决定了模型在实际应用中的可行性。在这个背景下,一个名为hlb-CIFAR10的开源项目横空出世,以其惊人的训练速度引起了广泛关注。

项目概述

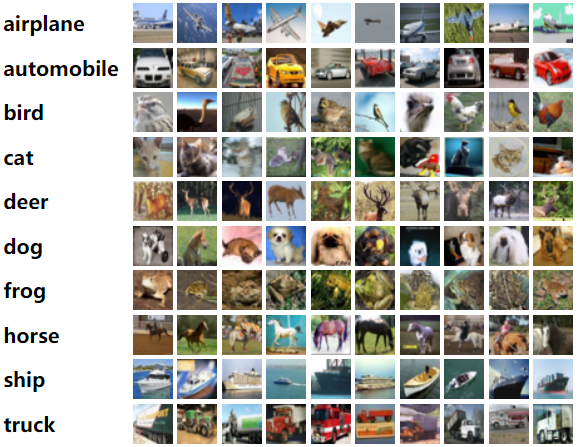

hlb-CIFAR10是由开发者Fern(GitHub用户名tysam-code)创建的一个开源项目。该项目的主要目标是在CIFAR-10数据集上实现极速训练,同时保持较高的准确率。CIFAR-10是计算机视觉领域常用的基准数据集,包含60,000张32x32的彩色图像,分为10个类别。

项目的最新成果令人惊叹:在单个NVIDIA A100 GPU上,仅需不到6.3秒就能将模型训练至94%的准确率。这一成绩比项目最初的18.1秒提升了近3倍,创造了新的世界纪录。

技术特点与创新

- 极简主义设计

hlb-CIFAR10的一个显著特点是其极简主义设计理念。整个项目仅由一个Python文件构成,这种设计使得代码易于理解和修改,非常适合快速实验和迭代。

- 自定义网络架构

项目采用了自定义的神经网络架构,相比原始实现更加高效。值得注意的是,开发者移除了显式的残差层,这一大胆尝试竟然带来了性能的提升。

- 内存格式优化

为了更好地利用GPU的张量核心,项目对内存格式进行了优化。这些细节上的改进对训练速度的提升起到了关键作用。

- 超参数精调

开发者投入了大量精力对模型的超参数进行调优。这种精细化的调整工作虽然耗时,但对最终性能的提升至关重要。

- Dirac初始化

在非深度过渡层上应用Dirac初始化,这种技术可以在网络初始化时实现信息的直接传递,有助于训练的快速收敛。

运行与使用

使用hlb-CIFAR10非常简单,只需几个命令即可:

git clone https://github.com/tysam-code/hlb-CIFAR10

cd hlb-CIFAR10

python main.py

项目依赖CUDA环境,如果未安装PyTorch和torchvision,可以通过以下命令安装:

python -m pip install -r requirements.txt

值得一提的是,该项目对Google Colab非常友好,大部分开发工作就是在Colab上完成的。这为那些没有高端GPU资源的研究者和学生提供了便利。

未来展望

hlb-CIFAR10的创建者设定了一个雄心勃勃的目标:在未来1-2年内将训练时间缩短至2秒以内,并在4-5年内达到1秒以下。虽然这些目标看似难以实现,但考虑到项目已经取得的进展,我们有理由保持乐观。

开发者计划探索的优化方向包括:

- 将FP16精度进一步降低到FP8

- 优化最大池化操作的反向传播

- 改进BatchNorm和卷积层的融合

- 信息流工程,更精确地调整每一层的深度

- 利用即将发布的PyTorch 2.0中的新特性

为什么选择卷积神经网络和CIFAR-10?

在当前Transformer模型大行其道的背景下,hlb-CIFAR10坚持使用卷积神经网络并聚焦于CIFAR-10数据集可能会引发疑问。开发者解释道,尽管Transformer确实是当前的热点,但他相信无论采用什么架构,信息从训练集凝练到神经网络的过程都遵循相似的数学原理。

选择CIFAR-10和相对简单的模型架构,使得研究人员可以快速验证各种想法,而无需耗费大量计算资源。这种方法有助于探索深度学习的基本原理,而这些原理往往可以推广到更复杂的模型和任务中。

社区参与和贡献

hlb-CIFAR10是一个开源项目,欢迎社区成员参与贡献。虽然目前项目暂时关闭了作为基准测试的提交通道,但开发者鼓励用户提出问题、报告bug或分享使用心得。这些反馈对项目的改进和开发者的成长都至关重要。

结语

hlb-CIFAR10项目展示了深度学习训练速度的新可能。它不仅创造了令人瞩目的记录,更为我们提供了一个思考和优化深度学习系统的新视角。随着项目的不断发展和完善,我们有理由期待它能为深度学习领域带来更多突破性的进展。

无论你是深度学习研究者、学生还是工程师,hlb-CIFAR10都值得你关注和尝试。它不仅可能改变你对模型训练速度的认知,还可能启发你在自己的项目中进行类似的优化。让我们共同期待hlb-CIFAR10在未来带来更多惊喜!