HumanArt数据集简介

HumanArt是一个创新的大规模人体数据集,旨在连接自然场景和人工场景中的人体相关任务。该数据集由国际数字经济研究院(IDEA)和香港中文大学的研究人员共同开发,发表于2023年IEEE/CVF计算机视觉与模式识别会议(CVPR 2023)。

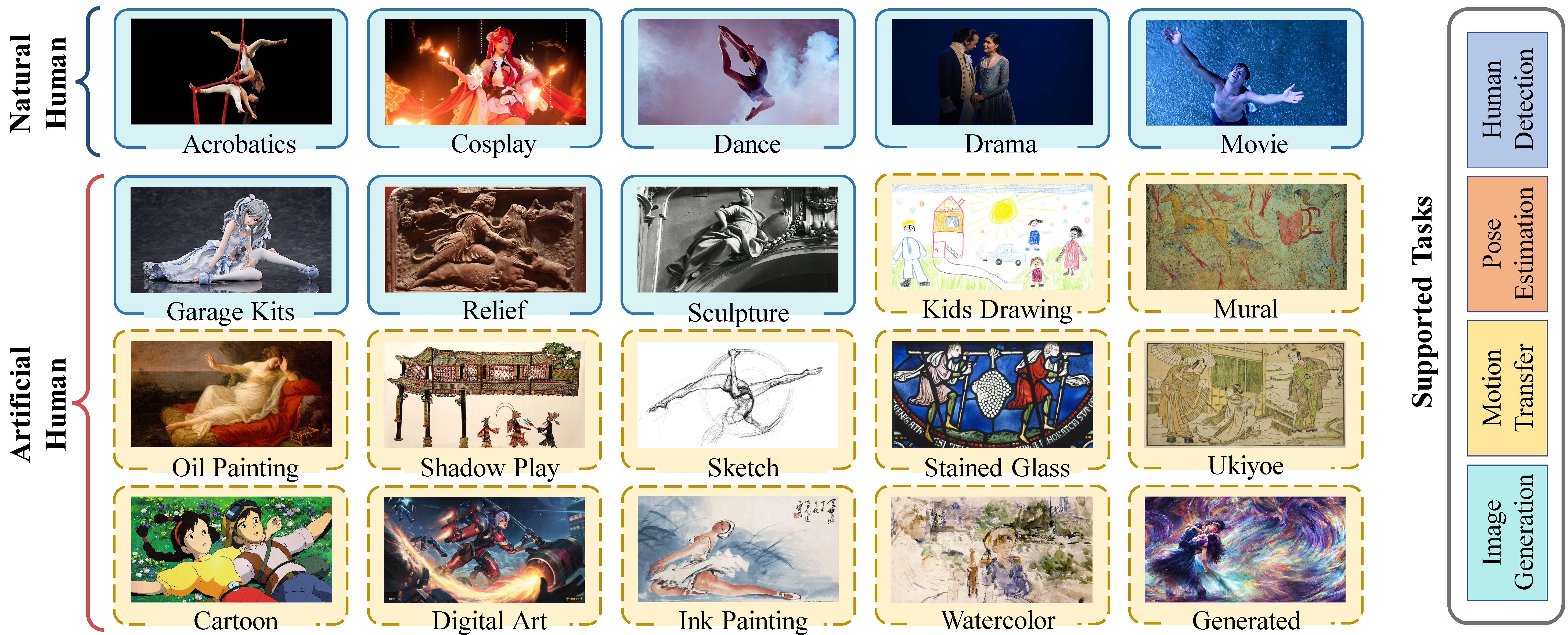

HumanArt数据集包含50,000张高质量图像,涵盖了20种不同的人体场景。这些场景分为三大类:

- 5种自然场景

- 3种2D人工场景

- 12种3D人工场景

数据集中的每张图像都标注了丰富的人体相关信息,包括人体边界框、21个2D人体关键点、人体自接触关键点以及描述文本。这些详细的标注使得HumanArt成为一个多功能的数据集,可用于多种人体相关任务的研究和开发。

HumanArt的主要特点

HumanArt数据集具有以下几个突出特点:

- 多样性:涵盖了从真实照片到卡通、3D渲染等多种人体表现形式,为模型提供了丰富的训练样本。

- 高质量标注:每张图像都有详细的人体边界框、关键点和描述文本标注,保证了数据的质量和可用性。

- 跨域应用:通过结合自然和人工场景,HumanArt为开发跨域人体分析算法提供了理想的数据基础。

- 多任务支持:数据集的设计支持多种人体相关任务,包括人体检测、姿态估计、3D人体重建等。

- 兼容性:HumanArt的数据格式与MSCOCO数据集兼容,便于研究人员快速应用到现有模型中。

HumanArt支持的主要任务

HumanArt数据集主要支持以下几类人体相关的计算机视觉任务:

- 多场景人体检测:在不同风格和表现形式的图像中准确定位人体。

- 2D人体姿态估计:估计图像中人体的2D关键点位置。

- 3D人体网格重建:从2D图像重建3D人体模型。

- 人体图像生成:生成多样化的人体图像,尤其是可控的人体图像生成(如根据姿态或文本条件)。

- 跨域人体分析:开发能够在不同风格图像间泛化的人体分析算法。

研究表明,在HumanArt和MSCOCO数据集上联合训练的模型,在MSCOCO测试集上的性能可以提高0.8个百分点。这说明多场景的图像数据可能有助于提升模型对真实场景的特征提取和人体理解能力。

数据集获取与使用

HumanArt数据集采用CC协议发布,可供非商业用途免费使用。研究人员可以通过填写在线表格申请使用授权。提交表格后,包含数据集的邮件将会自动发送到申请者的邮箱。

为了方便使用,HumanArt数据集采用了与MSCOCO相同的数据格式。下载数据集后,建议按照以下文件结构保存:

|-- data

|-- HumanArt

|-- annotations

|-- training_coco.json

|-- training_humanart.json

|-- training_humanart_coco.json

|-- training_humanart_cartoon.json

|-- ...

|-- images

|-- 2D_virtual_human

|-- 3D_virtual_human

|-- real_human

|-- coco

|-- annotations

|-- train2017

|-- val2017

HumanArt提供了多种不同的JSON标注文件,以支持不同的训练和评估需求:

*_coco.json: 重新处理的COCO数据集标注文件*_humanart.json: HumanArt数据集的标注文件*_humanart_coco.json: COCO和HumanArt数据集的组合标注文件*_humanart_[scenario].json: HumanArt特定场景的标注文件

此外,还提供了一个检测结果文件HumanArt_validation_detections_AP_H_56_person.json,用于评估自顶向下姿态估计模型的性能。

基于HumanArt的模型与性能

人体姿态估计

研究人员已经在HumanArt数据集上训练和评估了多种主流的人体姿态估计模型,包括ViTPose、HRNet和RTMPose等。这些模型在HumanArt验证集上的性能如下:

ViTPose模型性能 (使用经典解码器):

| 模型 | 输入尺寸 | AP | AP50 | AP75 | AR | AR50 |

|---|---|---|---|---|---|---|

| ViTPose-S-humanart-coco | 256x192 | 0.738 | 0.905 | 0.802 | 0.768 | 0.911 |

| ViTPose-B-humanart-coco | 256x192 | 0.759 | 0.905 | 0.823 | 0.790 | 0.917 |

| ViTPose-L-humanart-coco | 256x192 | 0.789 | 0.916 | 0.845 | 0.819 | 0.929 |

| ViTPose-H-humanart-coco | 256x192 | 0.800 | 0.926 | 0.855 | 0.828 | 0.933 |

HRNet模型性能 (使用经典解码器):

| 模型 | 输入尺寸 | AP | AP50 | AP75 | AR | AR50 |

|---|---|---|---|---|---|---|

| pose_hrnet_w32-humanart-coco | 256x192 | 0.754 | 0.906 | 0.812 | 0.783 | 0.916 |

| pose_hrnet_w48-humanart-coco | 256x192 | 0.769 | 0.906 | 0.825 | 0.796 | 0.919 |

RTMPose模型性能:

| 模型 | 输入尺寸 | AP | AP50 | AP75 | AR | AR50 |

|---|---|---|---|---|---|---|

| rtmpose-t-humanart-coco | 256x192 | 0.655 | 0.872 | 0.720 | 0.693 | 0.890 |

| rtmpose-s-humanart-coco | 256x192 | 0.698 | 0.893 | 0.768 | 0.732 | 0.903 |

| rtmpose-m-humanart-coco | 256x192 | 0.728 | 0.895 | 0.791 | 0.759 | 0.906 |

| rtmpose-l-humanart-coco | 256x192 | 0.753 | 0.905 | 0.812 | 0.783 | 0.915 |

这些模型的实现和更多细节可以在MMPose项目中找到。研究人员可以使用这些预训练模型作为基线,或者在此基础上进行进一步的改进和优化。

人体检测

HumanArt数据集也支持人体检测任务。研究人员在HumanArt上训练了多种目标检测模型,包括RTMDet和YOLOX系列。这些模型在HumanArt验证集上的性能如下:

| 检测模型 | 模型AP |

|---|---|

| RTMDet-tiny | 46.6 |

| RTMDet-s | 50.6 |

| YOLOX-nano | 38.9 |

| YOLOX-tiny | 47.7 |

| YOLOX-s | 54.6 |

| YOLOX-m | 59.1 |

| YOLOX-l | 60.2 |

| YOLOX-x | 61.3 |

这些模型的实现和更多细节可以在MMDetection项目中找到。研究人员可以使用这些预训练模型进行人体检测任务,或者在此基础上进行进一步的优化。

HumanArt的影响与应用

HumanArt数据集的发布为人体相关的计算机视觉研究带来了新的机遇:

- 跨域算法研究: HumanArt为开发能在不同风格图像间泛化的算法提供了理想的数据基础。这对于提高AI系统在复杂现实环境中的鲁棒性具有重要意义。

- 多模态学习: 结合图像和文本描述的标注方式,为多模态学习和跨模态任务提供了可能性,如基于文本的人体图像生成或检索。

- 虚拟与增强现实: 3D人体场景的数据对于发展虚拟现实和增强现实技术中的人体建模和交互至关重要。

- 计算机图形学: HumanArt中的多样化人体表现形式可以启发计算机图形学中的人体建模和渲染技术。

- 人机交互: 准确的人体姿态估计和3D重建对于开发更自然、直观的人机交互界面具有重要价值。

结语

HumanArt数据集的发布标志着人体相关的计算机视觉研究进入了一个新的阶段。通过bridging自然场景和人工场景,HumanArt为开发更加通用、鲁棒的人体分析算法提供了宝贵的资源。未来,我们可以期待看到更多基于HumanArt的创新研究成果,推动人工智能在理解和模拟人体方面取得突破性进展。

研究人员如果在工作中使用了HumanArt数据集,建议在论文中引用以下文献:

@inproceedings{ju2023human,

title={Human-Art: A Versatile Human-Centric Dataset Bridging Natural and Artificial Scenes},

author={Ju, Xuan and Zeng, Ailing and Wang, Jianan and Xu, Qiang and Zhang, Lei},

booktitle={Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year={2023},

}

通过广泛的应用和持续的改进,HumanArt有望成为推动人体相关计算机视觉技术发展的重要基石,为创造更智能、更自然的人机交互体验铺平道路。🚀👨🔬🤖