Interpret-Community:让机器学习模型更透明可解

在当今的人工智能时代,机器学习模型在各个领域发挥着越来越重要的作用。然而,随着模型复杂度的提高,其决策过程也变得越来越难以理解。这就引发了一个重要问题:如何让机器学习模型更加透明和可解释?Interpret-Community项目正是为解决这一问题而生。

什么是Interpret-Community?

Interpret-Community是一个开源的Python库,它扩展了微软研究院开发的Interpret项目。该项目的主要目标是为机器学习模型提供更多的可解释性技术和实用工具,以应对真实世界的数据集和工作流程。

Interpret-Community的核心理念是:

- 积极整合创新的实验性可解释性技术,并允许研究人员和数据科学家进一步扩展。

- 应用优化技术,使可解释性方法能够在大规模真实世界数据集上运行。

- 提供改进功能,如"反向特征工程管道"能力,以提供基于原始特征而非工程特征的模型洞察。

- 提供交互式和探索性可视化工具,使数据科学家能够深入了解其数据。

Interpret-Community的主要特性

1. 支持多种模型类型

Interpret-Community支持在Python numpy.ndarray、pandas.DataFrame或scipy.sparse.csr_matrix格式的数据集上训练的模型。它不仅适用于常见的机器学习模型,还支持通过PyTorch、TensorFlow和Keras等深度学习框架训练的模型。

2. 丰富的解释器选择

Interpret-Community提供了多种解释器,以满足不同场景的需求:

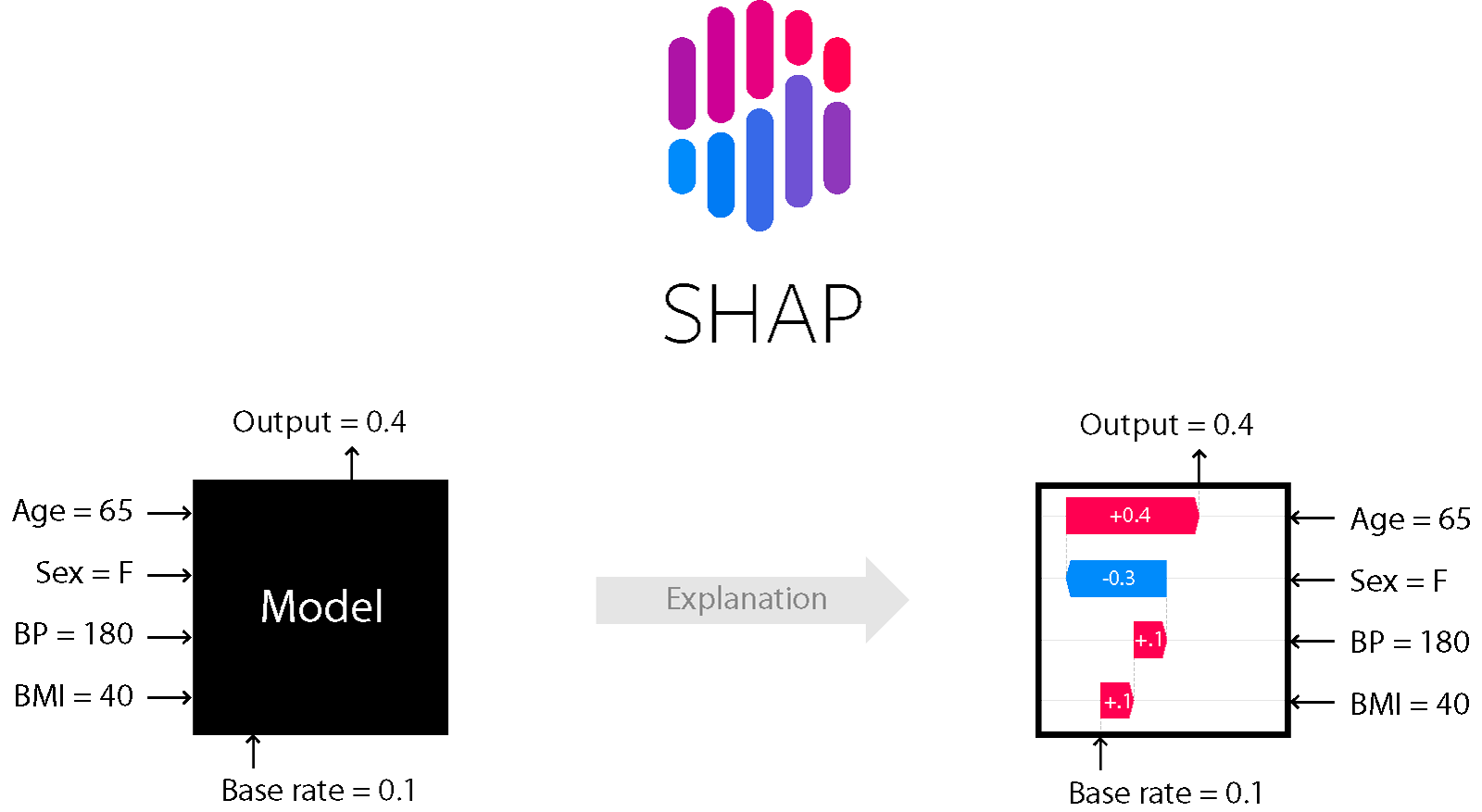

- SHAP Kernel Explainer: 使用特殊加权的局部线性回归来估计任何模型的SHAP值。

- GPU SHAP Kernel Explainer: 利用GPU加速版本的SHAP Kernel Explainer,特别适合快速GPU模型。

- SHAP Tree Explainer: 专门针对树模型和树集成模型的快速SHAP值估计算法。

- SHAP Deep Explainer: 用于深度学习模型的高速SHAP值近似算法。

- SHAP Linear Explainer: 计算线性模型的SHAP值,可选择考虑特征间相关性。

- Mimic Explainer (Global Surrogate): 基于训练全局代理模型来模仿黑盒模型的思想。

- Permutation Feature Importance Explainer (PFI): 通过随机打乱特征来计算特征重要性。

- LIME Explainer: 局部可解释的模型不可知解释(LIME)是对模型行为的局部线性近似。

3. TabularExplainer: 智能选择最佳解释器

除了上述解释器,Interpret-Community还提供了一个名为TabularExplainer的特殊解释器。它能根据模型类型自动选择最合适的SHAP解释器:

- 树模型: SHAP TreeExplainer

- 深度神经网络: SHAP DeepExplainer

- 线性模型: SHAP LinearExplainer

- 其他模型: SHAP KernelExplainer或GPUKernelExplainer

这种智能选择机制大大简化了用户的使用体验,无需手动选择最适合的解释器。

如何使用Interpret-Community?

使用Interpret-Community非常简单。首先,您需要通过pip安装该库:

pip install interpret-community

然后,您可以按照以下步骤使用Interpret-Community:

- 导入所需的模块:

from interpret.ext.blackbox import TabularExplainer

- 创建解释器实例:

explainer = TabularExplainer(model,

x_train,

features=breast_cancer_data.feature_names,

classes=classes)

- 计算全局解释:

global_explanation = explainer.explain_global(x_train)

- 计算局部解释:

local_explanation = explainer.explain_local(x_test[0:5])

可视化解释结果

Interpret-Community还提供了强大的可视化工具,帮助用户更直观地理解模型的决策过程。您可以使用ExplanationDashboard来加载交互式仪表板:

from raiwidgets import ExplanationDashboard

ExplanationDashboard(global_explanation, model, dataset=x_test, trueY=y_test)

这个仪表板提供了四个主要的标签页视图:

- 模型性能

- 数据探索器

- 聚合特征重要性

- 个体特征重要性和假设分析

通过这些可视化工具,数据科学家可以深入了解模型的行为,识别潜在的偏见,并做出更明智的决策。

Interpret-Community的优势

-

统一的API: 所有解释器都遵循相同的API,使用户可以轻松切换不同的解释技术。

-

性能优化: 针对大规模数据集进行了优化,使得在真实世界的数据上运行解释技术成为可能。

-

灵活性: 支持各种类型的模型和数据格式,适应性强。

-

可视化支持: 提供丰富的可视化工具,帮助用户更好地理解和解释模型。

-

社区驱动: 作为一个开源项目,Interpret-Community欢迎社区贡献,不断融入新的解释技术和功能。

结语

在机器学习模型日益复杂的今天,可解释性变得越来越重要。Interpret-Community为我们提供了一套强大的工具,帮助我们揭开模型决策的黑盒,增强了模型的透明度和可信度。无论您是数据科学家、研究人员还是机器学习工程师,Interpret-Community都是一个值得尝试的工具,它可以帮助您更好地理解和改进您的模型。

随着人工智能技术的不断发展,我们相信Interpret-Community这样的项目将在推动机器学习可解释性研究方面发挥越来越重要的作用。让我们共同期待Interpret-Community的未来发展,为构建更透明、更可信的AI系统贡献力量。