引言

在人工智能和语音技术快速发展的今天,语音转文本(Speech-to-Text)技术已成为众多应用不可或缺的组成部分。为了更好地评估和比较不同的语音转文本引擎的性能,Picovoice公司开源了一个minimalist且可扩展的基准测试框架 - Speech-to-Text Benchmark。本文将深入解析这个框架的各个方面,包括其使用的数据集、评估指标、支持的引擎以及使用方法,并对最新的基准测试结果进行分析。

数据集介绍

Speech-to-Text Benchmark框架使用了三个广泛认可的语音数据集:

-

LibriSpeech: 这是一个包含约1000小时清晰英语语音的大型语料库,由有声读物音频衍生而来。

-

TED-LIUM: 这个数据集包含TED演讲的音频记录和相应的转录文本,提供了各种口音和演讲风格的样本。

-

Common Voice: 由Mozilla发起的开源多语言语音数据集,包含来自全球志愿者贡献的各种语音样本。

这些数据集的多样性确保了基准测试能够在不同场景和条件下评估语音转文本引擎的性能。

评估指标

Speech-to-Text Benchmark使用以下三个主要指标来评估语音转文本引擎的性能:

1. 词错误率 (Word Error Rate, WER)

词错误率是衡量语音识别准确性的关键指标。它计算的是参考文本中的词与语音转文本引擎输出文本之间的编辑距离(插入、删除、替换的词数),除以参考文本中的总词数。WER越低,表示识别准确度越高。

2. 核心小时 (Core-Hour)

核心小时指标用于评估语音转文本引擎的计算效率。它表示处理一小时音频所需的CPU小时数。核心小时数越低,意味着引擎的计算效率越高。值得注意的是,这个指标仅适用于本地运行的引擎,不包括云端服务。

3. 模型大小

模型大小指标衡量的是语音转文本引擎使用的声学模型和语言模型的总大小,单位为MB。这个指标反映了引擎在存储和部署方面的资源需求。同样,这个指标也只适用于本地引擎。

支持的引擎

Speech-to-Text Benchmark框架支持多种主流的语音转文本引擎,包括:

- Amazon Transcribe

- Azure Speech-to-Text

- Google Speech-to-Text

- IBM Watson Speech-to-Text

- OpenAI Whisper

- Picovoice Cheetah

- Picovoice Leopard

这些引擎涵盖了云服务提供商、开源项目以及专业语音技术公司的产品,为用户提供了广泛的选择和比较基础。

使用方法

Speech-to-Text Benchmark框架的使用相对简单直观。以下是基本的使用步骤:

-

首先,确保您的系统环境为Ubuntu 22.04(框架在此环境下开发和测试)。

-

安装FFmpeg,这是处理音频文件所必需的工具。

-

下载所需的数据集。

-

安装Python依赖:

pip3 install -r requirements.txt -

根据您要测试的引擎,使用相应的命令行参数运行

benchmark.py脚本。例如,要测试Amazon Transcribe,可以使用以下命令:python3 benchmark.py \ --dataset ${DATASET} \ --dataset-folder ${DATASET_FOLDER} \ --engine AMAZON_TRANSCRIBE \ --aws-profile ${AWS_PROFILE}其中,

${DATASET}可以是COMMON_VOICE、LIBRI_SPEECH_TEST_CLEAN、LIBRI_SPEECH_TEST_OTHER或TED_LIUM中的一个。 -

对于不同的引擎,您可能需要提供相应的API密钥或凭证信息。请参考项目的README文件获取每个引擎的具体指令。

基准测试结果分析

Speech-to-Text Benchmark框架的最新测试结果提供了深入的洞察。让我们来分析一下主要的发现:

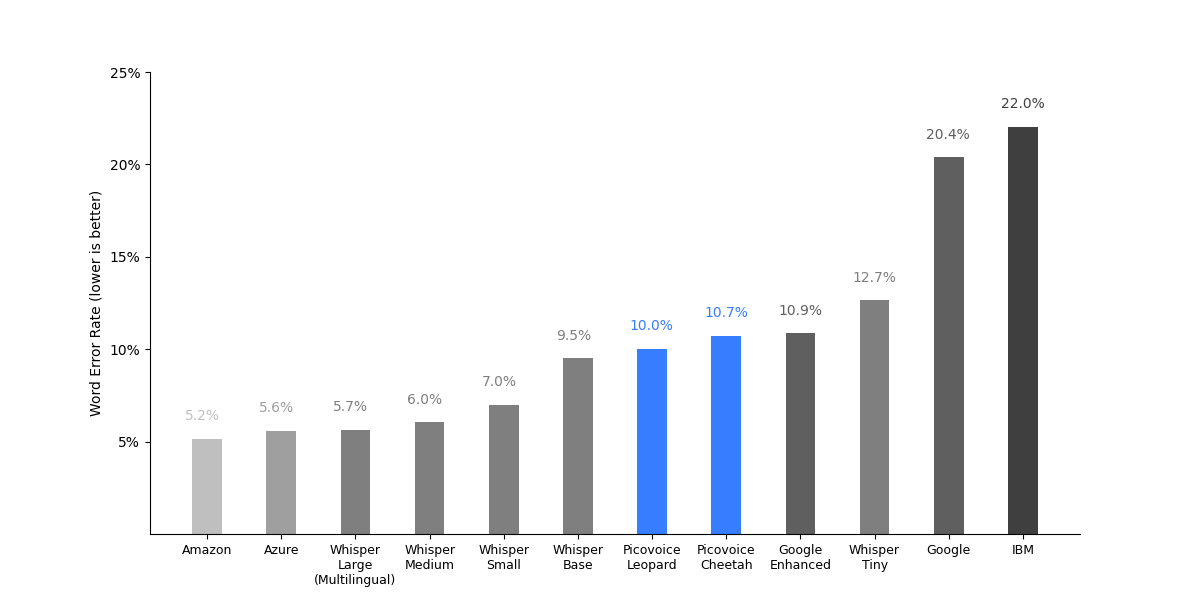

词错误率 (WER) 分析

从词错误率的结果来看:

-

云服务表现优异:Amazon Transcribe和Azure Speech-to-Text在所有测试集上表现出色,平均WER分别为5.2%和5.6%。这表明大型云服务提供商在语音识别技术上的投入正在获得回报。

-

OpenAI Whisper表现亮眼:作为一个开源模型,Whisper Large (多语言版)的表现与顶级云服务不相上下,平均WER为5.7%。这是一个令人印象深刻的成果,显示了开源社区在AI领域的强大实力。

-

Google服务表现不一:Google Speech-to-Text的基础版本表现相对较差(平均WER为20.4%),但其增强版本显著改善(平均WER为10.9%)。这说明高质量的语音识别仍然需要专门的优化和调整。

-

Picovoice的竞争力:Picovoice的Leopard和Cheetah引擎虽然整体表现不如顶级云服务,但在某些数据集上的表现相当不错,平均WER分别为10.0%和10.7%。考虑到这些是本地运行的引擎,这一表现是值得肯定的。

-

数据集难度差异:LibriSpeech test-clean数据集上的表现普遍较好,而CommonVoice数据集上的错误率较高。这反映了不同场景下语音识别的挑战性差异。

计算效率与模型大小

在计算效率和模型大小方面:

-

Whisper模型的权衡:Whisper系列模型展示了性能和资源需求之间的权衡。从Tiny到Medium,随着模型大小的增加,WER降低,但核心小时数也相应增加。

-

Picovoice的效率优势:Picovoice的Leopard和Cheetah模型在核心小时数和模型大小上都表现出色。特别是Leopard,仅需0.05核心小时就能处理1小时的音频,模型大小也只有36MB。这使得它们非常适合资源受限的环境或需要低延迟处理的应用场景。

-

大小与性能的平衡:Whisper Base模型在性能和资源需求之间取得了不错的平衡,提供了合理的WER(9.5%),同时保持较小的模型大小(139MB)和适中的计算需求(0.28核心小时)。

结论与展望

Speech-to-Text Benchmark框架为我们提供了一个客观、全面的语音转文本技术评估平台。通过这个框架,我们可以得出以下结论:

-

云服务的优势:大型云服务提供商在准确性方面仍然保持领先,特别是在处理各种复杂场景时。

-

开源模型的潜力:OpenAI Whisper等开源模型展现出与商业解决方案竞争的潜力,为研究和应用提供了更多可能性。

-

效率与准确性的权衡:本地运行的轻量级模型(如Picovoice的产品)在某些场景下可能更具优势,尤其是在考虑延迟、隐私和离线使用等因素时。

-

持续改进的空间:即使是最佳表现的引擎,在某些数据集上仍有明显的改进空间,这预示着语音识别技术仍有很大的发展潜力。

展望未来,我们可以期待:

- 更多针对特定领域和语言的优化模型

- 结合深度学习和传统语言模型的混合方法

- 更高效的模型压缩和量化技术,以提高本地引擎的性能

- 隐私保护和个性化定制功能的增强

Speech-to-Text Benchmark框架不仅为开发者和研究人员提供了宝贵的评估工具,也为用户选择适合自己需求的语音识别解决方案提供了重要参考。随着技术的不断进步,我们有理由相信语音转文本技术将在准确性、效率和适用性方面继续取得突破,为更广泛的应用场景提供支持。

🔗 相关链接:

通过深入了解这个基准测试框架,我们不仅可以更好地评估现有的语音转文本技术,还能洞察未来的发展趋势。无论您是技术开发者、研究人员还是对语音技术感兴趣的爱好者,Speech-to-Text Benchmark都为您提供了一个valued的参考工具。让我们共同期待语音识别技术的进一步突破和创新!🚀🎙️📝