IncarnaMind: 开创文档交互新纪元

在当今数字时代,有效管理和利用个人文档中的信息变得越来越重要。IncarnaMind应运而生,为用户提供了一种革命性的方式来与个人文档进行交互并提取关键信息。这款创新工具利用先进的自然语言处理技术和独特的数据提取方法,为用户打造了一个智能、高效的个人知识管理平台。

核心技术:滑动窗口与集成检索

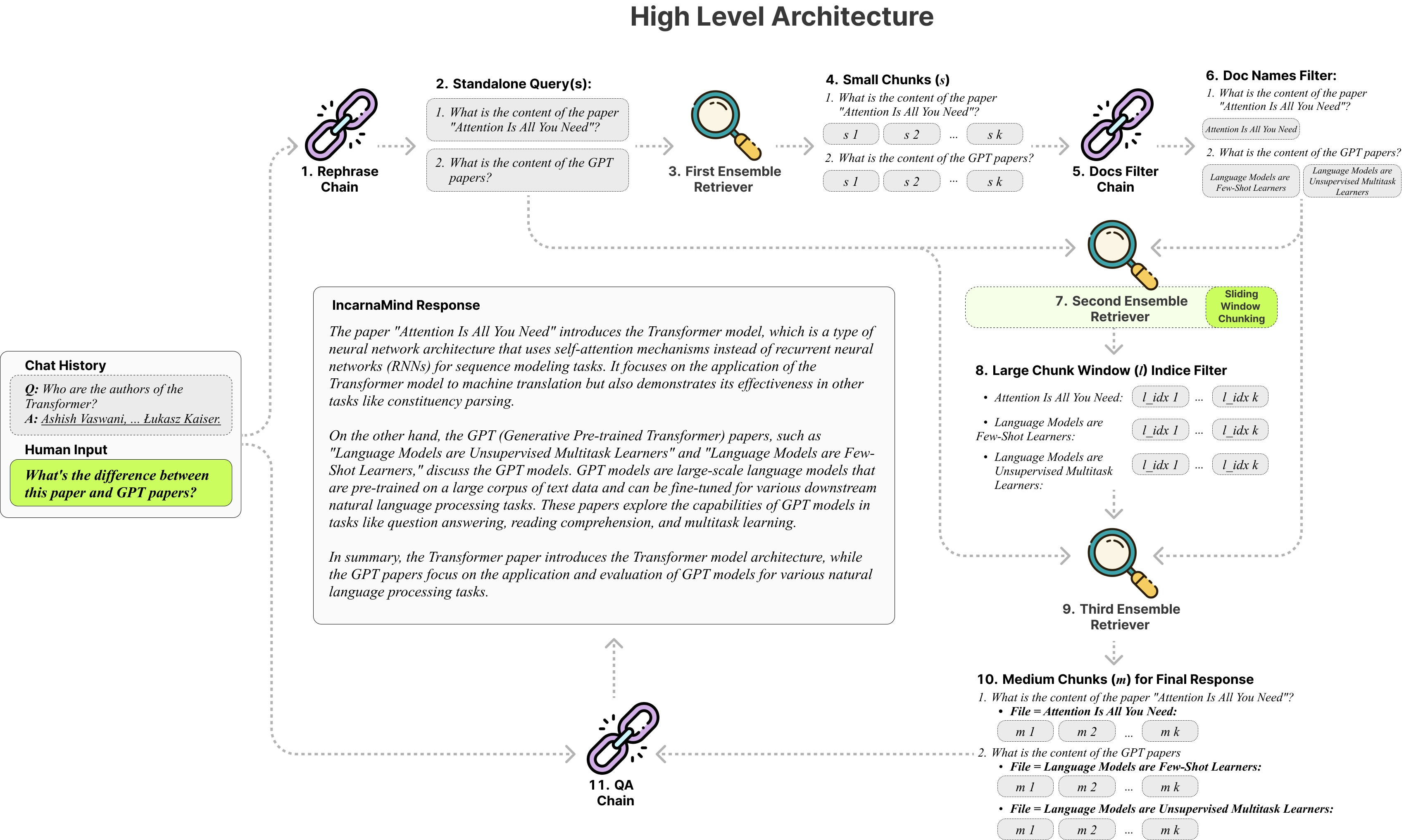

IncarnaMind的核心优势在于其两大关键技术组件:滑动窗口(Sliding Window)和集成检索(Ensemble Retriever)机制。这两项技术的结合大大提升了信息检索的准确性和上下文管理能力,甚至在某些方面超越了OpenAI的GPT模型。

-

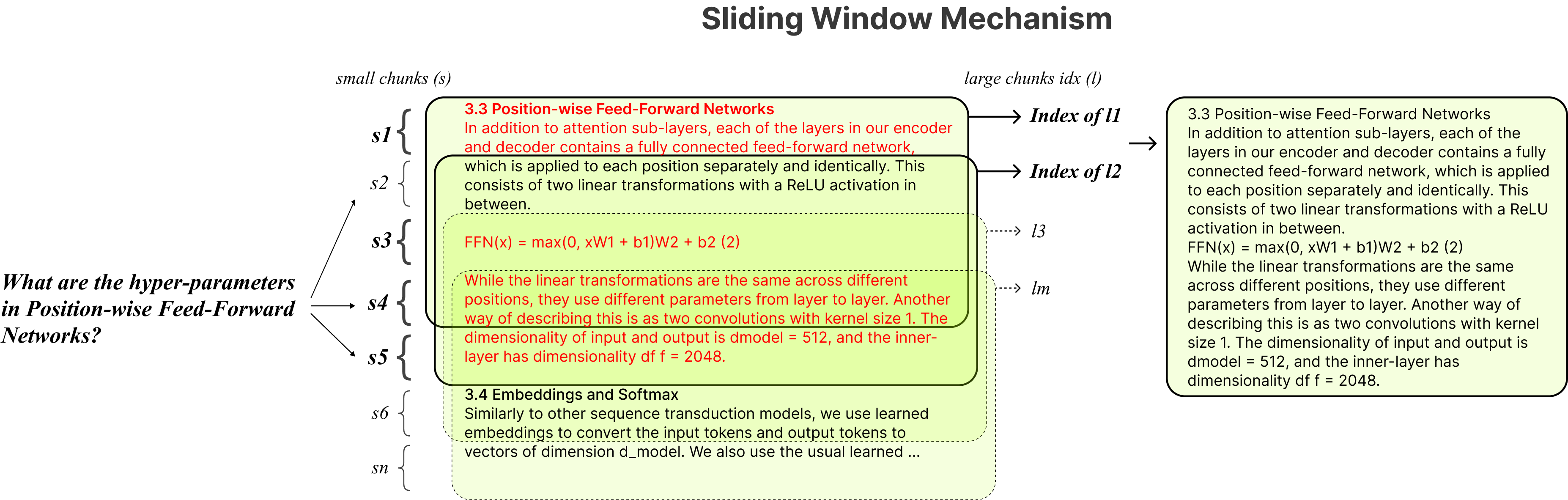

滑动窗口技术 滑动窗口技术是IncarnaMind区别于传统检索增强生成(RAG)方法的关键所在。与固定大小的文本块不同,滑动窗口可以根据信息复杂度和用户查询动态调整其大小和位置。这种灵活性使得系统能够保持全面而富有上下文的信息提取,特别适合处理大型文档。

-

集成检索机制 集成检索机制整合了多种检索策略,以增强查询响应的质量。通过同时过滤用户文档中的"粗粒度"和"细粒度"数据,该机制能够提供精确且相关的信息,有效降低了大型语言模型常见的"幻觉"问题。

多文档交互与兼容性

IncarnaMind的一大亮点是其支持多文档交互。用户可以在一次会话中输入跨越多个文档的查询,这对于需要处理大量文档的研究人员来说尤为重要。当进行特定信息的语义搜索时,这一功能显得尤为强大。

在兼容性方面,IncarnaMind支持多种大型语言模型,包括Llama2系列、Anthropic Claude和OpenAI GPT等。这种广泛的兼容性为用户提供了更多选择,以满足不同的需求和偏好。

性能评估

IncarnaMind团队对多个模型在系统内进行了性能比较测试。结果显示:

- GPT-4展现出卓越的推理能力,但速度适中

- Claude 2.0在推理能力和速度方面表现均衡

- Llama 2系列模型提供了不同程度的安全性,但通常需要大量GPU内存,且处理速度较慢

值得注意的是,IncarnaMind专门针对Llama2-70b-chat模型进行了优化。尽管这个量化版本的模型资源需求较高,但Together.ai API提供了一个可行的替代方案,支持llama2-70b-chat和其他开源模型。

应用前景广阔

IncarnaMind的潜在应用场景十分广泛:

- 学术研究:学生可以快速从大量研究论文中提取关键信息。

- 专业领域:法律从业者能够在冗长的法律文件中迅速定位特定信息。

- 个人管理:普通用户可以轻松管理和组织个人文件。

随着IncarnaMind不断发展和完善其功能,它有望在未来彻底改变我们与数字文档交互和提取洞见的方式。

安装与使用

要开始使用IncarnaMind,用户需要遵循以下步骤:

- 克隆GitHub仓库并进入项目目录

- 创建并激活Conda虚拟环境

- 安装所需依赖

- 配置API密钥(支持OpenAI、Anthropic Claude、Together.ai等)

- 上传并处理文件

- 运行主程序开始交互

详细的安装和使用说明可以在项目的GitHub页面找到。

未来展望

IncarnaMind团队已经规划了一系列令人期待的未来功能:

- 前端用户界面

- 针对小型开源LLM的微调

- OCR支持

- 异步优化

- 支持更多文档格式

这些计划中的功能将进一步提升IncarnaMind的实用性和用户体验。

结语

IncarnaMind代表了人工智能在文档管理和信息提取领域的一次重大突破。通过结合先进的自然语言处理技术和创新的检索机制,它为用户提供了一种前所未有的方式来与个人文档进行交互。无论是学术研究、专业工作还是个人知识管理,IncarnaMind都有潜力成为不可或缺的智能助手。

随着技术的不断发展和完善,我们可以期待IncarnaMind在未来为更多用户带来便利,推动知识管理和信息检索领域的创新。对于那些每天需要处理大量文档和信息的人来说,IncarnaMind无疑是一个值得关注和尝试的强大工具。