Informer2020简介

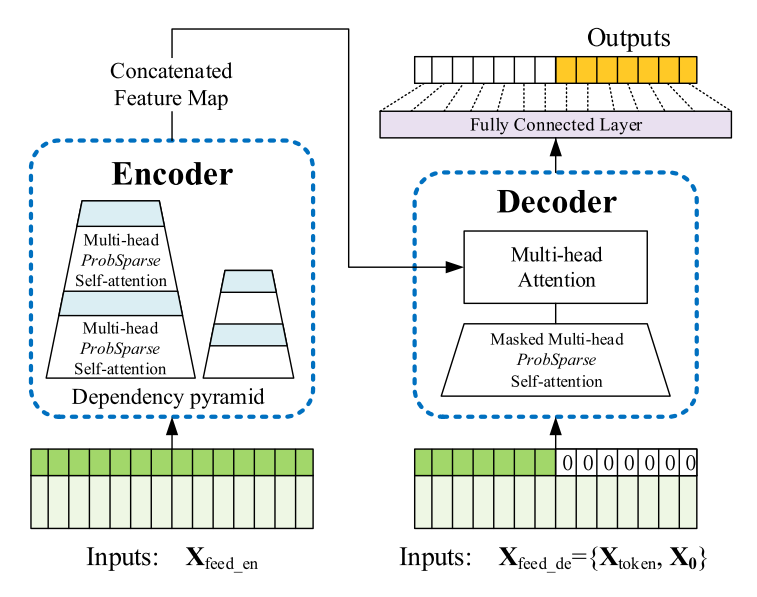

Informer2020是一个用于长序列时间序列预测的高效Transformer模型,由周浩一等人提出,发表于AAAI 2021会议并获得最佳论文奖。该模型通过创新的ProbSparse Attention机制和其他优化设计,大大提高了长序列预测的效率和精度。

项目资源

📚 论文

- Informer: Beyond Efficient Transformer for Long Sequence Time-Series Forecasting - 原始论文

- Expanding the prediction capacity in long sequence time-series forecasting - 扩展论文

💻 代码实现

- GitHub仓库 - 官方PyTorch实现

🗂️ 数据集

- ETDataset - 论文中使用的ETT数据集

- Google Drive - ECL和Weather数据集

- 百度网盘 (密码:6gan) - ECL和Weather数据集备用下载

📊 实验结果

- 实验结果与参数设置 - 包括单变量和多变量预测结果

🧪 复现与使用

模型架构

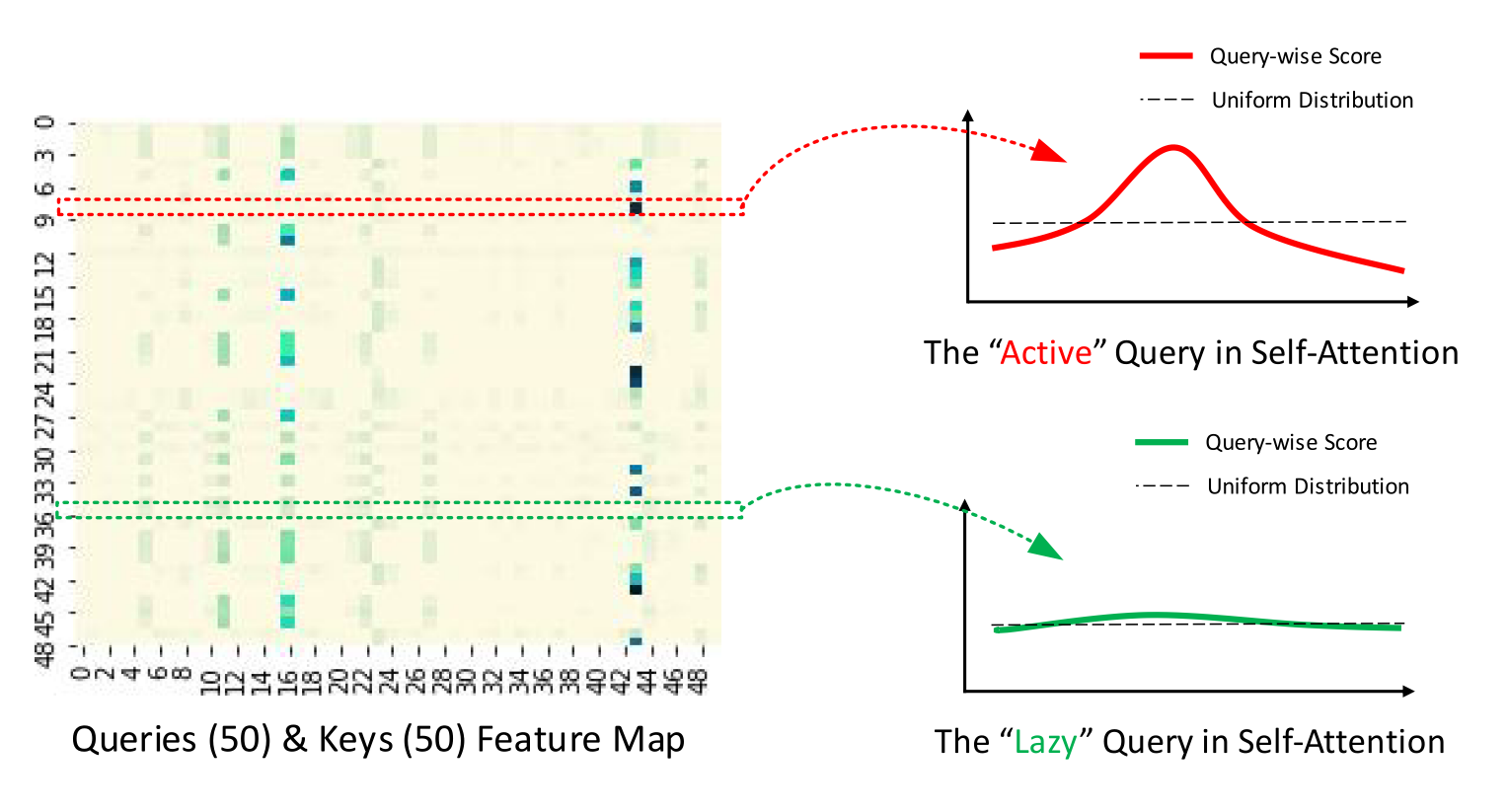

Informer的核心创新在于ProbSparse Attention机制,它通过概率分布选择"活跃"的查询,形成稀疏的Transformer结构。

ProbSparse Attention的工作原理如下图所示:

环境要求

- Python 3.6

- PyTorch 1.8.0

- 其他依赖见 requirements.txt

快速开始

- 克隆仓库:

git clone https://github.com/zhouhaoyi/Informer2020.git

- 安装依赖:

pip install -r requirements.txt

-

下载数据集并放入

data/ETT/文件夹 -

运行训练脚本:

python -u main_informer.py --model informer --data ETTh1 --attn prob --freq h

更多使用说明请参考官方文档。

引用

如果您的研究中使用了Informer,请考虑引用以下论文:

@inproceedings{haoyietal-informer-2021,

author = {Haoyi Zhou and

Shanghang Zhang and

Jieqi Peng and

Shuai Zhang and

Jianxin Li and

Hui Xiong and

Wancai Zhang},

title = {Informer: Beyond Efficient Transformer for Long Sequence Time-Series Forecasting},

booktitle = {The Thirty-Fifth {AAAI} Conference on Artificial Intelligence, {AAAI} 2021, Virtual Conference},

pages = {11106--11115},

publisher = {{AAAI} Press},

year = {2021},

}

希望这份资料汇总能帮助您快速了解和使用Informer2020模型。如有任何问题,欢迎在GitHub Issues中讨论。