InternVideo: 开创视频理解新时代的基础模型

InternVideo: 开创视频理解新时代的基础模型

在人工智能快速发展的今天,计算机视觉领域取得了长足的进步。然而,相比于图像领域的成就,视频理解仍然面临着巨大的挑战。为了推动视频理解技术的发展,上海人工智能实验室(Shanghai AI Lab)推出了InternVideo系列视频基础模型,旨在通过创新的方法实现视频内容的多模态理解。

InternVideo的技术创新

InternVideo采用了生成式和判别式学习相结合的独特方法,充分利用了两种学习范式的优势。具体来说,InternVideo主要基于以下两种自监督学习方法:

-

掩码视频建模(Masked Video Modeling): 这是一种生成式学习方法,模型通过预测被遮挡的视频片段来学习视频的时空表示。

-

视频-语言对比学习(Video-Language Contrastive Learning): 这是一种判别式学习方法,模型通过对齐视频和文本的表示来学习多模态信息。

通过这两种方法的有机结合,InternVideo能够更全面地理解视频内容,包括视觉、动作、语义等多个层面的信息。

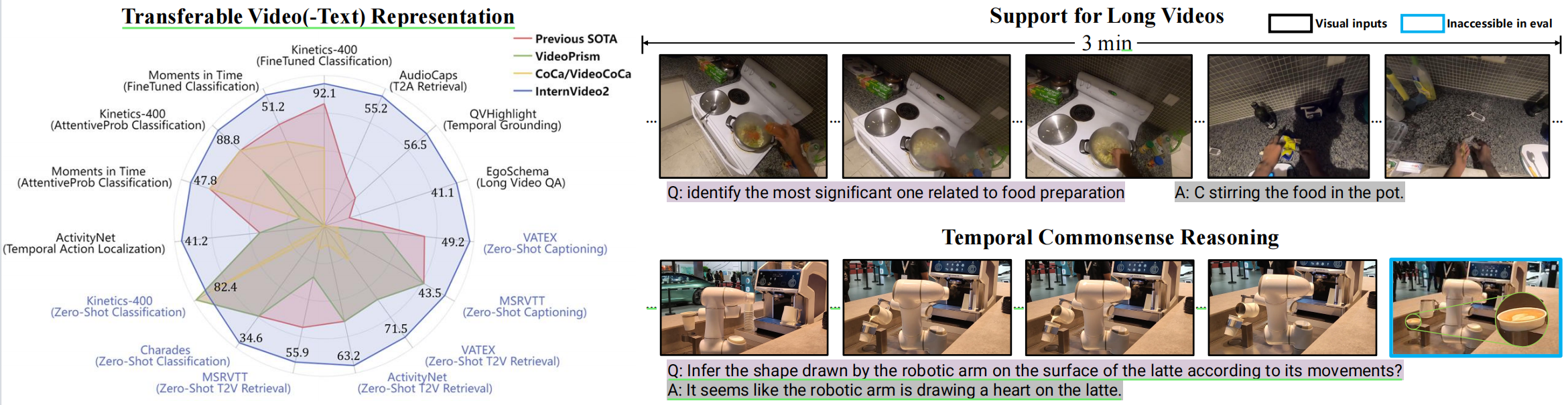

InternVideo的突破性成果

InternVideo在多个视频理解任务上取得了令人瞩目的成绩:

- 在Kinetics-400动作识别基准测试中,InternVideo实现了91.1%的top-1准确率。

- 在Something-Something V2数据集上,InternVideo达到了77.2%的top-1准确率。

- 在39个视频数据集上,InternVideo展现出了优异的泛化能力,涵盖了动作识别、时序动作定位、视频问答等多项任务。

这些成果充分证明了InternVideo作为通用视频基础模型的强大能力。

InternVideo的持续发展

自2022年首次发布以来,InternVideo项目一直在不断发展和完善:

- 2023年7月,研究团队发布了InternVid大规模视频-文本数据集,为多模态视频理解和生成提供了宝贵的资源。

- 2024年3月,InternVideo2的技术报告发布,进一步扩展了模型的规模和能力。

- 2024年8月,研究团队推出了InternVideo2的小型版本(S/B/L),以及基于MobileCLIP的轻量级VideoCLIP模型,使得InternVideo更加易于应用。

InternVideo的开源贡献

InternVideo项目秉承开源精神,为研究社区提供了丰富的资源:

- 模型代码和预训练权重已在GitHub上公开发布。

- InternVid数据集的完整版本(230M视频-文本对)已在OpenDataLab和HuggingFace平台上开放获取。

- 研究团队还发布了视频指令数据,用于微调端到端的视频中心多模态对话系统。

这些开源贡献大大促进了视频理解领域的研究进展。

InternVideo的应用前景

作为一个强大的视频基础模型,InternVideo在多个领域都有广阔的应用前景:

-

智能监控: 利用InternVideo的动作识别和异常检测能力,可以大幅提升安防系统的智能化水平。

-

内容审核: InternVideo可以自动分析和理解视频内容,协助平台更高效地进行内容审核。

-

视频检索: 基于InternVideo的多模态理解能力,可以实现更精准的视频搜索和推荐。

-

人机交互: 结合InternVideo的视频理解能力,可以开发出更智能的人机交互界面。

-

辅助驾驶: InternVideo的实时视频分析能力可以应用于自动驾驶和辅助驾驶系统。

未来展望

尽管InternVideo已经取得了显著的成果,但视频理解领域仍然存在诸多挑战和机遇。未来,研究团队计划从以下几个方面继续推进InternVideo的发展:

- 进一步扩大模型规模,探索更大规模预训练对模型性能的影响。

- 优化模型架构,提高计算效率,使其更适合实际应用场景。

- 加强多模态融合,实现视频、音频、文本等多种模态的深度整合。

- 探索迁移学习方法,使模型能够更好地适应新的任务和领域。

- 研究模型的可解释性,提高AI决策的透明度。

InternVideo的发展无疑将为视频理解领域带来新的机遇和挑战。随着技术的不断进步,我们有理由期待InternVideo能够在更广泛的应用场景中发挥作用,为人工智能的发展做出更大的贡献。

InternVideo项目欢迎更多研究者和开发者的参与。如果您对该项目感兴趣,可以通过GitHub仓库了解更多信息,或加入官方微信群进行交流讨论。让我们共同期待InternVideo为视频理解领域带来的更多突破和创新!

编辑推荐精选

讯飞智文

一键生成PPT和Word,让学习生活更轻松

讯飞智文是一个利用 AI 技术的项目,能够帮助用户生成 PPT 以及各类文档。无论是商业领域的市场分析报告、年度目标制定,还是学生群体的职业生涯规划、实习避坑指南,亦或是活动策划、旅游攻略等内容,它都能提供支持,帮助用户精准表达,轻松呈现各种信息。

讯飞星火

深度推理能力全新升级,全面对标OpenAI o1

科大讯飞的星火大模型,支持语言理解、知识问答和文本创作等多功能,适用于多种文件和业务场景,提升办公和日常生活的效率。讯飞星火是一个提供丰富智能服务的平台,涵盖科技资讯、图像创作、写作辅助、编程解答、科研文献解读等功能,能为不同需求的用户提供便捷高效的帮助,助力用户轻松获取信息、解决问题,满足多样化使用场景。

Spark-TTS

一种基于大语言模型的高效单流解耦语音令牌文本到语音合成模型

Spark-TTS 是一个基于 PyTorch 的开源文本到语音合成项目,由多个知名机构联合参与。该项目提供了高效的 LLM(大语言模型)驱动的语音合成方案,支持语音克隆和语音创建功能,可通过命令行界面(CLI)和 Web UI 两种方式使用。用户可以根据需求调整语音的性别、音高、速度等参数,生成高质量的语音。该项目适用于多种场景,如有声读物制作、智能语音助手开发等。

Trae

字节跳动发布的AI编程神器IDE

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

咔片PPT

AI助力,做PPT更简单!

咔片是一款轻量化在线演示设计工具,借助 AI 技术,实现从内容生成到智能设计的一站式 PPT 制作服务。支持多种文档格式导入生成 PPT,提供海量模板、智能美化、素材替换等功能,适用于销售、教师、学生等各类人群,能高效制作出高品质 PPT,满足不同场景演示需求。

讯飞绘文

选题、配图、成文,一站式创作,让内容运营更高效

讯飞绘文,一个AI集成平台,支持写作、选题、配图、排版和发布。高效生成适用于各类媒体的定制内容,加速品牌传播,提升内容营销效果。

材料星

专业的AI公文写作平台,公文写作神器

AI 材料星,专业的 AI 公文写作辅助平台,为体制内工作人员提供高效的公文写作解决方案。拥有海量公文文库、9 大核心 AI 功能,支持 30 + 文稿类型生成,助力快速完成领导讲话、工作总结、述职报告等材料,提升办公效率,是体制打工人的得力写作神器。

openai-agents-python

OpenAI Agents SDK,助力开发者便捷使用 OpenAI 相关功能。

openai-agents-python 是 OpenAI 推出的一款强大 Python SDK,它为开发者提供了与 OpenAI 模型交互的高效工具,支持工具调用、结果处理、追踪等功能,涵盖多种应用场景,如研究助手、财务研究等,能显著提升开发效率,让开发者更轻松地利用 OpenAI 的技术优势。

Hunyuan3D-2

高分辨率纹理 3D 资产生成

Hunyuan3D-2 是腾讯开发的用于 3D 资产生成的强大工具,支持从文本描述、单张图片或多视角图片生成 3D 模型,具备快速形状生成能力,可生成带纹理的高质量 3D 模型,适用于多个领域,为 3D 创作提供了高效解决方案。

3FS

一个具备存储、管理和客户端操作等多种功能的分布式文件系统相关项目。

3FS 是一个功能强大的分布式文件系统项目,涵盖了存储引擎、元数据管理、客户端工具等多个模块。它支持多种文件操作,如创建文件和目录、设置布局等,同时具备高效的事件循环、节点选择和协程池管理等特性。适用于需要大规模数据存储和管理的场景,能够提高系统的性能和可靠性,是分布式存储领域的优质解决方案。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号