NLP之旅:自然语言处理的学习与探索

自然语言处理(Natural Language Processing, NLP)是人工智能和语言学的交叉领域,致力于让计算机理解、解析、生成人类语言。近年来,随着深度学习技术的发展,NLP取得了突飞猛进的进展,在机器翻译、智能问答、文本分类等众多应用场景中发挥着越来越重要的作用。本文将带您踏上NLP学习之旅,全面了解这一充满魅力的研究领域。

NLP的发展历程

NLP的研究可以追溯到20世纪50年代,最初主要依靠规则和统计方法。随着计算能力的提升和大规模语料库的出现,基于统计的方法在20世纪90年代开始占据主导地位。进入21世纪后,深度学习技术为NLP注入了新的活力,掀起了一场革命。

2013年,word2vec的提出开启了NLP预训练时代。此后,ELMo、BERT等预训练语言模型不断涌现,大幅提升了各项NLP任务的性能。2018年,GPT(Generative Pre-trained Transformer)的出现,进一步推动了大规模语言模型的发展。近年来,以GPT-3为代表的超大规模语言模型展现出了惊人的能力,引发了对AI潜力的新一轮思考。

NLP的核心技术

- 文本预处理

文本预处理是NLP pipeline中的重要一环,包括分词、词性标注、命名实体识别等步骤。常用的工具有NLTK、SpaCy等。以SpaCy为例,它提供了高效的文本处理功能:

import spacy

nlp = spacy.load("en_core_web_sm")

doc = nlp("Apple is looking at buying U.K. startup for $1 billion")

for token in doc:

print(token.text, token.pos_, token.dep_)

- 词嵌入

词嵌入将词语映射到低维稠密向量空间,是深度学习时代NLP的基础。常见的词嵌入模型包括word2vec、GloVe和FastText。以word2vec为例,它通过上下文预测目标词(CBOW)或用目标词预测上下文(Skip-gram)来学习词向量。

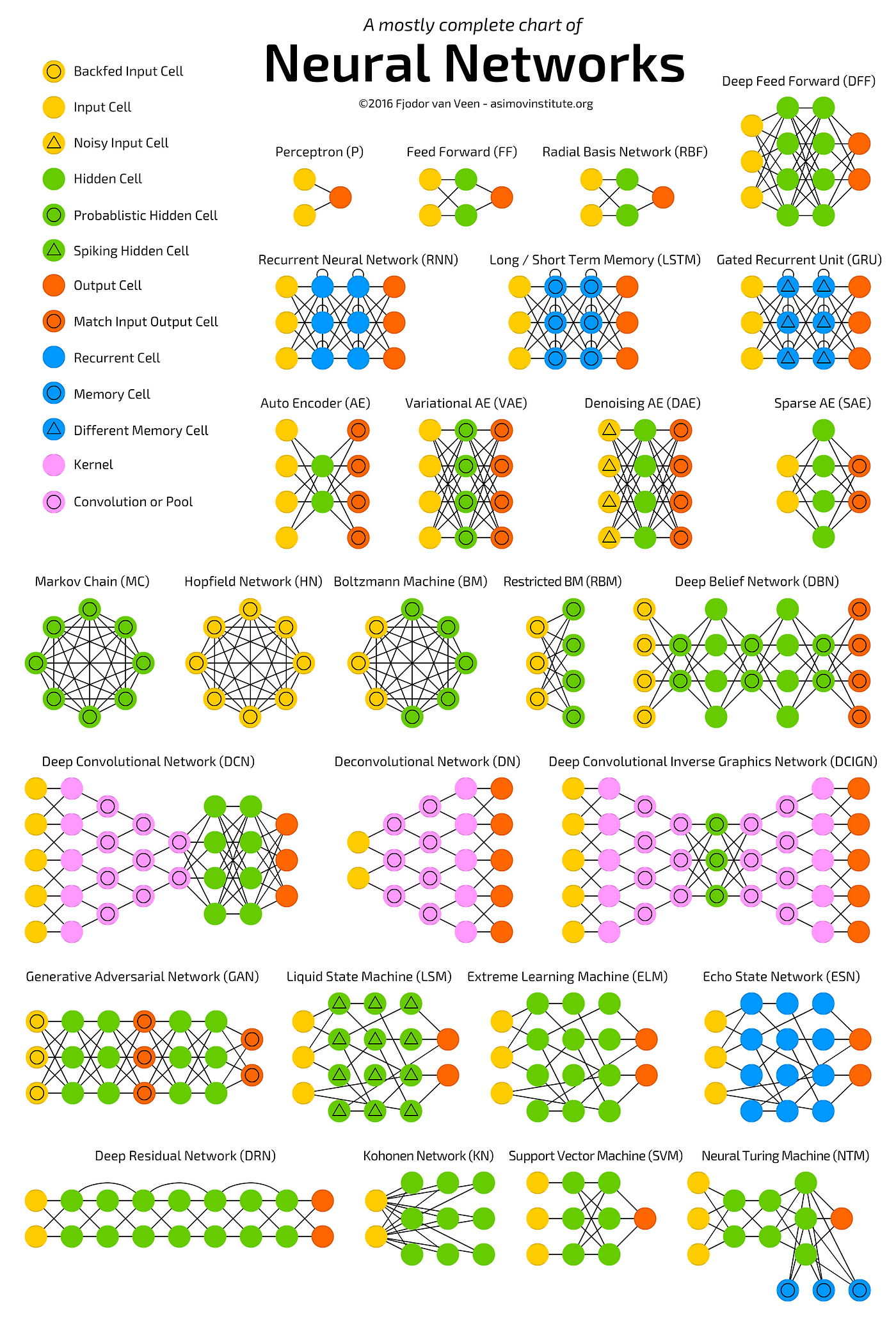

- 序列模型

循环神经网络(RNN)、长短期记忆网络(LSTM)和门控循环单元(GRU)是处理序列数据的经典模型。它们能够捕捉文本中的长距离依赖关系,在机器翻译、文本生成等任务中表现出色。

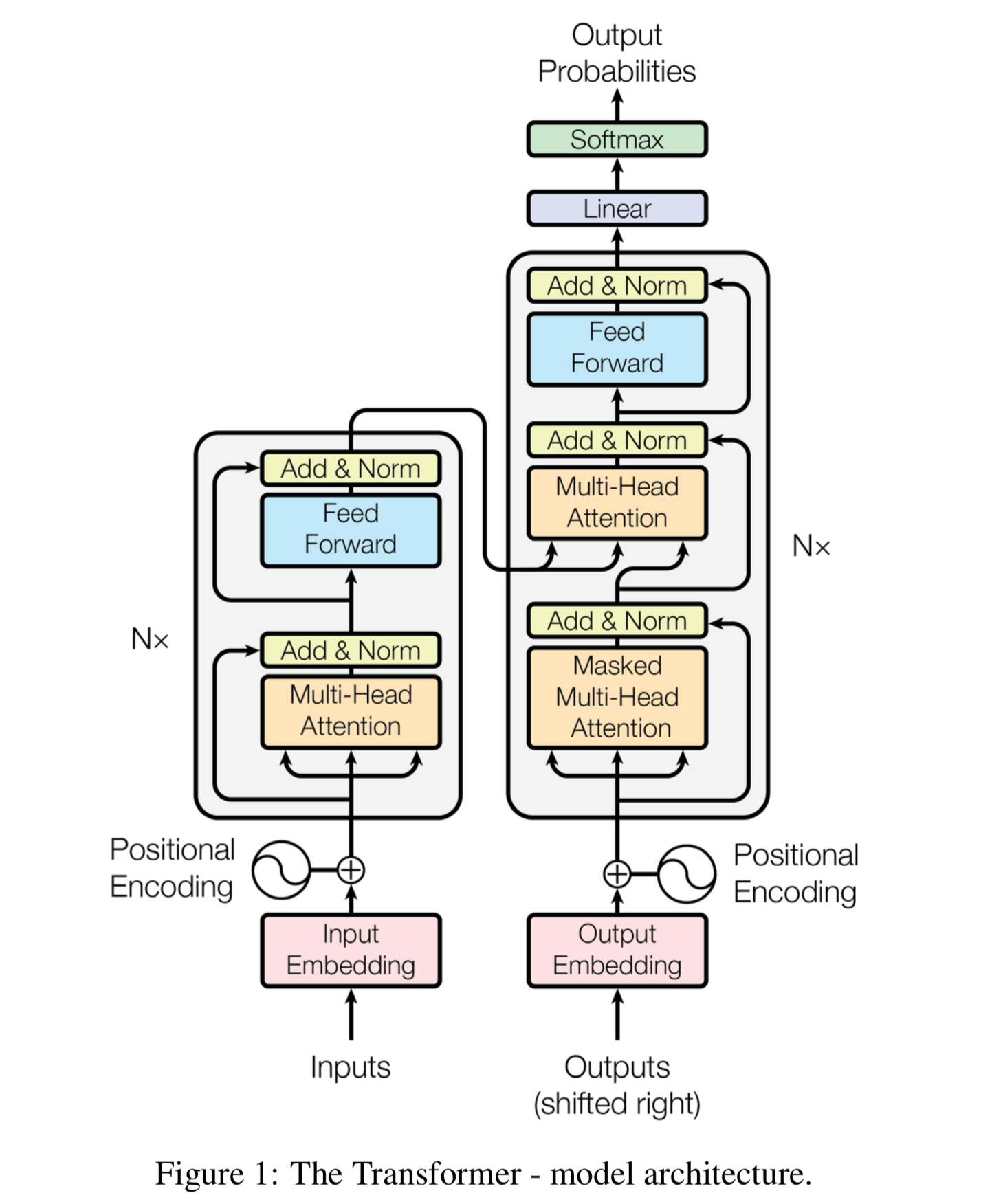

- Transformer架构

2017年提出的Transformer模型彻底改变了NLP领域。它基于自注意力机制,摒弃了传统的循环结构,在并行计算和长距离依赖建模方面具有显著优势。Transformer已成为当前NLP模型的主流架构。

- 预训练语言模型

BERT、GPT等预训练语言模型在海量无标注文本上进行自监督学习,学到了丰富的语言知识。通过在下游任务上微调,这些模型能够快速适应各种NLP任务,大幅提升性能。

NLP的主要应用

- 文本分类

文本分类是NLP的基础任务之一,应用广泛。从情感分析到垃圾邮件检测,再到新闻分类,都属于文本分类的范畴。常用的模型包括FastText、TextCNN和基于BERT的分类器。

- 命名实体识别(NER)

NER旨在识别文本中的实体(如人名、地名、组织名)并将其归类。它是信息抽取的重要组成部分,在问答系统、搜索引擎等场景中有重要应用。目前,基于BERT的NER模型在多个数据集上取得了最优结果。

- 机器翻译

神经机器翻译(NMT)是当前机器翻译的主流方法。基于Transformer的模型(如Google的T5)在翻译质量上已接近人类水平。此外,多语言翻译模型的发展也使得低资源语言的翻译成为可能。

- 问答系统

问答系统分为开放域问答和封闭域问答。近年来,基于大规模语言模型的问答系统(如OpenAI的ChatGPT)展现出了惊人的能力,能够理解复杂问题并给出连贯、合理的回答。

- 文本生成

文本生成涵盖了摘要生成、对话生成、故事生成等多个方向。GPT系列模型在文本生成方面表现出色,能够生成流畅、连贯的长文本。不过,如何控制生成内容的真实性和一致性仍是一个挑战。

NLP的未来展望

- 大规模语言模型的持续发展

随着GPT-3等模型的成功,更大规模的语言模型必将出现。这些模型不仅在规模上更大,还将在架构、训练方法和应用范围上有所创新。

- 多模态学习

将文本与图像、音频等其他模态信息结合,实现跨模态理解和生成,是NLP未来的重要方向。如DALL-E、Stable Diffusion等模型已展示了文本到图像生成的强大能力。

- 低资源语言处理

为了使NLP技术惠及更多人群,研究者们正致力于改进低资源语言的处理技术。跨语言迁移学习、多语言预训练等方法将在这一领域发挥重要作用。

- 可解释性和伦理问题

随着NLP模型变得越来越复杂,如何解释模型的决策过程,以及如何确保模型的公平性和伦理性,成为了亟待解决的问题。这不仅涉及技术层面,还需要制定相应的政策和规范。

- 与其他学科的交叉融合

NLP正在与认知科学、脑科学等学科深度融合,以期从人类语言认知的角度改进现有模型。此外,NLP技术也在医疗、法律、金融等垂直领域找到了广泛应用。

结语

NLP是一个充满挑战和机遇的领域。从最初的规则方法到统计方法,再到如今的深度学习方法,NLP技术在不断进步。然而,要真正实现类人的语言理解和生成能力,我们还有很长的路要走。希望本文能为您的NLP学习之旅提供一些指引,激发您对这一领域的兴趣和探索欲望。

让我们共同期待NLP的美好未来,一起为推动人工智能的发展贡献力量。