Lilac:为大语言模型打造更优质的数据

在人工智能和机器学习领域,数据的质量对模型的表现至关重要。为了帮助研究人员和开发者更好地管理和提升训练数据的质量,Lilac应运而生。这个开源工具为大语言模型(LLM)的数据准备工作提供了全面的解决方案。

什么是Lilac?

Lilac是一个功能强大的数据集探索、管理和质量控制工具,专为LLM的训练、微调和监控而设计。它由Lilac AI公司开发,目前已被Cohere和Databricks等知名公司采用,用于可视化、量化和改进预训练及微调数据的质量。

Lilac的一大特色是它可以在本地设备上运行,使用开源LLM,并提供直观的用户界面和Python API。这意味着用户可以在保护数据隐私的同时,灵活地进行各种数据处理操作。

Lilac的主要功能

-

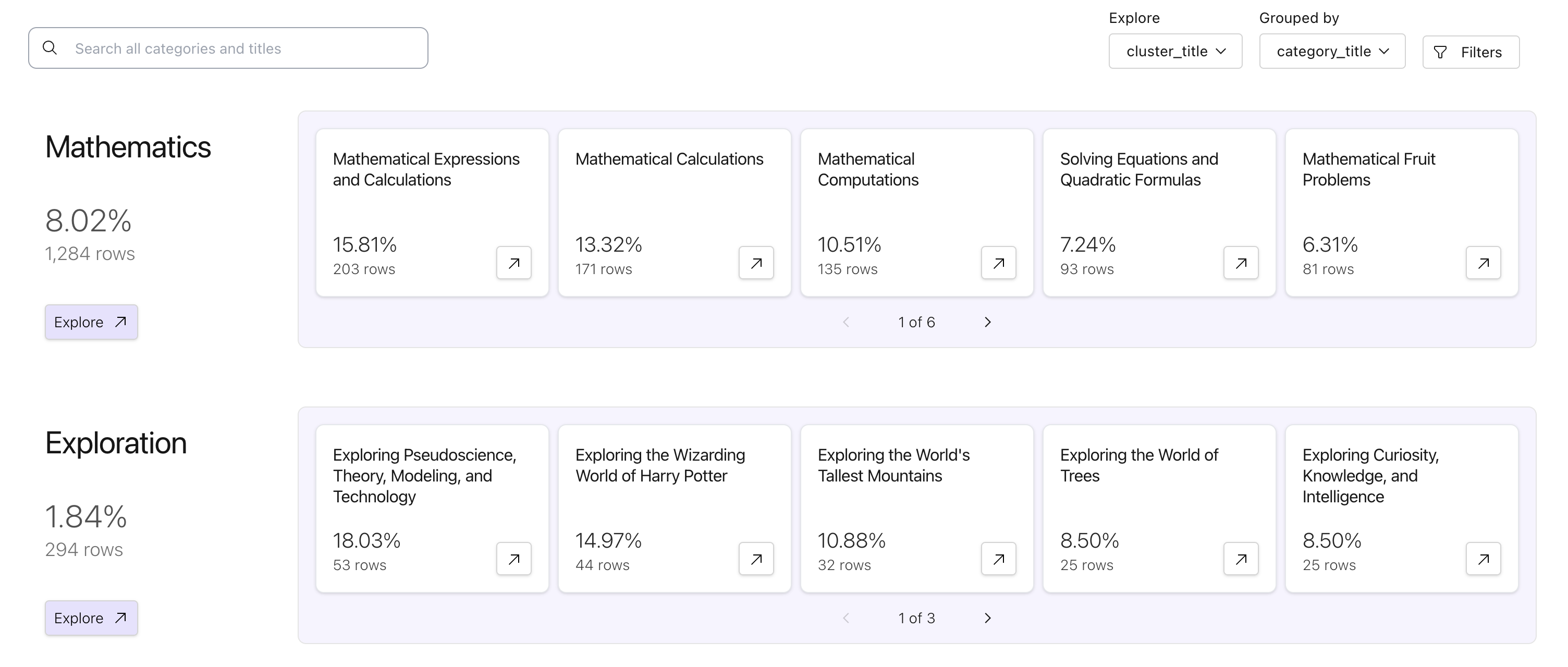

数据探索: Lilac提供了交互式的数据探索功能,用户可以使用LLM驱动的搜索、过滤、聚类和注释等功能来深入了解数据集。

-

数据清理: 工具内置了多种最佳实践,如去重、移除个人身份信息(PII)和模糊内容等,有助于减小数据集规模,降低训练成本和时间。

-

协作功能: 团队成员可以在一个集中的数据集上进行检查和协作,从而提高数据质量。

-

数据变化跟踪: Lilac能够帮助用户了解数据随时间的变化情况。

-

数据处理加速: 通过Lilac Garden(该公司的托管平台),用户可以将计算密集型任务卸载到云端,大幅提升处理速度。

如何使用Lilac?

-

安装: 用户可以通过pip安装Lilac:

pip install lilac-ai -

启动服务器: 使用Python代码启动Lilac服务器:

import lilac as ll ll.start_server(project_dir='~/my_project') -

加载数据: Lilac支持从多种来源加载数据,如HuggingFace、Parquet、CSV、JSON等:

dataset = ll.from_huggingface('imdb') -

数据探索与分析: 用户可以通过Web界面或Python API进行数据探索、聚类分析等操作:

dataset.cluster('text') -

信号计算: Lilac提供多种内置信号,如语言检测、PII识别、文本统计等:

dataset.compute_signal(ll.LangDetectionSignal(), 'text') -

语义搜索: 通过计算嵌入向量,Lilac支持语义搜索功能:

dataset.compute_embedding('gte-small', path='text') -

数据标注: 用户可以为数据点或数据切片添加标签,便于后续处理:

dataset.add_labels( 'short', filters=[ (('text', 'text_statistics', 'num_characters'), 'less', 1000) ] )

Lilac的优势

-

开源透明: 作为开源项目,Lilac的代码完全公开,用户可以审查和贡献代码。

-

隐私保护: 支持本地运行,保护敏感数据。

-

灵活性: 提供Web UI和Python API,适应不同使用场景。

-

强大的分析能力: 集成了多种先进的数据分析和处理技术。

-

社区支持: 活跃的开发者社区,持续改进和更新。

未来展望

随着AI技术的快速发展,数据质量的重要性愈发凸显。Lilac作为一个专注于改善LLM训练数据质量的工具,有望在未来发挥更大作用。该团队计划进一步优化性能,增加更多功能,并加强与其他AI开发工具的集成。

对于那些致力于提升AI模型性能的研究者和开发者来说,Lilac无疑是一个值得关注和尝试的工具。通过更好地理解和管理训练数据,我们可以为构建更强大、更可靠的AI系统奠定坚实基础。

🔗 相关链接:

无论你是AI研究人员、数据科学家还是机器学习工程师,Lilac都可能成为你工作流程中不可或缺的一部分。随着数据质量在AI发展中的重要性日益凸显,像Lilac这样的工具将在塑造AI的未来方面发挥关键作用。