llama2-webui:本地部署Llama 2大语言模型的开源Web UI

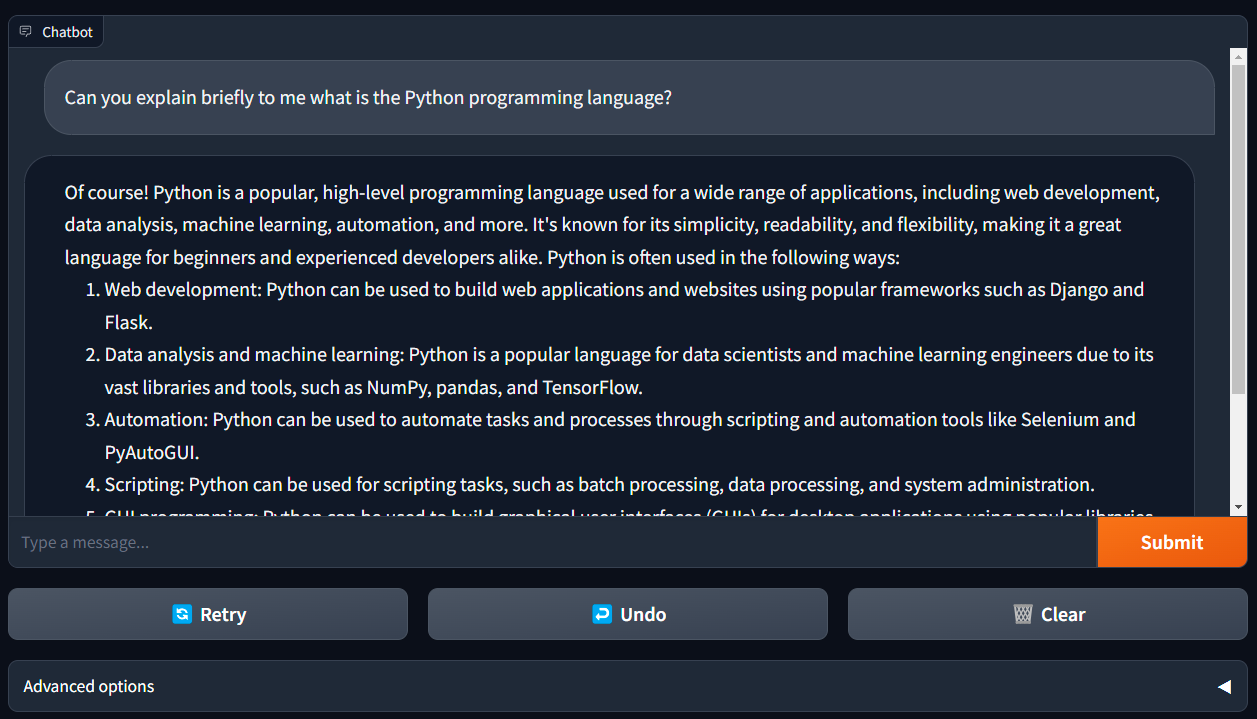

llama2-webui是一个功能强大的开源项目,允许用户在本地GPU或CPU上运行Llama 2大语言模型,并提供友好的Web用户界面。无论您使用Linux、Windows还是Mac,都可以轻松部署和使用这个工具。本文将全面介绍llama2-webui的主要特性、安装使用方法、性能测试等关键信息,帮助您快速掌握这一实用工具。

1. 核心特性

- 支持所有Llama 2模型(7B、13B、70B),以及GPTQ、GGML、GGUF等量化版本

- 支持8位和4位模式,可大幅降低硬件要求

- 提供llama2-wrapper作为本地后端,方便开发生成式AI应用

- 支持运行OpenAI兼容的API

- 提供代码补全UI,支持Code Llama等代码模型

2. 安装使用

llama2-webui提供两种安装方式:

方法1: 通过PyPI安装

pip install llama2-wrapper

方法2: 从源码安装

git clone https://github.com/liltom-eth/llama2-webui.git

cd llama2-webui

pip install -r requirements.txt

安装完成后,可以通过以下命令启动Web UI:

python app.py

这将加载默认配置,使用llama.cpp后端运行llama-2-7b-chat模型。您也可以自定义.env文件中的MODEL_PATH和BACKEND_TYPE等参数。

3. 性能测试

llama2-webui在不同硬件上的性能表现:

| 模型 | 精度 | 设备 | VRAM使用 | 速度(tokens/s) | 加载时间(s) |

|---|---|---|---|---|---|

| Llama-2-7b-Chat-GPTQ | 4-bit | NVIDIA RTX 2080 Ti | 5.8 GB | 18.85 | 192.91 |

| Llama-2-7b-chat-hf | 8-bit | NVIDIA RTX 2080 Ti | 7.7 GB | 3.76 | 641.36 |

| llama-2-7b-chat.ggmlv3.q4_0 | 4-bit | Apple M1 Pro CPU | 5.4 GB RAM | 17.90 | 0.18 |

完整的性能测试数据可查看性能文档。

4. 模型下载

llama2-webui支持多种Llama 2模型,您可以从Hugging Face下载所需模型:

5. 高级使用技巧

- 在多GPU设置下,模型会自动分配到多个GPU上

- 可设置LOAD_IN_8BIT为True以减少内存使用

- 支持Mac Metal加速和AMD/NVIDIA GPU加速

- 提供OpenAI兼容API,方便集成到现有项目中

llama2-webui为本地部署和使用Llama 2大语言模型提供了简单易用的解决方案。无论您是AI研究人员、开发者还是对大语言模型感兴趣的爱好者,都可以利用这个强大的工具在本地探索Llama 2的潜力。欢迎访问项目GitHub仓库了解更多信息,并为这个开源项目做出贡献!