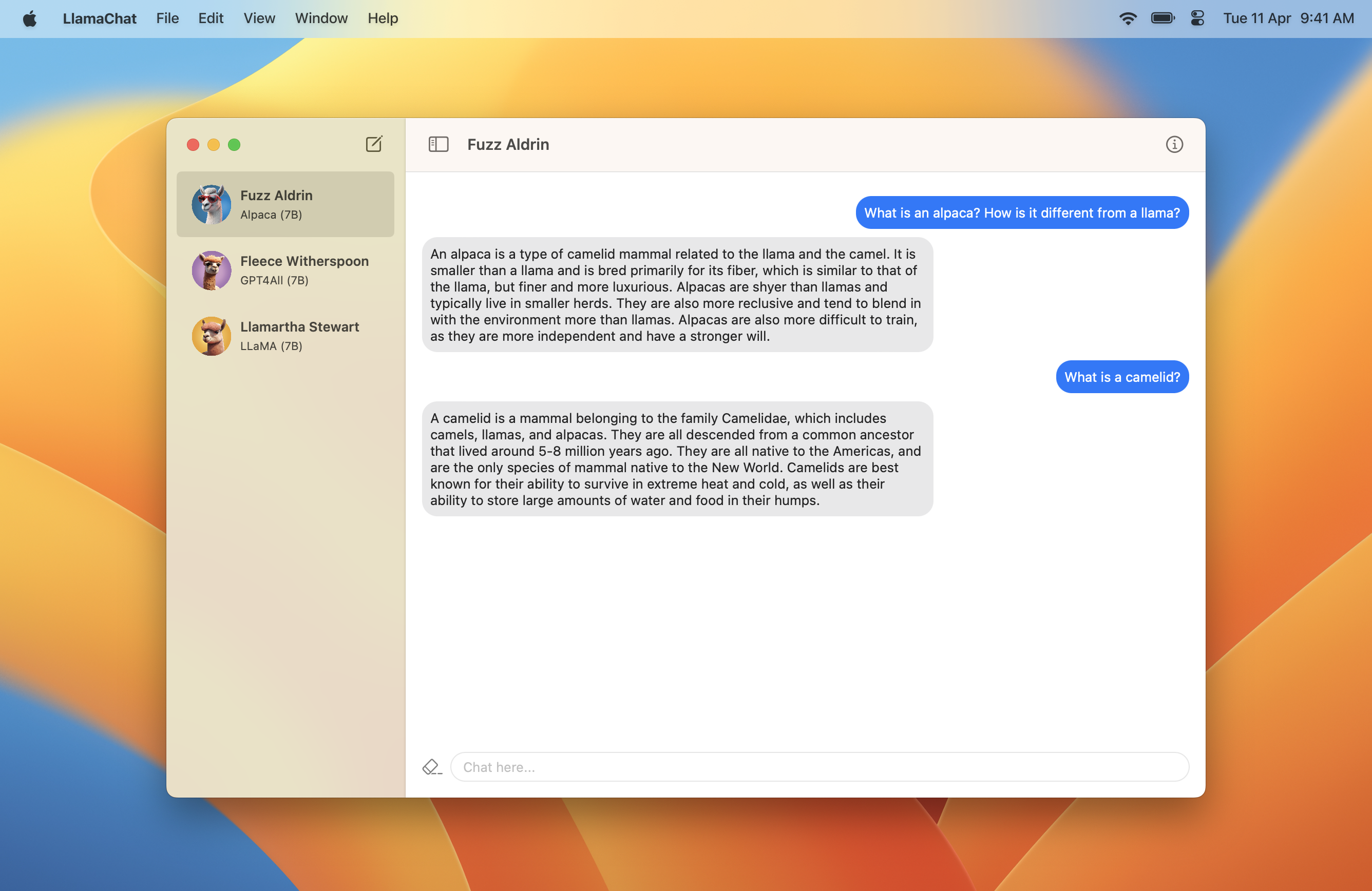

LlamaChat:让AI对话在Mac上轻松实现

在人工智能和自然语言处理技术飞速发展的今天,与先进的语言模型进行对话已经成为许多人探索AI前沿的重要方式。然而,运行这些复杂的模型往往需要强大的硬件和专业的技术知识,这为普通用户设置了不小的门槛。LlamaChat应运而生,它是一款专为macOS设计的原生应用程序,旨在让Mac用户能够轻松地在本地与各种大型语言模型进行交互。

强大而简洁的功能

LlamaChat支持多种流行的大型语言模型,包括Facebook AI Research开发的LLaMA、Stanford大学的Alpaca,以及社区驱动的GPT4All等。用户可以直接在应用中导入这些模型,无需复杂的配置过程。LlamaChat提供了直观的聊天界面,让与AI模型的对话变得如同与朋友聊天一般自然。

除了基本的聊天功能,LlamaChat还提供了一些独特的特性:

-

灵活的模型格式支持: 应用支持原始的PyTorch检查点(.pth)文件和优化后的.ggml格式,为用户提供了更多选择。

-

内置模型转换: 对于原始的PyTorch检查点,LlamaChat可以直接在应用内将其转换为兼容的.ggml文件,简化了用户的操作流程。

-

聊天历史记录: 所有的对话历史都会被保存,方便用户回顾和继续之前的讨论。

-

趣味化头像: 应用内置了7个独特的头像,为不同的聊天源增添了个性。

-

智能命名: LlamaChat使用特殊算法为聊天源生成有趣的名称,增加了使用的乐趣。

-

上下文调试: 对于机器学习爱好者,应用提供了查看当前模型上下文的功能,有助于深入理解模型的工作原理。

便捷的使用体验

LlamaChat的安装和使用非常简单。用户可以直接从官方网站下载DMG安装包,或者通过GitHub仓库克隆源代码自行编译。应用要求macOS 13 Ventura及以上版本,同时支持Intel和Apple Silicon处理器。

对于想要从源码编译的用户,LlamaChat的开发者提供了详细的指南:

git clone https://github.com/alexrozanski/LlamaChat.git

cd LlamaChat

open LlamaChat.xcodeproj

值得注意的是,LlamaChat使用Sparkle框架实现自动更新功能,因此在编译时需要使用有效的签名证书。同时,为了获得最佳的性能,建议在Xcode中将构建配置设置为"Release"模式。

模型使用指南

LlamaChat本身不提供任何模型文件,用户需要自行获取所需的模型。应用支持两种主要的模型格式:

- 原始的Python检查点(.pth)文件

- 预转换的.ggml文件

对于LLaMA模型,用户需要选择适当的参数大小目录(如7B、13B等),并确保父目录中包含tokenizer.model文件。如果使用.ggml文件遇到问题,可能需要使用llama.cpp项目提供的转换脚本进行更新。

开源与社区贡献

LlamaChat是一个开源项目,欢迎社区成员通过Pull Requests和Issues参与贡献。项目完全使用Swift和SwiftUI构建,并采用MVVM架构,大量使用了Combine和Swift Concurrency特性。

开发者Alex Rozanski在GitHub仓库中提供了详细的贡献指南和行为准则,确保项目能够在一个友好、包容的环境中持续发展。

未来展望

LlamaChat团队正在积极开发新功能,包括对Vicuna和Koala等其他模型的支持。他们也在寻找中文和法语使用者来帮助添加对Chinese LLaMA/Alpaca和Vigogne模型的支持,这将进一步扩大应用的语言覆盖范围。

结语

LlamaChat为Mac用户提供了一个便捷、强大的工具,让他们能够轻松探索大型语言模型的魅力。无论是AI爱好者、研究人员还是普通用户,都能在这个应用中找到与先进AI模型对话的乐趣。随着更多功能的加入和社区的不断贡献,LlamaChat有望成为macOS平台上最受欢迎的AI聊天应用之一。

如果您对人工智能和自然语言处理感兴趣,不妨下载LlamaChat,开始您的AI对话之旅。您可以在官方网站或GitHub仓库了解更多信息,并加入这个充满活力的开源社区。让我们一起探索AI的无限可能吧! 🚀🤖💬