LlamaGPT简介 🦙

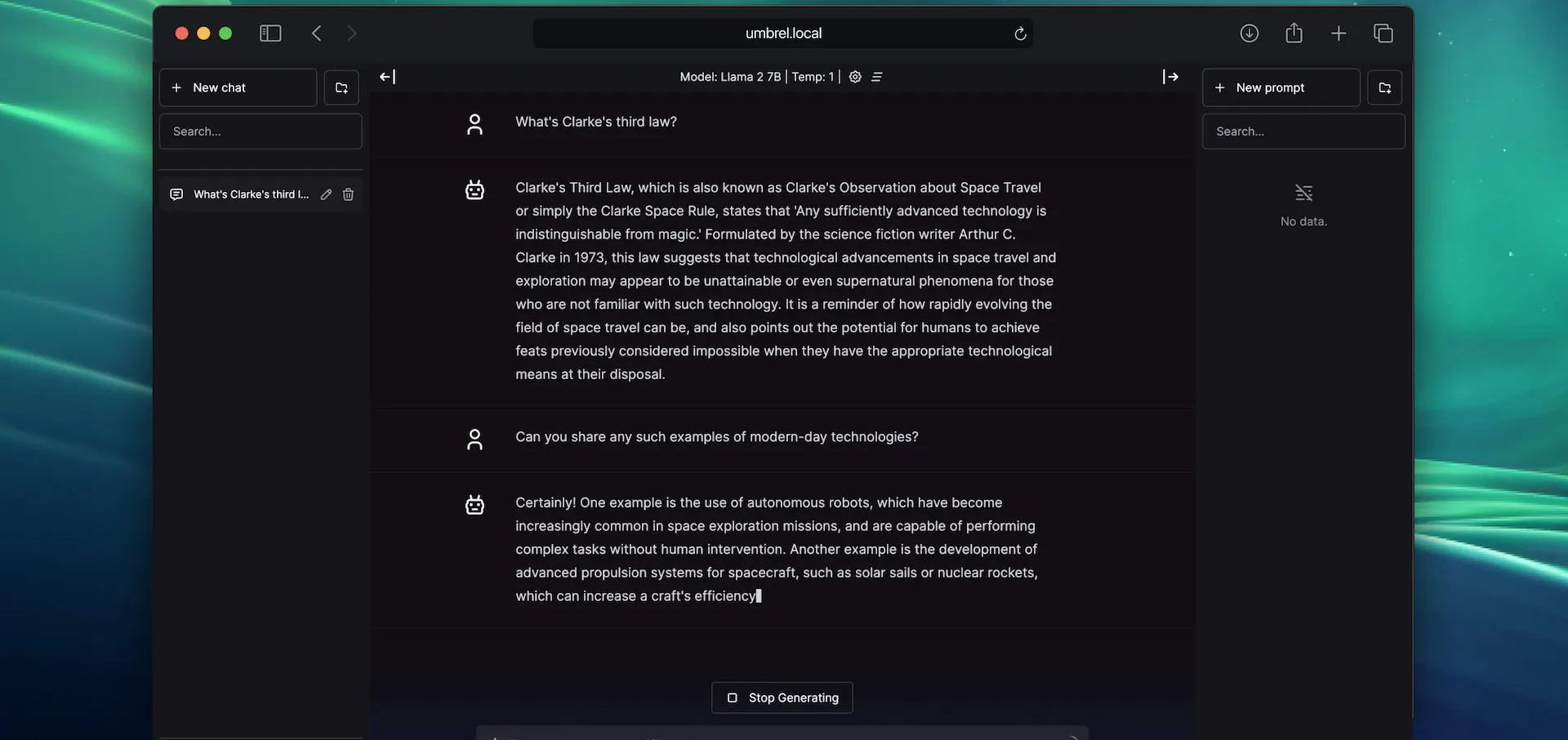

LlamaGPT是一个强大的自托管聊天机器人,类似于ChatGPT,但完全离线运行,确保100%的隐私。它由Llama 2模型驱动,是一个完全开源的项目。

主要特点

- 🏠 自托管:在自己的硬件上运行,完全掌控

- 🔒 离线运行:数据不会离开您的设备

- 🧠 基于Llama 2:强大的语言模型支持

- 💻 支持Code Llama模型:适合编程任务

- 🖥️ 支持NVIDIA GPU:提高性能

安装指南

在umbrelOS家庭服务器上安装

LlamaGPT是umbrelOS的官方应用之一。只需在Umbrel应用商店中一键安装即可。

在Mac上安装

- 确保已安装Docker和Xcode

- 克隆仓库并进入目录:

git clone https://github.com/getumbrel/llama-gpt.git

cd llama-gpt

- 运行以下命令启动LlamaGPT:

./run-mac.sh --model 7b

使用Docker在其他系统上安装

- 确保已安装Docker

- 克隆仓库并进入目录

- 运行以下命令:

./run.sh --model 7b

对于NVIDIA GPU,可以添加--with-cuda标志启用CUDA支持。

支持的模型

LlamaGPT目前支持以下几种模型:

- Nous Hermes Llama 2 (7B/13B/70B)

- Code Llama (7B/13B)

- Phind Code Llama (34B)

使用说明

安装完成后,访问http://localhost:3000即可使用LlamaGPT。

首次运行时,系统会自动下载并加载模型,这可能需要一些时间。加载完成后,您就可以开始与LlamaGPT对话了!

性能基准

LlamaGPT在不同硬件上的性能各不相同。以下是一些基准测试结果:

- M1 Max MacBook Pro (64GB RAM): 54 tokens/sec

- Umbrel Home (16GB RAM): 2.7 tokens/sec

- Raspberry Pi 4 (8GB RAM): 0.9 tokens/sec

贡献与路线图

LlamaGPT是一个活跃的开源项目,欢迎贡献。未来计划包括:

- 支持自定义模型

- 改进Mac上的Metal支持

- 优化NVIDIA GPU支持

如果您想参与开发,可以查看GitHub仓库上的issues。

结语

LlamaGPT为那些寻求私密、自托管AI聊天解决方案的用户提供了一个强大的选择。虽然它可能不会立即取代ChatGPT,但它代表了AI技术向更加开放和去中心化方向发展的重要一步。

无论您是AI爱好者、开发者,还是只是对隐私保护感兴趣,LlamaGPT都值得一试。开始您的自托管AI之旅吧! 🚀