LLM.swift: 让本地大语言模型交互变得简单

LLM.swift是一个简单易用的Swift库,允许开发者在Apple各平台上轻松与大型语言模型进行本地交互。无论是在macOS、iOS、watchOS、tvOS还是最新的visionOS上,LLM.swift都能让你轻松地将大语言模型的能力整合到你的应用中。

主要特点

- 轻量级设计:整个库只有一个文件,易于集成和定制

- 高性能:基于高效的llama.cpp实现

- 跨平台支持:适用于Apple全系列设备

- 灵活的模型加载:支持本地模型文件和HuggingFace模型

- 简洁的API:易于使用的接口设计

快速上手

使用LLM.swift非常简单。以下是两个最基本的使用示例:

- 使用本地模型文件:

let bot = LLM(from: Bundle.main.url(forResource: "mistral-7b-instruct-v0.2.Q4_K_M", withExtension: "gguf")!, template: .mistral)

let question = bot.preprocess("What's the meaning of life?", [])

let answer = await bot.getCompletion(from: question)

print(answer)

- 使用HuggingFace模型:

let systemPrompt = "You are a sentient AI with emotions."

let bot = await LLM(from: HuggingFaceModel("TheBloke/TinyLlama-1.1B-Chat-v1.0-GGUF", .Q2_K, template: .chatML(systemPrompt)))

let question = bot.preprocess("What's the meaning of life?", [])

let answer = await bot.getCompletion(from: question)

print(answer)

深入了解

LLM.swift的核心是LLM类,它提供了与语言模型交互的主要接口。该类包含一些关键属性和方法:

history: 存储对话历史preprocess: 预处理用户输入postprocess: 后处理模型输出update: 处理模型输出的增量更新respond: 响应用户输入的主要方法

开发者可以通过继承LLM类并重写这些方法来自定义行为。例如,你可以定制preprocess方法来适应不同的聊天模板格式。

性能优化

为了在移动设备上获得最佳性能,LLM.swift提供了一些建议:

- 调整

maxTokenCount参数:根据设备性能和需求平衡内存使用和计算量。 - 选择适当的模型大小:对于移动设备,推荐使用3B及以上参数的模型。

- 使用合适的量化版本:如Q4_K_M或Q2_K,以平衡模型大小和质量。

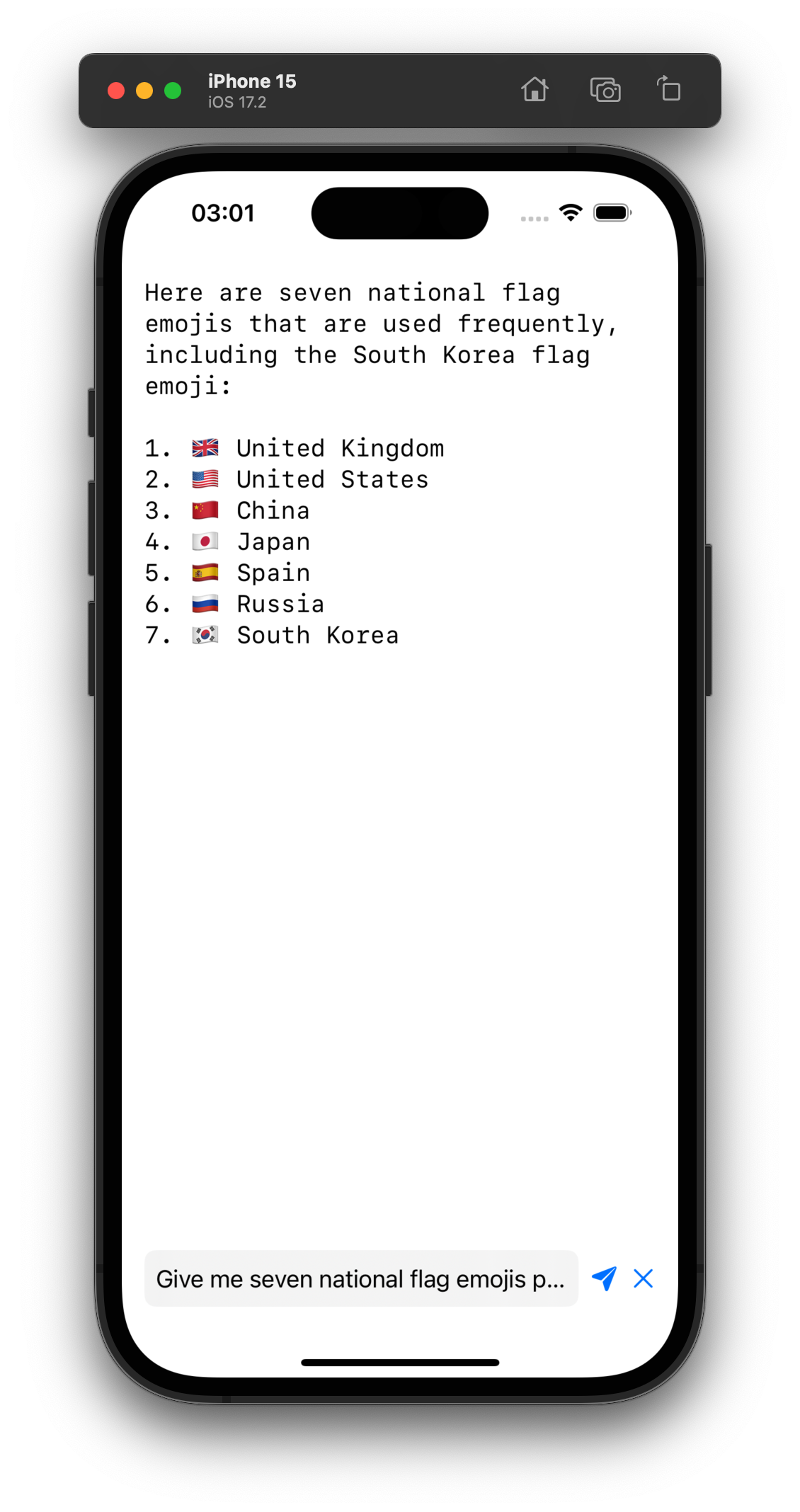

示例应用

LLM.swift还提供了一个简单的SwiftUI示例应用,展示了如何在iOS应用中集成和使用该库。这个示例包括一个聊天界面,允许用户与AI助手进行对话。

结语

LLM.swift为Apple平台开发者提供了一个强大而简单的工具,使他们能够轻松地将大语言模型的能力整合到自己的应用中。无论你是想开发一个智能聊天机器人,还是想为你的应用添加自然语言处理能力,LLM.swift都是一个值得考虑的选择。

随着人工智能和机器学习技术的不断发展,像LLM.swift这样的工具将在未来扮演越来越重要的角色,帮助开发者创造出更智能、更自然的用户体验。我们期待看到更多基于LLM.swift的创新应用出现!