LLMCompiler简介

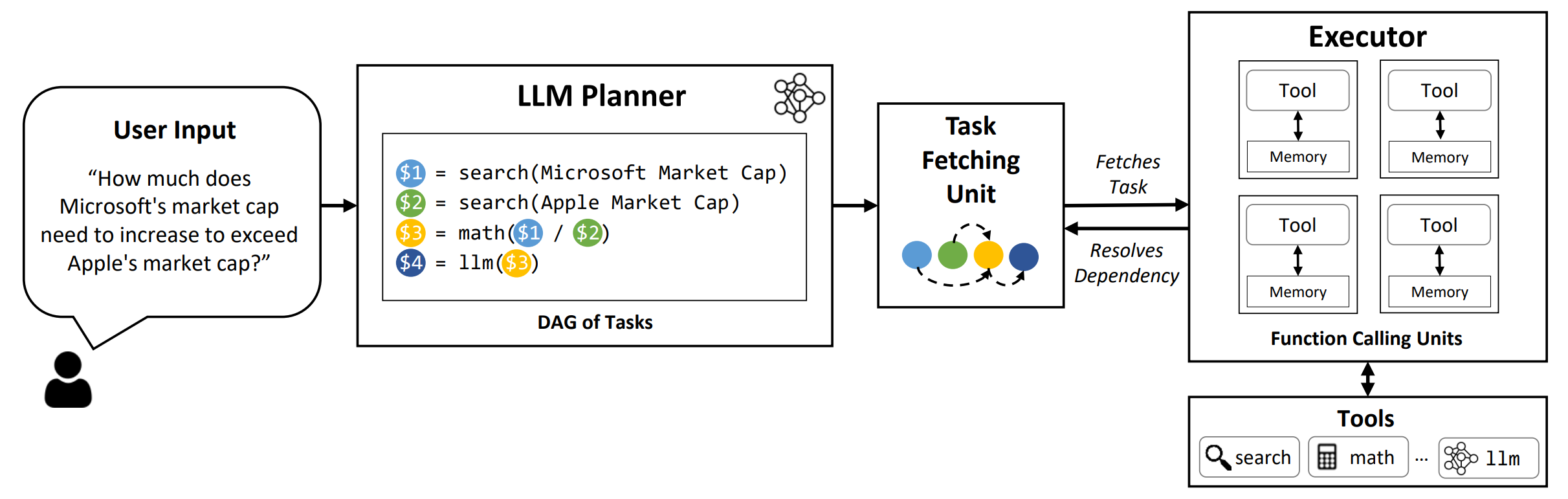

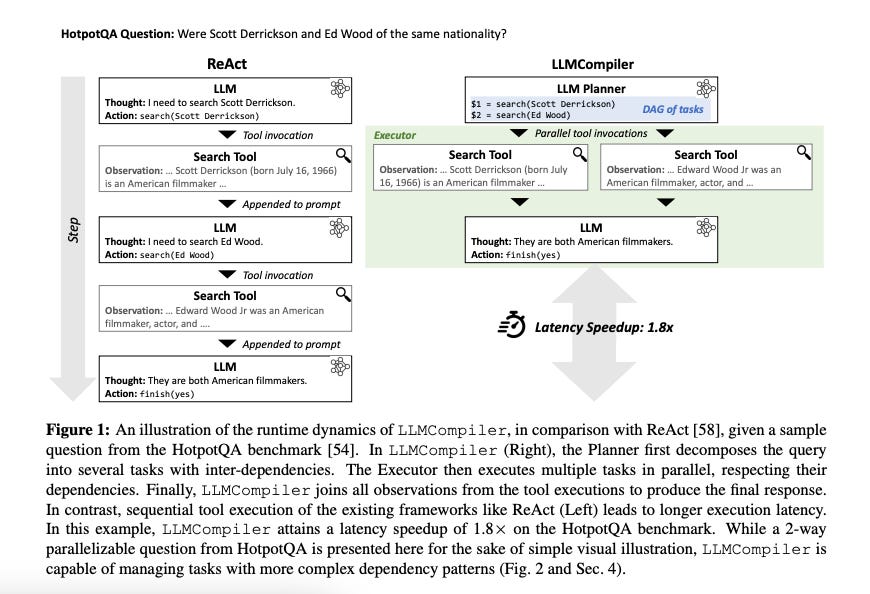

LLMCompiler是一个创新的框架,旨在实现大语言模型(LLMs)的高效并行函数调用。它通过自动识别可并行执行的任务和相互依赖的任务,来优化LLMs的函数调用过程。

核心特性

- 支持开源和闭源的LLM模型

- 自动分解问题并并行执行多个函数调用

- 显著提高延迟速度、降低成本、提升准确性

LLMCompiler通过以下三个关键组件实现并行函数调用:

- LLM规划器:识别执行流程

- 任务获取单元:并行分发函数调用

- 执行器:使用相关函数执行分发的任务

安装使用

- 创建conda环境:

conda create --name llmcompiler python=3.10 -y

conda activate llmcompiler

- 克隆仓库并安装依赖:

git clone https://github.com/SqueezeAILab/LLMCompiler

cd LLMCompiler

pip install -r requirements.txt

- 运行评估:

export OPENAI_API_KEY="sk-xxx"

python run_llm_compiler.py --benchmark {benchmark-name} --store {store-path} [--logging] [--stream]

更多详细用法请参考GitHub README。

主要优势

- 延迟加速:相比ReAct,在各数据集上实现了高达3.7倍的加速

- 成本节省:显著降低了运行成本

- 准确性提升:通过最小化中间函数调用输出的干扰,提高了准确性

学习资源

未来展望

LLMCompiler团队计划在近期更新以下特性:

- 论文中使用的Tree-of-Thoughts评估方法

LLMCompiler为LLM的实际应用提供了强大的工具,有望推动AI和机器学习技术向更强大、适应性更强、能够解决更复杂问题的方向发展。研究人员和开发者可以利用LLMCompiler来优化其LLM应用的性能和效率。

如果您发现LLMCompiler对您的工作有帮助,请考虑引用相关论文。