Local.ai:让AI在你的电脑上运行

在人工智能快速发展的今天,越来越多的人希望能够亲自体验和使用AI技术。然而,大多数AI服务都依赖于云端,这不仅需要持续的网络连接,还可能引发隐私和安全方面的担忧。Local.ai应运而生,它是一个创新的开源项目,旨在让用户能够在自己的电脑上本地运行AI模型,无需依赖云服务。

Local.ai的核心功能

Local.ai是一个功能丰富的桌面应用程序,主要包含以下核心功能:

-

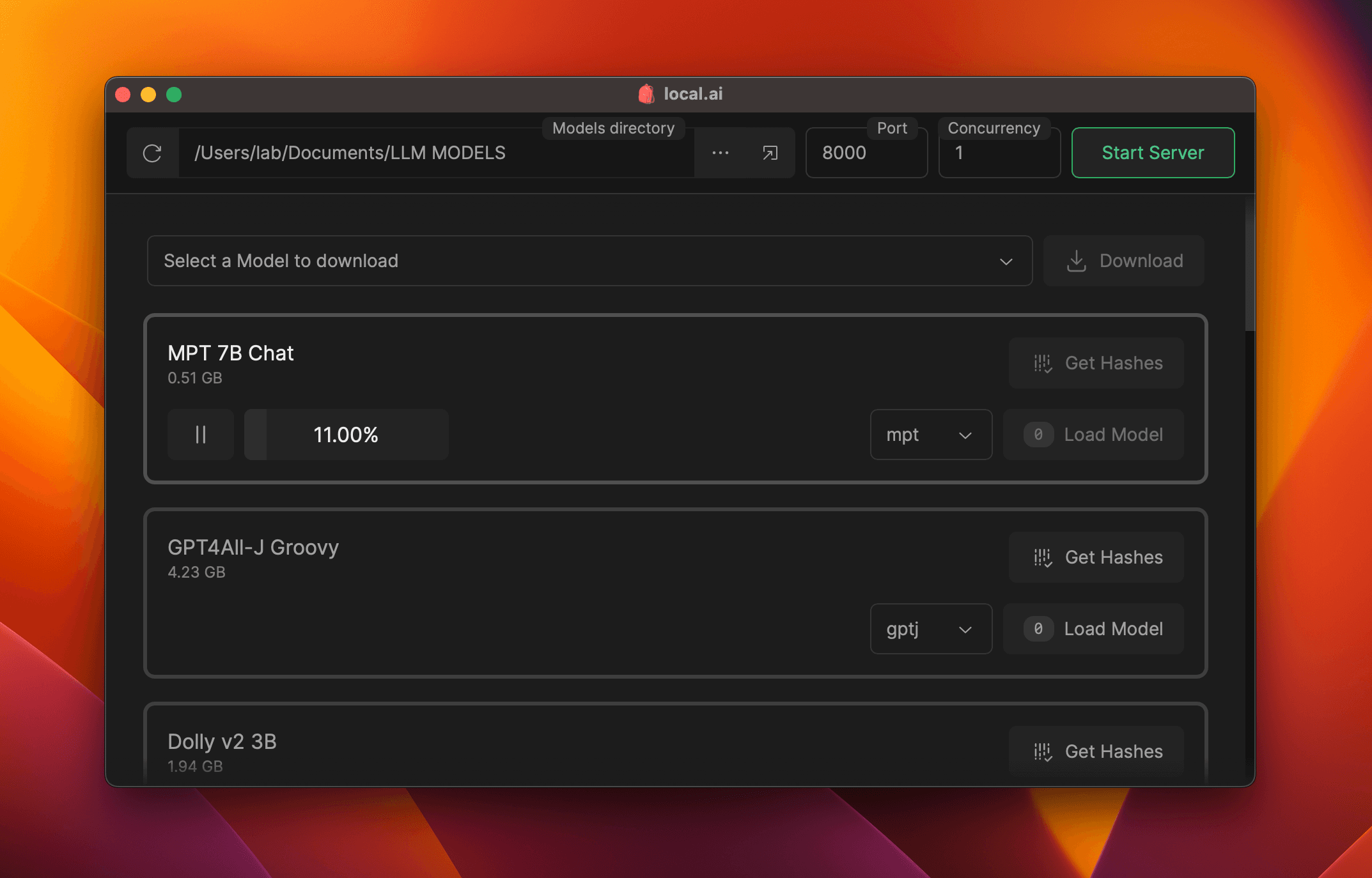

模型管理与下载: Local.ai提供了一个已知良好模型的API和模型下载器。用户可以轻松获取各种AI模型,并查看模型的详细信息,如推荐硬件规格、许可证和哈希值等。

-

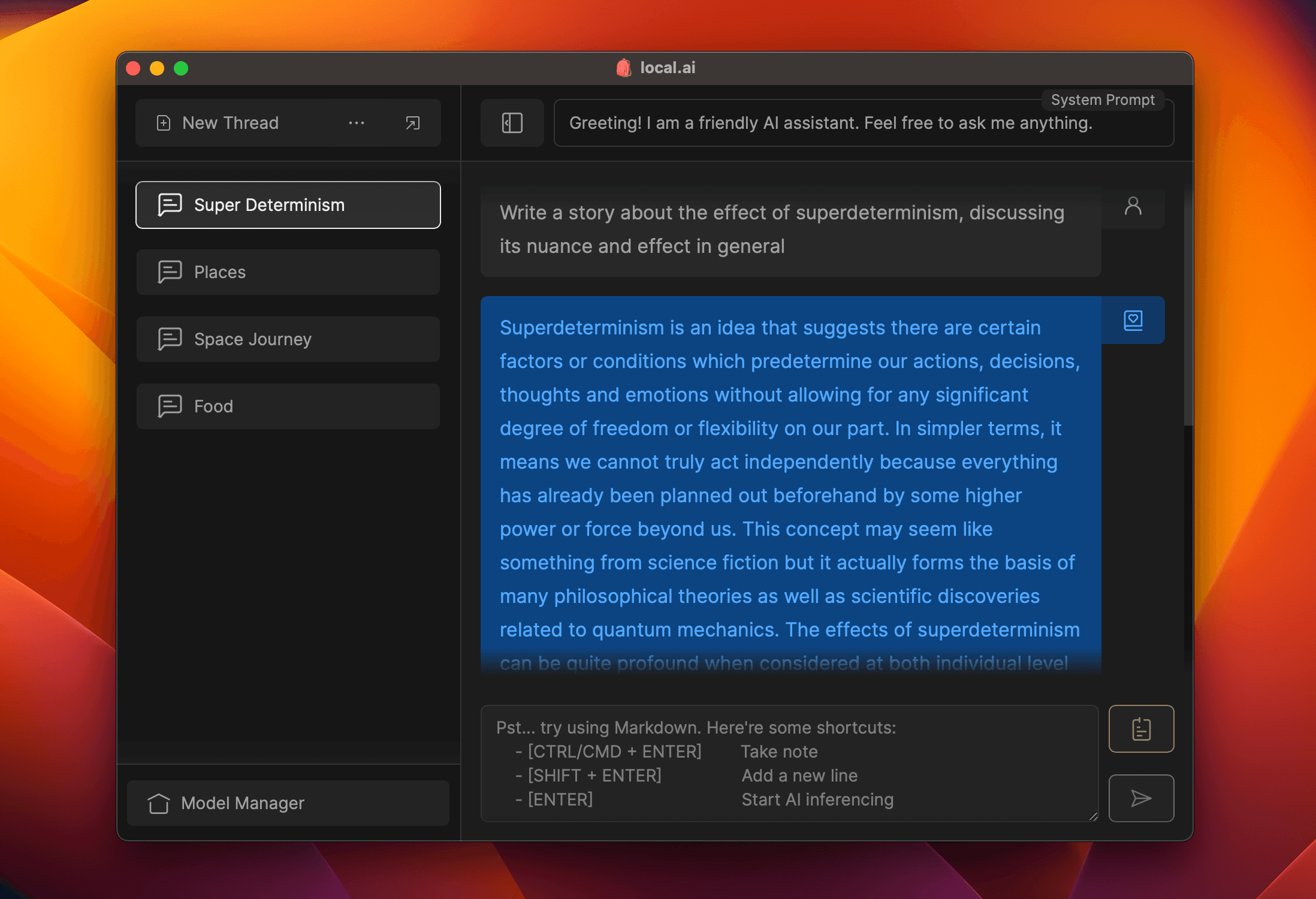

推理服务器: 用户只需点击两下就可以启动一个本地的流式推理服务器。这个服务器提供了类似OpenAI的API接口,使得开发者可以轻松地将本地AI集成到他们的应用中。

-

简单笔记应用: Local.ai内置了一个简单的笔记应用,每个笔记都可以单独配置推理参数。笔记和配置以纯文本的.mdx格式输出,方便用户管理和共享。

-

安全性和隐私: 由于所有处理都在本地进行,用户的数据始终保持在自己的控制之下,无需担心隐私泄露的风险。

技术特点

Local.ai在技术实现上有以下特点:

-

Rust后端: Local.ai使用Rust语言开发后端,这保证了应用的高效性和安全性。Rust的内存安全特性和高性能使得Local.ai能够在普通家用电脑上流畅运行。

-

CPU推理: Local.ai目前主要支持CPU推理,这意味着即使没有专业的GPU,用户也能运行大多数AI模型。系统会自动适应可用的CPU线程数,以优化性能。

-

多种量化支持: 为了在普通硬件上高效运行大型模型,Local.ai支持多种量化方法,包括q4、5.1、8和f16等。

-

跨平台兼容: Local.ai支持Windows、MacOS和Linux等主流操作系统,为不同平台的用户提供了一致的使用体验。

使用场景

Local.ai的设计理念使其适用于多种场景:

-

个人AI实验: 对AI感兴趣的个人用户可以使用Local.ai在自己的电脑上尝试各种AI模型,无需担心高昂的云服务费用。

-

隐私敏感的应用: 对于处理敏感数据的应用,如医疗诊断或金融分析,Local.ai提供了一个安全的本地AI解决方案。

-

离线环境: 在网络连接不稳定或完全离线的环境中,Local.ai依然能够正常工作,为用户提供AI能力。

-

开发者测试: AI应用开发者可以使用Local.ai快速测试他们的应用与AI模型的集成,而无需依赖外部API。

安装与使用

安装Local.ai非常简单:

- 访问Local.ai官网

- 根据您的操作系统选择相应的安装包下载

- 安装完成后,启动应用即可开始使用

对于开发者,Local.ai还提供了从源代码构建的选项。这需要安装Node.js、Rust和pnpm等开发工具。

社区与开源

Local.ai是一个活跃的开源项目,欢迎社区贡献:

- 项目使用GPLv3许可证,确保了衍生作品也将保持开源

- 在GitHub讨论区可以与其他用户和开发者交流

- 项目欢迎各种形式的贡献,包括文档、测试、代码等

未来展望

Local.ai团队正在积极开发新功能,未来计划包括:

- GPU推理支持,以提高大型模型的处理速度

- 并行会话功能,允许同时运行多个AI任务

- 更强大的模型管理功能,如嵌套目录、自定义排序和搜索等

- 模型探索器和推荐系统,帮助用户发现适合的模型

结语

Local.ai代表了AI技术民主化和去中心化的一个重要趋势。它让普通用户能够在自己的硬件上运行强大的AI模型,不仅提高了隐私和安全性,还为AI的创新应用开辟了新的可能性。随着项目的不断发展和社区的积极参与,我们可以期待Local.ai在未来为更多用户带来便捷、安全的本地AI体验。

无论你是AI爱好者、开发者,还是对隐私有特殊需求的用户,Local.ai都为你提供了一个值得尝试的开源解决方案。通过将AI的力量带到每个人的指尖,Local.ai正在帮助塑造一个更加开放、创新的AI生态系统。