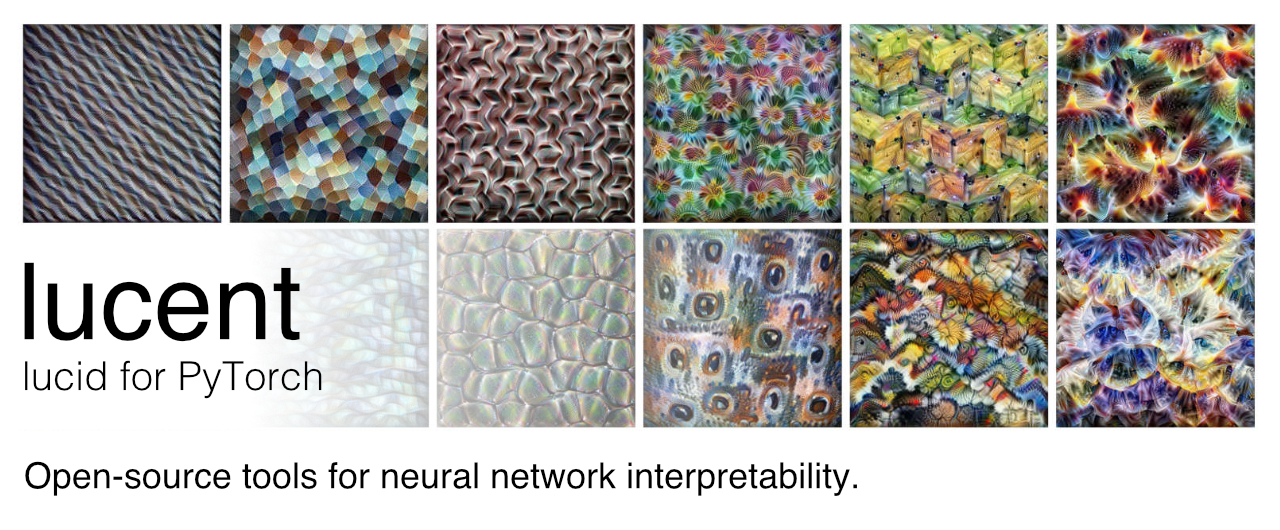

Lucent:神经网络可视化的新利器

在深度学习领域,神经网络的可解释性一直是一个备受关注的话题。随着模型复杂度的不断提高,如何理解和解释神经网络的内部工作机制变得越来越重要。在这样的背景下,Lucent应运而生,为研究人员和开发者提供了一个强大的神经网络可视化工具。

Lucent的诞生与发展

Lucent是由研究人员将TensorFlow平台上著名的Lucid库移植到PyTorch平台而开发的。它继承了Lucid的优秀特性,同时充分利用了PyTorch的灵活性和易用性。尽管Lucent与原始的Lucid团队或OpenAI的Clarity团队没有直接关联,但它的开发者表示,他们非常希望能够与这些团队合作。

Lucent目前仍处于预alpha阶段,但已经可以通过pip安装使用:

pip install torch-lucent

Lucent的核心功能

Lucent的主要功能是帮助研究人员和开发者可视化神经网络的内部表示。它提供了一系列工具和方法,使用户能够:

- 生成特征可视化

- 探索神经元激活

- 分析模型的决策过程

- 进行风格迁移实验

- 创建激活图集

这些功能使得Lucent成为研究神经网络内部工作机制的强大工具。

快速上手Lucent

为了让用户能够迅速上手,Lucent提供了一个简单的示例代码:

import torch

from lucent.optvis import render

from lucent.modelzoo import inceptionv1

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

model = inceptionv1(pretrained=True)

model.to(device).eval()

render.render_vis(model, "mixed4a:476")

这段代码展示了如何使用Lucent来可视化InceptionV1模型中特定层的神经元激活。

Lucent的教程和示例

为了帮助用户更好地理解和使用Lucent,开发团队提供了一系列详细的教程和示例notebook。这些资源涵盖了从基础入门到高级应用的各个方面:

这些教程不仅展示了Lucent的功能,还提供了实际应用的案例,帮助用户将理论知识转化为实践。

Lucent在神经网络解释性研究中的应用

Lucent在神经网络解释性研究中有着广泛的应用。以下是一些典型的研究方向:

-

特征可视化:通过生成能够最大化特定神经元或层激活的图像,研究者可以直观地了解网络在不同层次学习到的特征。

-

神经元交互:分析不同神经元之间的交互关系,揭示网络内部的信息处理机制。

-

模型决策过程分析:通过可视化技术,研究者可以追踪模型在做出特定决策时激活的关键神经元,从而理解模型的决策依据。

-

风格迁移研究:Lucent提供的风格迁移工具可以帮助研究者探索神经网络在艺术创作中的应用。

-

激活图集创建:通过生成大量神经元激活的可视化结果,研究者可以构建"激活图集",全面展示网络的内部表示。

Lucent的未来发展

尽管Lucent目前仍处于早期阶段,但它已经展现出了巨大的潜力。随着深度学习技术的不断发展,对神经网络可解释性的需求也在不断增加。Lucent作为一个开源工具,有望在未来得到更多研究者和开发者的关注和贡献。

未来,Lucent可能会在以下几个方面继续发展:

- 支持更多的预训练模型和架构

- 提供更高级的可视化技术

- 优化性能,提高可视化速度

- 增加与其他PyTorch生态系统工具的集成

- 开发更多针对特定领域(如医疗影像、自然语言处理)的可视化功能

结语

Lucent为神经网络可视化和解释性研究提供了一个强大而灵活的工具。无论是对于研究人员还是实践者,Lucent都提供了宝贵的洞察力,帮助我们更好地理解神经网络的内部工作机制。随着AI技术的不断发展,像Lucent这样的工具将在提高AI系统的透明度和可解释性方面发挥越来越重要的作用。

对于那些对神经网络可视化感兴趣的读者,不妨亲自尝试使用Lucent,探索神经网络的奥秘。同时,也欢迎有兴趣的开发者加入Lucent的开源社区,为这个项目贡献自己的力量。让我们共同努力,推动AI技术向着更加透明、可解释的方向发展。

🔗 相关链接:

📚 推荐阅读:

- Feature Visualization

- The Building Blocks of Interpretability

- Using Artificial Intelligence to Augment Human Intelligence

Lucent的出现无疑为神经网络可视化领域注入了新的活力。让我们期待它在未来能够为AI的发展做出更多贡献,帮助我们揭开神经网络的神秘面纱。