MACE: 一种创新的大规模概念消除框架

MACE: 扩散模型中的大规模概念消除

随着大规模文本到图像扩散模型的迅速发展,人们对其可能被滥用于创建有害或误导性内容的担忧也日益增长。为了应对这一挑战,研究人员提出了一种名为MACE(Mass Concept Erasure)的创新框架,旨在防止模型生成包含不需要概念的图像。

MACE的突破性创新

MACE框架在概念消除任务上取得了显著突破:

-

大规模消除能力: 与现有方法相比,MACE能够同时消除多达100个概念,大大扩展了概念消除的范围。

-

泛化性与特异性的平衡: MACE成功在消除概念同义词(泛化性)和保留无关概念(特异性)之间找到了有效平衡。

-

创新技术组合:

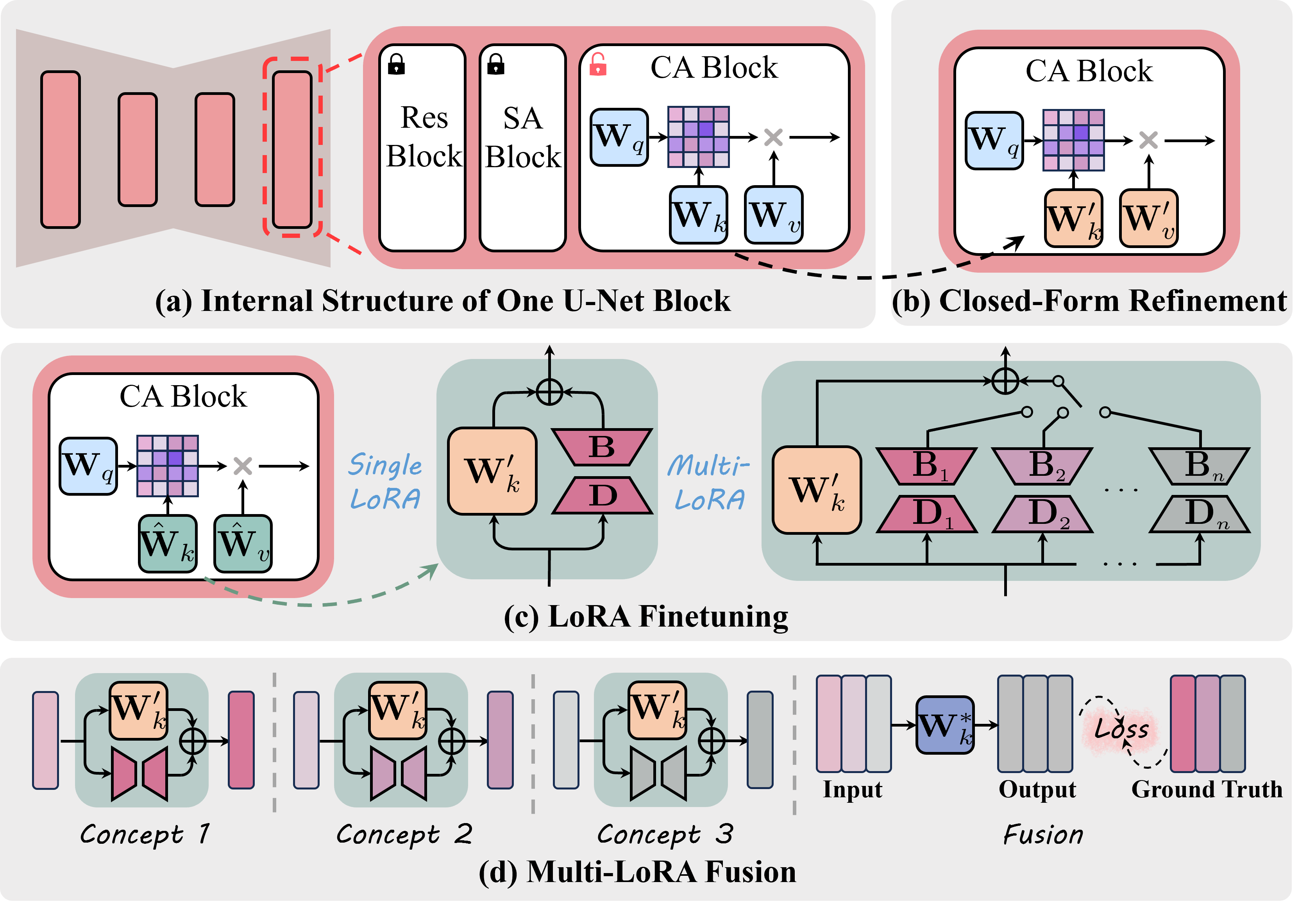

- 利用封闭形式的交叉注意力细化

- 结合LoRA微调

- 这些技术共同作用,有效消除了不需要概念的信息

-

多个LoRA的无干扰集成: MACE能够集成多个LoRA模块而不会相互干扰,避免了灾难性遗忘问题。

MACE的工作原理

MACE框架的核心思想是通过精细调整扩散模型中的关键组件来实现概念消除:

-

交叉注意力块的优化:

- 重点调整交叉注意力(CA)块中与提示相关的投影矩阵

- 使用封闭形式解决方案细化预训练U-Net的CA块

- 防止模型将目标短语的残余信息嵌入到周围单词中

-

LoRA模块的应用:

- 为每个需要移除的概念学习一个独特的LoRA模块

- 这些模块专门用于消除概念的内在信息

-

多LoRA模块的集成:

- 引入封闭形式解决方案

- �实现多个LoRA模块的无干扰集成

- 避免灾难性遗忘问题

MACE的实际应用

MACE框架在多个具有挑战性的任务中展现出优异性能:

- 物体消除: 从生成的图像中移除特定物体

- 名人消除: 防止生成特定名人的图像

- 露骨内容消除: 过滤不适当或敏感内容

- 艺术风格消除: 移除特定的艺术风格

在所有这些任务中,MACE都优于现有方法,展示了其强大的通用性和有效性。

MACE的实现和使用

研究团队提供了MACE的官方实现,使得其他研究者和开发者能够轻松使用和扩展这一框架:

-

环境设置:

- 创建conda环境

- 安装必要的依赖,如PyTorch、Diffusers等

-

数据准备:

- 为每个需要消除的概念生成8张图像及其分割掩码

- 使用提供的脚本进行数据准备

-

模型训练:

- 配置训练参数

- 使用提供的训练脚本进行MACE模型的微调

-

推理和采样:

- 使用微调后的模型生成图像

- 提供了单图生成和批量生成的脚本

-

预训练模型:

- 研究团队发布了多个针对不同任务微调的Stable Diffusion v1.4模型

- 这些模型可直接用于概念消除任务

MACE的评估指标

为了全面评估MACE的性能,研究团队采用了多种评估指标:

- FID (Fréchet Inception Distance): 评估生成图像的质量和多样性

- CLIP分数: 衡量图像与文本提示的匹配程度

- CLIP分类准确率: 评估概念消除的效果

- GCD (Generic Celebrity Detection)准确率: 专门用于评估名人消除任务

- NudeNet检测结果: 用于评估露骨内容消除的效果

研究团队提供了详细的评估脚本,使得其他研究者能够复现和比较结果。

MACE的意义和影响

MACE框架的提出对AI生成内容的安全性和可控性具有重要意义:

-

增强AI系统安全性: 通过大规模概念消除,可以更好地控制AI系统生成的内容,降低潜在风险。

-

提高模型可控性: MACE为开发者提供了一种精细调整模型输出的方法,增强了AI系统的可控性。

-

推动伦理AI发展: 通过消除不当或有害概念,MACE有助于构建更加负责任和符合伦理的AI系统。

-

促进AI技术创新: MACE的创新方法为AI模型调整和优化开辟了新的研究方向。

-

应用场景广泛: 从内容审核到个性化AI服务,MACE的应用前景十分广阔。

结语

MACE框架的提出标志着扩散模型安全应用的一个重要里程碑。通过实现大规模概念消除,MACE不仅增强了AI系统的安全性和可控性,还为构建更加负责任的AI技术铺平了道路。随着这一技术的进一步发展和应用,我们可以期待看到更多安全、可控且创新的AI生成内容应用。

参考文献

如果您发现MACE对您的研究有帮助,请考虑引用以下论文:

@article{lu2024mace,

title={MACE: Mass Concept Erasure in Diffusion Models},

author={Lu, Shilin and Wang, Zilan and Li, Leyang and Liu, Yanzhu and Kong, Adams Wai-Kin},

journal={arXiv preprint arXiv:2403.06135},

year={2024}

}

通过持续的研究和改进,MACE有望在未来为AI生成内容的安全性和可控性带来更多突破性进展。

编辑推荐精选

讯飞智文

一键生成PPT和Word,让学习生活更轻松

讯飞智文是一个利用 AI 技术的项目,能够帮助用户生成 PPT 以及各类文档。无论是商业领域的市场分析报告、年度目标制定,还是学生群体的职业生涯规划、实习避坑指南,亦或是活动策划、旅游攻略等内容,它都能提供支持,帮助用户精准表达,轻松呈现各种信息。

讯飞星火

深度推理能力全新升级,全面对标OpenAI o1

科大讯飞的星火大模型,支持语言理解、知识问答和文本创作等多功能,适用于多种文件和业务场景,提升办公和日常生活的效率�。讯飞星火是一个提供丰富智能服务的平台,涵盖科技资讯、图像创作、写作辅助、编程解答、科研文献解读等功能,能为不同需求的用户提供便捷高效的帮助,助力用户轻松获取信息、解决问题,满足多样化使用场景。

Spark-TTS

一种基于大语言模型的高效单流解耦语音令牌文本到语音合成模型

Spark-TTS 是一个基于 PyTorch 的开源文本到语音合成项目,由多个知名机构联合参与。该项目提供了高效的 LLM(大语言模型)驱动的语音合成方案,支持语音克隆和语音创建功能,可通过命令行界面(CLI)和 Web UI 两种方式使用。用户可以根据需求调整语音的性别、音高、速度等参数,生成高质量的语音。该项目适用于多种场景,如有声读物制作、智能语音助手开发等。

Trae

字节跳动发布的AI编程神器IDE

Trae是一种自适应的集成开发环境(IDE),通过自动化和多元协作改变开发流程。利用Trae,团队能够更快速、精确地编写和部署代码,从而提高编程效率和项目交付速度。Trae具备上下文感知和代码自动完成功能,是提升开发效率的理想工具。

咔片PPT

AI助力,做PPT更简单!

咔片是一款轻量化在线演示设计工具,借助 AI 技术,实现从内容生成到智能设计的一站式 PPT 制作服务。支持多种文档格式导入生成 PPT,提供海量模板、智能美化、素材替换等功能,适用于销售、教师、学生等各类人群,能高效制作出高品质 PPT,满足不同场景演示需求。

讯飞绘文

选题、配图、成文,一站式创作,让内容运营更高效

讯飞绘文,一个AI集成平台,支持写作、选题、配图、排版和发布。高效生成适用于各类媒体的定制内容,加速品牌传播,提升内容营销效果。

材料星

专业的AI公文写作平台,公文写作神器

AI 材料星,专业的 AI 公文写作辅助平台,为体制内工作人员提供高效的公文写作解决方案。拥有海量公文文库、9 大核心 AI 功能,支持 30 + 文稿类型生成,助力快速完成领导讲话、工作总结、述职报告等材料,提升办公效率,是体制打工人的得力写作神器。

openai-agents-python

OpenAI Agents SDK,助力开发者便捷使用 OpenAI 相关功能。

openai-agents-python 是 OpenAI 推出的一款强大 Python SDK,它为开发者提供了与 OpenAI 模型交互的高效工具,支持工具调用、结果处理、追踪等功能,涵盖多种应用场景,如研究助手、财务研究等,能显著提升开发效率,让开发者更轻松地利用 OpenAI 的技术优势。

Hunyuan3D-2

高分辨率纹理 3D 资产生成

Hunyuan3D-2 是腾讯开发的用于 3D 资产生成的强大工具,支持从文本描述、单张图片或多视角图片生成 3D 模型,具备快速形状生成能力,可生成带纹理的高质量 3D 模型,适用于多个领域,为 3D 创作提供了高效解决方案。

3FS

一个具备存储、管理和客户端操作等多种功能的分布式文件系统相关项目。

3FS 是一个功能强大的分布式文件系统项目,涵盖了存储引擎、元数据管理、客户端工具等多个模块。它支持多种文件操作,如创建文件和目录、设置布局等,同时具备高效的事件循环、节点选择和协程池管理等特性。适用于需要大规模数据存储和管理的场景,能够提高系统的性能和可靠性,是分布式存储领域的优质解决方案。

推荐工具精选

AI云服务特惠

懂AI专属折扣关注微信公众号

最新AI工具、AI资讯

独家AI资源、AI项目落地

微信扫一扫关注公众号